I N I T I A T I O N

AUX PHENOMENES

RADIO-ELECTRIQUES

------- 6ème édition, 1935 -------

Etienne CHIRON, éditeur, 40, Rue de Seine - PARIS (6e)

Numérisation et mise en page, Pascal Chour - 2012

AVANT-PROPOS

Est-il possible de comprendre le mécanisme des phénomènes mis en jeu dans la radiotéléphonie, sans avoir recours aux abstractions mathématiques ? Peut-on imaginer ce qui se passe dans un tube à plusieurs électrodes, comment se comporte un circuit oscillant, la membrane d’un haut-parleur ? Est-il possible de saisir le rôle d’un transformateur de moyenne fréquence ?

Je crois qu’on peut répondre affirmativement à toutes ces questions. Bien mieux, je crois, sans paradoxe, qu’il est préférable, pour le but cherché, de ne pas avoir recours au calcul différentiel et intégral.

Loin de moi la pensée de nier l’utilité de la Physique mathématique. C’est, au contraire, une branche scientifique dont l’importance croît chaque jour.

Mais, mon ambition n’est point de faire des découvertes.

Je n’espère point que les détours d’un savant calcul me conduiront vers une solution nouvelle de la reproduction idéale. Le problème qui se pose est le suivant :

Voici un récepteur à cinq tubes. On y branche un collecteur d’ondes d’une part, et, d’autre part, on le relie au secteur électrique. Comme résultat, il donne de la musique. Les vibrations acoustiques initiales ont été produites à l’Opéra de Vienne... Comment cet effet admirable a-t-il pu se réaliser ? Faut-il, comme beaucoup, admettre tout simplement que c’est un miracle et rendre grâce au Dieu des physiciens ? Ou peut-on espérer, au contraire, avoir une idée exacte des phénomènes qui sont intervenus entre le moment où le ténor a poussé son contre-ut de poitrine et celui où des oreilles ont pu, à mille kilomètres de là, mais dans le même dixième de seconde, entendre une copie fidèle du son original ?

Quel individu hésiterait un seul instant entre les deux attitudes ?

Or, je le répète, on peut traiter ce problème de deux façons différentes.

La première consistera à poser des équations : -étant donné que le champ électrique, à telle distance, est de X microvolts par mètre, étant donnée la hauteur effective de l’antenne A, les constantes du premier circuit oscillant L, C, R, la fréquence des oscillations à recevoir F, etc...

Ainsi, on arrivera logiquement, après avoir noirci des pages et des pages de calculs et de signes cabalistiques, à la démonstration cherchée.

Notons, en passant, que cette solution ne sera pas rigoureusement mathématique. Les phénomènes physiques ne veulent pas toujours épouser exactement les contours d’une équation. Il faut bien les simplifier, les amputer d’un détail dont parfois on ignore l’importance...

Et puis, en admettant que nous arrivions tout au bout du chemin, aurons-nous vraiment une idée exacte des phénomènes ? Certes, non. Lorsque nous serons devant un appareil complet, nous demeurerons incapables de le régler ou de le réparer s’il cesse de fonctionner.

Ce n’est point en appliquant une formule quelconque qu’on peut déterminer qu’un condensateur de découplage est en court-circuit ou qu’un bobinage est coupé.

Pour arriver à cela, il faut suivre une méthode logique, et avoir, naturellement, une espèce de flair...

Il faut, en quelque sorte, « sentir » pratiquement comment fonctionne l’appareil.

Et c’est la seconde solution qui nous permettra d’acquérir ce sentiment exact du fonctionnement d’un appareil...

Que sera donc cette seconde solution ?

Elle consistera à ne pas dissimuler les faits derrière des abstractions, mais à les mettre, au contraire, en pleine lumière... La Radio, comme l’Electricité, c’est la science de l’Electron. Il faut partir avec l’électron et ne point le quitter. Pour résoudre le problème posé, il suffira de suivre la danse des électrons, depuis le courant microphonique jusqu’au courant téléphonique final.

Bien entendu, dans un ouvrage comme celui que nous commençons, il est impossible de remonter au déluge. Certaines connaissances en Electricité sont indispensables. Pour ceux de nos lecteurs à qui ces rudiments font défaut ou sont reculés trop loin dans leurs souvenirs, nous écrivons un autre ouvrage également simple : L’Electricité sans mathématiques.

La publication de ce livre aura lieu dans un délai assez bref.

Revenons à « La T. S. F. sans mathématiques ». Ce livre est spécialement dédié aux lecteurs de « La T.S.F. pour Tous ». Il n’a pas la prétention d’apprendre du nouveau aux Professeurs de Faculté et aux Elèves de la Section Radio à l’Ecole Supérieure d’Electricité. Cependant, je ne suis pas bien sûr que ces derniers ne puissent, parfois, en tirer un certain enseignement... Il y a souvent un fossé assez large entre les possibilités du calcul et celles de la pratique. On peut savoir établir un savant projet de stations d’émission de 200 kilowatts-antenne et patauger lamentablement devant un étage de haute fréquence qui « accroche » ou, au contraire, une oscillatrice qui refuse impitoyablement « d’accrocher »...

Ce livre est écrit pour tous ceux qui veulent savoir ce qu’ils font quand ils manœuvrent le bouton du potentiomètre d’un^ récepteur, ou pour quelles raisons Londres Régional, à peu près inaudible dans la matinée, devient plus puissant que la station locale quand le soleil est couché.

Ce livre s’adresse à des amateurs ou à des auditeurs de T. S. F., aussi bien aux « bricoleurs » qu’aux autres. C’est pourquoi je serai parfois amené à suivre, dans l’exposé de ces chapitres, un ordre apparemment arbitraire, mais qui aura l’avantage de faciliter la compréhension. Il me faut bien supposer que mes auditeurs savent ce que c’est qu’un haut-parleur ou une antenne, dès le premier chapitre de mon ouvrage. Cela ne m’empêchera pas, d’ailleurs, de revenir sur ces questions par la suite.

CHAPITRE PREMIER

Entre l'émetteur et le récepteur.

La Téléphonie sans fil, comme la Radiotélégraphie, est une application des propriétés du Rayonnement électromagnétique.

Quelque part, il y a l'antenne du poste émetteur et, ailleurs, il y a le collecteur d'ondes de l'appareil récepteur. Ce dernier recueille des vibrations électriques semblables à celles qui parcouraient l'antenne d'émission. Il y a donc un lien entre les deux antennes. Le lien invisible, c'est le rayonnement électromagnétique; ce sont, en d'autres termes, les ondes hertziennes.

Il ne faut pas croire que les deux termes « ondes hertziennes » et « rayonnement électromagnétique » soient deux expressions différentes désignant la même chose.

Les premières ne sont qu'un cas particulier du second.

Le rayonnement électromagnétique.

Les rayons X, les rayons ultra-violets, la lumière visible, depuis le violet jusqu'au rouge, les rayons infrarouges, les ondes ultra-courtes, les ondes courtes, les ondes moyennes, les ondes longues sont des manifestations, à nos yeux différentes, du rayonnement électromagnétique.

En fait, entre tous ces rayons ou ces ondes, il n'y a aucune différence de qualité; il y a seulement des différences de fréquence...

Ainsi, la lumière d'une bougie ou l'onde émise par l'antenne de Radio-Paris sont des mêmes phénomènes, qui se produisent à des fréquences différentes.

Alors qu'à la jaune lumière de la bougie on peut faire correspondre la fréquence fantastique de cinq cent mille milliards de vibrations par seconde, l'émission de Radio-Paris ne correspond qu'à la fréquence de 182.000 vibrations par seconde. On peut, d'ailleurs, trouver ce dernier chiffre encore respectable...

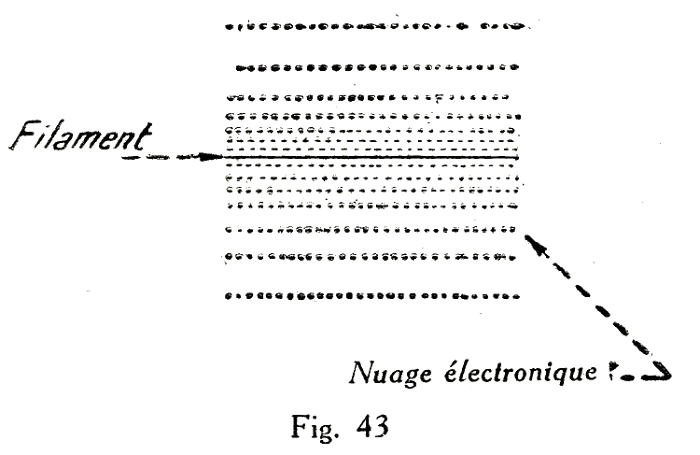

A la recherche de l'électron.

On dit qu'un conducteur est le siège d'un courant électrique lorsque, par un moyen quelconque, on est parvenu à donner un mouvement d'ensemble aux électrons libres du métal.

Les atomes qui composent le conducteur sont constitués par un noyau central (ou proton) positivement électrisé, autour duquel gravite un essaim d'électrons, négativement électrisés. La charge positive du noyau est égale à la somme des charges négatives des électrons, si bien que l'atome est électriquement neutre.

L'ensemble constitue une sorte de système solaire en miniature dont le proton est le soleil et les électrons les planètes. Les dimensions de l'ensemble sont inimaginablement réduites. Les plus puissants microscopes ne pourront jamais nous permettre de voir l'atome.

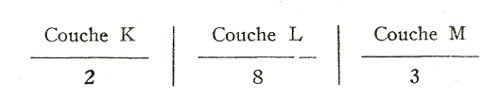

Les orbites électroniques ne sont pas disposées au hasard. En partant du centre, on trouve d'abord la « couche K », sur laquelle gravitent deux électrons (Sauf pour l'atome d'hydrogène, le plus simple des atomes, qui n'a qu'un seul électron. La couche M comporte au maximum huit électrons, répartis régulièrement à la surface d'une sphère). Puis les couches L, M, N. etc...

Le nombre total d'électrons planétaires et le noyau central définissent la nature du corps. C'est ainsi que l'aluminium comporte treize électrons.

Le plomb comporte 82 électrons. Il serait fastidieux d'en définir l'arrangement.

Corps conducteurs et corps isolants.

Nous pouvons figurer l'atome d'aluminium comme indiqué figure 1.

On peut remarquer que les électrons planétaires ont toujours une forte tendance à s'assembler par 8.

D'autre part, les orbites périphériques peuvent provisoirement s'enrichir ou s'appauvrir en électrons. Le corps ne présente pas pour cela un changement de nature, puisque le noyau demeure inchangé. Il peut, cependant, acquérir des propriétés particulières.

Si un corps possède six ou sept électrons périphériques, il cherchera à en capter deux ou un pour compléter la couche extérieure. Ce sera un corps isolant.

Si, au contraire, la couche périphérique ne contient qu'un ou deux électrons, l'atome les laissera partir facilement. Ce sera un corps conducteur.

Les sauts d'électrons.

Dans un corps, comme l'aluminium, les électrons périphériques sont très mobiles. Ils sautent d'une orbite extérieure sur l'orbite extérieure d'un autre atome, parfois relativement éloigné... Il y a, dans le sein des atomes un échange continuel d'électrons, dans tous les sens.

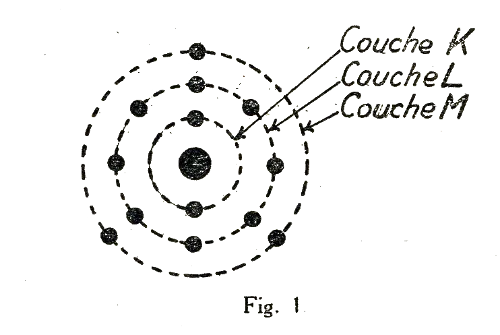

Une section quelconque d'un corps conducteur (fig. :2) sera traversée, à chaque moment, par des électrons migrateurs. Si nous avions le moyen de compter les passages, nous trouverions qu'à chaque moment le nombre d'électrons qui va dans un sens est égal à celui qui va dans l'autre sens. Les sauts d'électrons sont parfaitement irréguliers.

Mais, en vertu même de cette irrégularité complète, le résultat statistique c'est qu'il y a autant de sauts dans un sens que dans l'autre. Pour trouver une différence, il faudrait faire l'observation pendant un temps extraordinairement réduit.

Il importe de bien comprendre les conséquences de cette observation. Les passages d'électrons dans les deux sens sont égaux à notre échelle vitale. Pour nous, une durée d'un millième de seconde est un temps négligeable. Or, il faudrait encore réduire formidablement cette durée pour qu'une irrégularité puisse apparaître.

Le courant électrique.

Si, par un procédé quelconque, nous trouvons le moyen de faire apparaître une irrégularité mesurable nous produisons le courant électrique.

Il faut bien préciser qu'il s'agit seulement de la moyenne des passages. S'il y a courant électrique, il y aura encore des passages dans les deux sens, mais notre observateur idéal notera qu'il y a régulièrement plus de passages dans un sens que dans l'autre.

Pour raisonner sur le courant électrique on peut, en fait, négliger l'agitation irrégulière pour ne tenir compte que du déplacement régulier. On a ainsi une image plus nette des faits et l'erreur que l'on commet est tout à fait inappréciable pour les temps normalement mesurables.

En définitive, on peut donc dire qu'un conducteur, parcouru par un courant électrique, est traversé par une procession régulière d'électrons. Le nombre d'électrons qui traverse une section du conducteur en un temps donné donne une mesure de l'intensité de courant.

Actions du courant.

Le conducteur traversé par la procession électronique devient le siège d'une série de phénomènes bien connus. Par exemple, il s'échauffe d'une manière facilement mesurable et, autour de lui, existent un champ électrique et un champ magnétique.

Le champ électrique peut être mis en évidence par son action sur les corps légers. On peut, par exemple, provoquer l'attraction d'une balle de moelle de sureau.

Le champ magnétique provoque l'attraction ou la répulsion d'une aiguille aimantée.

Courant alternatif.

Nous avons implicitement supposé un mouvement d'ensemble régulier communiqué à l'armée des électrons. Cela veut dire que le mouvement est uniforme, comme celui des molécules d'eau dans une conduite cylindrique pour un débit de un litre la seconde, par exemple.

Si nous découpons le temps en fractions régulières de un millième de seconde, notre observateur idéal notera que, dans chaque millième de seconde, une section du conducteur est traversée par un nombre régulier d'électrons.

Mais on peut aussi imaginer qu'au lieu de ce mouvement uniforme, correspondant au courant continu, on puisse communiquer aux électrons un mouvement vibratoire.

Chaque électron aura, en quelque sorte, une position d'équilibre autour de laquelle il oscillera avec une amplitude quelconque.

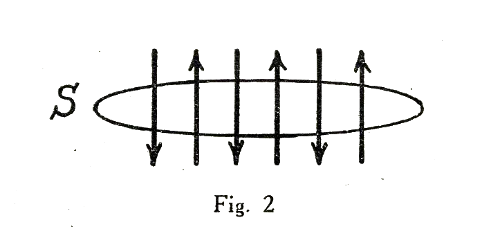

On peut se faire une image exacte d'un mouvement vibratoire en examinant le mouvement d'une simple balançoire ou d'un balancier de pendule. Lorsqu'on écarte le corps pesant de sa position d'équilibre, la pesanteur tend à l'y ramener. Dès que le corps est écarté du point B (fig. :3), il tend à y revenir en suivant naturellement la trajectoire indiquée en pointillé. Il part d'une vitesse nulle pour arriver au point d'équilibre B avec une vitesse maximum. En effet, dès qu'il a dépassé ce point, il est ralenti par l'influence de la pesanteur. Mais, emporté par sa vitesse, il atteint le point C, où il s'arrête un instant, avant de repartir vers B avec une vitesse accélérée et remonter jusqu'au voisinage du point A. S'il n'y avait point les frottements de diverses natures, il oscillerait éternellement entre A et C ou, si l'on veut, entre un état de repos et un état de vitesse maximum.

On peut communiquer aux électrons du conducteur un mouvement comparable. Ils partent d'un état d'équilibre avec une certaine vitesse. A mesure qu'ils s'éloignent de la position d'équilibre, une force retardatrice de plus en plus grande se fait sentir et, bientôt, ils sont contraints de s'arrêter pour repartir en sens inverse. Ils repassent par la position d'équilibre avec une vitesse maximum, mais dans l'autre sens

Mais que deviennent, dans tout cela, le champ magnétique et le champ électrique ? Ils accompagnent évidemment l'électron dans ses voyages à la recherche d'un insaisissable équilibre...

Et, de même qu'on dira que le conducteur est le siège d'un courant alternatif, de même dira-t-on que les champs magnétiques et électriques sont alternatifs.

Mais il convient, ici, d'examiner les choses avec une attention beaucoup plus grande.

Vitesse de propagation.

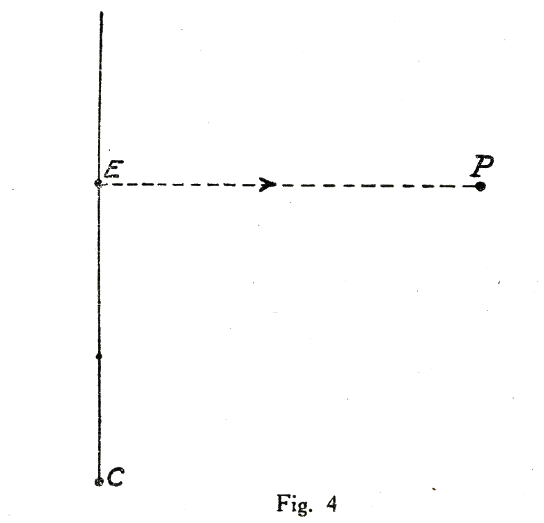

Imaginons un conducteur C et, quelque part dans ce conducteur, un électron E que, pour l'instant, nous supposons immobile (fig. :4).

Nous installons, à une certaine distance du point E, notre observateur idéal P. Ce parangon des serviteurs est chargé, maintenant, de déceler les champs magnétiques. Nous l'avons muni des instruments de mesure indispensables.

A un signal donné, nous mettons en mouvement l'électron E. Il y aura production d'un champ magnétique. Et nous pourrons observer ce fait important que la transmission du champ magnétique, depuis E jusqu'à P, demande un certain temps... Oh, sans doute, un temps bien court, mais tel, cependant, qu'il soit mesurable à l'aide des admirables méthodes de la physique moderne !

La connaissance de ce temps et de la distance E. P. nous permet de déterminer la vitesse de propagation et nous observerons, avec une certaine surprise, que c'est précisément la vitesse de la lumière, c'est-à-dire sensiblement 300.000 kilomètres par seconde.

Le fait du rayonnement électromagnétique.

Supposons, maintenant, que nous communiquions à l'électron un mouvement alternatif rapide autour du point E. Les oscillations du champ magnétique au point P vont suivre naturellement le même rythme. Mais ces oscillations du champ accuseront un certain retard par rapport à celles de l'électron.

En un instant donné, le champ magnétique décelable en P correspondra à une position de E différente de celle qu'il occupe réellement au moment considéré. Ce retard va d'ailleurs être variable, puisqu'il y a des variations considérables dans la vitesse de déplacement de E.

E est, en effet, tantôt immobile ou possède, au contraire, une vitesse maximum.

On conçoit qu'il puisse en résulter des phénomènes au point P. Or, ces phénomènes sont, précisément, ceux du rayonnement électromagnétique.

Ces phénomènes seront, en particulier, très marqués, si, pendant le temps de propagation de E en P, l'électron E a pu osciller plusieurs fois...

Si l'on essaie d'imaginer les lignes de forces qui vont de E à P, on constate qu'elles sont régulièrement enchevêtrées et que cette régularité affecte elle-même l'allure d'une vibration... Et cette vibration, qui se propage, elle aussi, avec la vitesse de la lumière, est précisément le rayonnement électromagnétique.

Le rayonnement à une certaine distance.

La simple figure 4 ne nous a pas livré encore tous ses secrets.

Cherchons plus avant. Au voisinage de E le rayonnement sera faible, car on admettra facilement que le « retard » dû à la propagation sera négligeable. Cet effet sera d'autant plus net que la vitesse d'oscillation de E sera plus faible. Nous ne pourrons guère mettre l'effet « rayonnement » en évidence avec des fréquences comme celles des courants alternatifs. Il n'en est pas moins vrai que cet effet existe.

Au contraire, l'effet « rayonnement » deviendra de plus en plus facile à mettre en évidence à mesure que la fréquence de l'oscillation E deviendra plus grande.

Avec les courants alternatifs industriels — correspondant à cinquante périodes par seconde — l'effet « rayonnement » ne pourrait être mis en évidence qu'à plusieurs milliers de kilomètres du point E. Or, ce rayonnement étant très faible... Il est, en fait, absolument indiscernable avec les moyens actuels... Lorsque les fréquences dépassent 10.000 périodes par seconde, on arrive dans la zone des ondes hertziennes utilisables. L'effet « rayonnement » devient facile à mettre en évidence.

La longueur d'onde.

Puisque ce rayonnement se propage avec une vitesse que l'on connaît et que, d'autre part, on peut lui faire correspondre une fréquence bien définie, il devient possible de définir une caractéristique qu'on nomme la longueur d'onde.

Cette longueur d'onde est le chemin parcouru par le rayonnement pendant une oscillation complète.

La période et la fréquence.

Une oscillation complète, ou période, correspond au temps qui s'écoule entre deux passages de l'électron au point E, dans le même sens. Si nous reprenons l'exemple plus courant du pendule (fig. :3), nous définirons la « période » comme suit : Le mobile part de B pour s'en aller en A, puis de A il revient vers B. La durée écoulée est la demi-période, car, à ce moment, le passage en B a lieu dans l'autre sens. Il continue jusqu'en C, puis revient en B. A ce moment, le temps passé est la période.

On peut aussi, plus simplement, compter les temps égaux qui s'écoulent entre deux passages successifs aux points d'élongation maximum A ou C.

La fréquence, c'est le nombre de périodes par seconde.

Puisque le rayonnement parcourt 300.000 kilomètres ou 300.000.000 de mètres par seconde, il est clair que la longueur d'onde en mètres est obtenue en divisant tout simplement 300.000.000 par la fréquence. Cela découle d'une simple règle de trois.

Rayonnement et induction.

On sait qu'un courant électrique variable peut donner naissance à un autre courant électrique dans un circuit voisin, quand certaines conditions sont réalisées. Il y a là un « effet à distance » qu'on a souvent confondu avec le rayonnement électromagnétique. C'est une grosse erreur. Il nous est impossible d'entrer dans les détails de ce problème. Nous devons cependant mettre en garde nos lecteurs contre cette confusion fâcheuse.

Il y a induction au voisinage même de la station d'émission. Ce qu'on pourrait appeler le champ magnétique pur est prépondérant. Par l'expression « voisinage même », il faut entendre une distance de l'antenne de l'ordre ou inférieure à une longueur d'onde. Et ceci découle d'un raisonnement établi plus haut.

On peut donc admettre qu'il y a induction dans un rayon de 1 km. 5 autour de l'Antenne de Radio-Paris. Au-delà seule la composante « rayonnée » est pratiquement appréciable.

Cette remarque est importante. Elle nous indique plus nettement pourquoi il ne peut, en pratique, y avoir de rayonnement avec les courants à fréquence industrielle, comme ceux qui servent à nous éclairer. La fréquence est de 50 périodes par seconde ; la longueur d'onde correspondante est de 300.000.000/50 soit 6.000.000 de mètres... Ce n'est donc qu'à une distance minimum de 6.000 kilomètres que le rayonnement pourrait être prépondérant. Mais nous avons exposé plus haut qu'avec une fréquence aussi petite le rayonnement est fatalement peu important. Il est donc impossible d'en pouvoir ressentir les effets à 6.000 kilomètres. L'effet constant est donc l'induction.

Propriétés générales du rayonnement.

Par « rayonnement » nous continuons, pour l'instant, à comprendre tous les rayonnements électromagnétiques, aussi bien les rayonnements utilisés dans la radio que les rayons X ou la lumière visible.

Nous savons déjà qu'au rayonnement on peut faire correspondre une fréquence (exprimée en périodes ou cycles, ou kilocycles par seconde), une longueur d'onde (exprimée en mètres, centimètres ou millimètres). La vitesse de propagation est la même pour tous les rayonnements, tout au moins dans le vide, elle est voisine de 300.000 kilomètres par seconde.

On a vu longtemps que, dans un milieu homogène, le rayonnement se transmettait en ligne droite.

Mais Einstein a démontré théoriquement, et la preuve en a été faite expérimentalement, que le rayonnement est pesant. Un rayon lumineux est donc dévié par la pesanteur. La chose a été récemment mise en évidence et le phénomène mesuré par des travaux astronomiques récents. Cette constatation a une importance philosophique considérable. Elle nous enlève tout espoir de pouvoir définir jamais la ligne droite. A la question : « Qu'est-ce qu'une ligne droite ?» on répondait : « C'est la trajectoire d'un rayon lumineux dans le vide. » Or, du fait même qu'il y a un observateur, il existe un champ de gravitation ou de pesanteur. En conséquence, le rayon lumineux n'est pas droit. Et il est impossible de définir la ligne droite...

Si ce poids de la lumière a passé longtemps inaperçu, c'est qu'il est excessivement faible. Il tombe, cependant, dans les possibilités de certaines méthodes de mesure.

Le rayonnement est une forme d'énergie. D'ailleurs, on parle souvent d'énergie rayonnante. Cette énergie est naturellement empruntée au corps qui rayonne.

Lorsqu'un rayonnement est absorbé par un corps, l'énergie apparaît généralement sous forme de chaleur. Puisque la lumière et le rayonnement en général ont un poids on doit s'attendre à ce qu'un corps frappé par un rayon subisse une certaine répulsion. A vrai dire, cette « pression de radiation » est excessivement petite.

Il ne faut pas, d'ailleurs, confondre cet effet avec celui qui anime les radiomètres qu'on voit parfois à l'étalage des opticiens. Ce sont de petits moulinets qui tournent dès qu'on les expose à la lumière.

Il s'agit là d'un phénomène calorifique. L'effet s'arrête dès que le vide de l'ampoule dépasse une certaine limite.

La pression de radiation est beaucoup trop faible pour qu'on puisse espérer la mettre mécaniquement en évidence.

Enfin, le rayonnement peut aussi amorcer ou produire des réactions chimiques. C'est cet effet photochimique qui est utilisé dans la photographie ou la cinématographie.

Le rayonnement et la théorie de Maxwell.

Il n'est pas sans intérêt de souligner que la théorie électromagnétique de la lumière fut établie, en 1867, par l'anglais Maxwell. Il s'agissait alors de travaux purement théoriques, dans lesquels l'illustre physicien démontrait l'identité de la lumière et de l'électricité.

Maxwell prévoyait mathématiquement l'existence d'un autre rayonnement électromagnétique ne différent de la lumière que par sa fréquence et capable, lui aussi, de se propager.

Ce rayonnement particulier fut expérimentalement mis en évidence par Hertz, en 1888. Les expériences du physicien allemand reproduisaient avec le rayonnement hertzien un certain nombre d'expériences d'optique.

On doit donc dire qu'à l'origine de la Radio il y a un anglais et un allemand.

L'hypothèse de l'éther.

L'esprit admet difficilement que l'énergie puisse se propager sans emprunter un milieu de propagation. Ainsi, les vibrations acoustiques ont besoin de la matière pour se propager. Elles empruntent l'air ambiant, ou l'eau, ou un solide quelconque. Dans le vide, le son ne se propage pas. Une expérience élémentaire de physique met ce fait en évidence.

Or, le rayonnement se propage parfaitement dans les espaces interastraux où règne un vide beaucoup plus parfait que celui que nos instruments permettent d'obtenir.

La croyance dans la nécessité d'un milieu de propagation était tellement ancrée dans l'esprit des savants qu'ils ont été conduits à en imaginer un.

C'est le fameux « Ether ». L'éther, que personne n'a jamais vu et dont les propriétés contradictoires ne peuvent se concilier avec tout ce qu'on sait de la constitution de la matière. Il me semble beaucoup plus simple de dire avec M. Marcel Boll : « L'Ether n'existe pas ».

A quoi bon cacher ce que nous ignorons derrière une étiquette qui ne correspond à rien ?

Il faut, tantôt admettre que l'Ether est infiniment fluide, puisque tous les corps en sont baignés dans leurs profondeurs, et tantôt admettre que l'Ether est plus rigide que l'acier...

L’analyse mathématique du rayonnement montre qu'il est constitué par un champ magnétique et un champ électrique variables, dont les composantes sont dans des directions rectangulaires.

On peut admettre qu'une force électrique et une force magnétique puissent agir à distance sans faire intervenir un milieu ou support plus ou moins immatériel...

Les catégories de rayonnement.

Le rayonnement utilisé en radiotélégraphie et en radiotéléphonie comporte des longueurs d'ondes qui s'échelonnent entre 30.000 mètres et quelques centimètres.

Les fréquences correspondantes sont comprises entre 10.000 périodes par seconde et 100 milliards de périodes par seconde.

Au delà de ces fréquences, on trouve une zone, connue à l'heure actuelle, dans laquelle le rayonnement n'est plus une onde hertzienne mais n'est pas encore tout à fait le rayonnement infra-rouge ou calorifique. Au delà, on trouve le rayonnement infra-rouge.

Enfin, nous arrivons à la mince bande de fréquence constituant la lumière visible... dont les fréquences s'étendent de 375 à 750 trillions de périodes par seconde.

Viennent ensuite les rayons ultra-violets — de 750 trillions à 20 quadrillions.

On passe ensuite aux rayons X « mous », puis aux rayons X « durs » ou pénétrants, dont la fréquence est plus élevée.

Les rayons X et ultra X ont des fréquences comprises entre 20 quatrillions et 60 quintillions.

Au delà sont les rayons gamma du radium, le rayonnement cosmique et, enfin, l'inconnu...

Le spectre du rayonnement est connu jusqu'aux rayons Gamma.

On peut schématiser ce spectre continu, qu'on connaît aujourd'hui entièrement sous forme d'un tableau (fig. :5).

On reconnaît ainsi qu'aucun « trou » n'a été laissé par ces explorateurs que sont les physiciens.

Il est frappant d'observer combien la bande représentant la lumière visible est mince. Cela lui donne en quelque sorte un caractère accidentel...

Les divisions indiquées par nos lignes verticales sont purement arbitraires. On passe insensiblement du violet à l'ultra-violet, par exemple. La radiation ne cesse pas brusquement d'être de l'ultra-violet pour devenir rayon X à une fréquence déterminée...

Il faut noter que nous avons choisi une échelle logarithmique et non une échelle proportionnelle. Dans ce dernier cas, il aurait fallu une feuille de papier de quelques mètres pour que « l'accident » de la lumière visible ait plus que l'épaisseur d'un trait.

Pour faciliter la lecture, nous avons adopté une graduation en puissance de 10. Ainsi, par exemple, 103 signifie 10 multiplié 3 fois par lui-même ou 10x10x10, ou, encore, 1 suivi de 3 zéros, c'est-à-dire 1.000.

1010 c'est 1 suivi de 10 zéros, c'est-à-dire 10.000.000.000 ou 10 milliards…

Cette façon de compter est commode. Elle a, dans notre cas, un inconvénient que nous devons signaler : elle cache sous une appellation facile la grandeur surhumaine des nombres dont il s'agit. Prenons l'exemple concret de la lumière jaune, à laquelle correspond la fréquence 5X1014 ou cinq cent mille milliards de périodes par seconde. C'est dire que l'électron qui émet la lumière jaune vibre 500.000 milliards de fois par seconde.

Ce chiffre dépasse largement les possibilités de l'imagination la plus solide.

Si nous admettions que, quelque part sur la terre, bien avant le déluge, au moment même où la vie faisait son apparition sur le globe, un être ait pu commencer à compter sans répit sans prendre le temps même de respirer, nous devrions conclure qu'aujourd'hui même il serait bien loin d'arriver jusqu'à ce chiffre. Or, l'ère humaine représente un moment bien petit de la vie du globe... La lumière jaune accomplit ce résultat vertigineux en une seconde..., le temps de prononcer deux mots.

Et la lumière jaune, si on la compare à la lumière violette, a une fréquence lamentablement lente !

Propriétés du rayonnement et fréquence.

Les propriétés générales da rayonnement, exposées plus haut, sont indépendantes de la fréquence. Mais il est des propriétés particulières qui dépendent d'elle. Cela nous fait comprendre pourquoi on a pu longtemps ignorer l'identité de cause entre un rayon X et une onde hertzienne.

Une feuille de verre au plomb pourra se laisser traverser par un rayon de lumière. Elle pourra, au contraire, être un obstacle infranchissable pour un rayon X « mou ».

Au contraire, aucun rayon lumineux ne traversera une feuille d'aluminium mince, mais un rayon X dur n'y trouvera point d'obstacle.

Une onde hertzienne traverse une épaisseur de briques ou d'ébonite — obstacle impénétrable pour un rayon lumineux.

Un rayon calorifique ou infrarouge demeurera invisible, à nos yeux, mais sa présence sera facilement révélée par un thermomètre dont il fera monter la colonne de mercure.

On pourrait multiplier ces exemples à l'infini...

Dans une étude prochaine, nous exposerons plus spécialement les propriétés particulières du rayonnement hertzien...

CHAPITRE DEUXIEME

Nous pouvons tirer des pages précédentes une conclusion fort instructive : chaque fois qu’un électron subit un brusque changement de vitesse, il envoie un signal qui constitue le rayonnement. Suivant la rapidité de la variation ou, en termes plus précis, suivant la grandeur de l’accélération, le signal envoyé est un rayon X, un rayon de lumière visible, une onde hertzienne, etc...

Notons en passant que cette variation de vitesse peut avoir lieu dans un sens ou dans l’autre. Si un électron est au repos et qu’on lui communique une impulsion, il produit du rayonnement; il en produit aussi lorsque, lancé à une certaine vitesse, on l’arrête brusquement dans son essor.

Un électron, c’est bien peu ! Il est certain que le rayonnement sera considérablement renforcé si nous trouvons le moyen de communiquer des mouvements semblables à un grand nombre d’électrons.

Le problème de la production du rayonnement se ramène finalement à celui-ci : produire, dans un conducteur, un mouvement alternatif des électrons ou, si l’on préfère, un mouvement vibratoire...

En d’autres termes, il s’agit simplement de produire un courant alternatif à haute fréquence.

Production directe du courant alternatif.

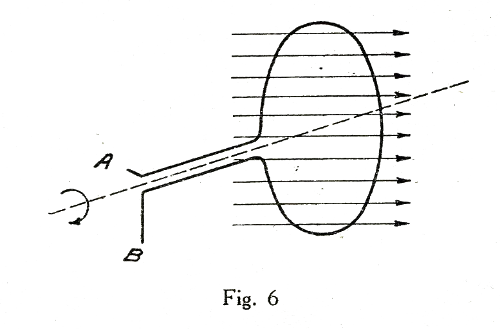

Si l’on fait tourner une simple spire de fil perpendiculairement au plan d’un champ magnétique uniforme, il se développe entre les extrémités de la boucle une tension induite variable (fig. 6). Si le mouvement de rotation est uniforme, la tension induite est alternative et sa fréquence est égale au nombre de tours par seconde.

Voici donc un moyen très simple de produire du courant alternatif. Notre machine est donc en somme un alternateur élémentaire. Les grands turbo-alternateurs des centrales électriques modernes n’ont pas un principe différent...

N’oublions pas, toutefois, qu’il s’agit de produire des courants de haute fréquence. Pour que notre rayonnement soit digne de ce nom, il faut au moins que sa fréquence soit de 10.000 périodes par seconde...

Ce qui suppose une vitesse de rotation de notre spire de 10.000 tours par seconde... soit 600.000 tours à la minute.

Nous nous heurtons donc brutalement à une impossibilité.

En multipliant le nombre de pôles, en modifiant notablement le principe, en faisant tourner les induits dans le vide, on est cependant parvenu à construire des alternateurs donnant directement des fréquences de l’ordre de 30.000 périodes par seconde.

Grâce à ces machines, le poste d’émission est exactement semblable à une centrale qui fabrique de l’électricité. Il y a des moteurs et il y a des alternateurs. Ceux-ci sont connectés à l’antenne chargée de rayonner les courants de haute fréquence...

Mais la fréquence de 30.000 périodes/seconde ou, si l’on préfère, de 30 kilocycles/seconde est à peu près la limite. On peut doubler et même quadrupler la fréquence des courants, grâce à des circuits spéciaux, mais c’est au détriment du rendement et de la simplicité.

Cette méthode très simple de production du rayonnement ne peut donc être utilisée que lorsqu’il s’agit de produire des « ondes très longues ».

Encore n’a-t-elle qu’une apparence de simplicité. Il faut, en effet, réaliser une vitesse de rotation très élevée et cette vitesse doit être maintenue rigoureusement constante. Cela pose un certain nombre de problèmes qui ont reçu des solutions, mais dans le détail desquels nous n’avons point à pénétrer ici.

Qu’il suffise à nos lecteurs de savoir que la réalisation de l’alternateur à haute fréquence a été obtenue industriellement. Cette solution ne peut être envisagée que pour de très grandes longueurs d’ondes et pour des puissances énormes.

Il faut donc songer à d’autres solutions. Avant d’en arriver là, nos lecteurs doivent savoir ce qu’est un circuit oscillant et quelles sont ses propriétés.

Le circuit oscillant.

Nous avons appris plus haut ce qu’on devait entendre par « oscillation », mouvement vibratoire ou mouvement pendulaire. Nous avons choisi l’exemple d’un corps pensant suspendu à un fil. Nous allons nous efforcer d’examiner d’un peu plus près ce qui se passe dans cette expérience simple.

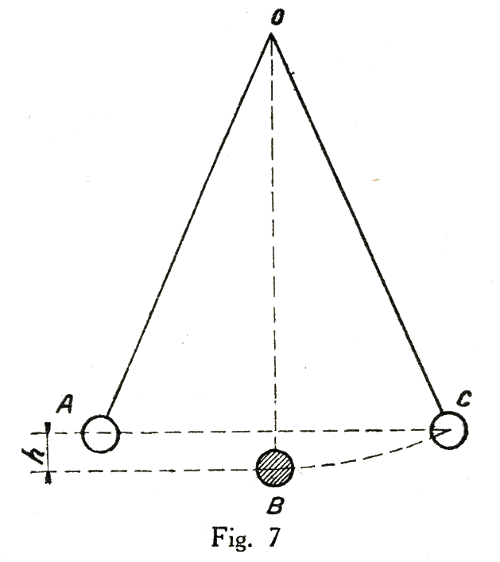

Suspendons donc un corps à l’extrémité d’un fil mince (fig. 7).

Notre système occupe, pour l’instant, la position verticale OB. L’expérience nous montre qu’il resterait éternellement dans cette position si rien n’intervenait.

Poussons le corps jusqu’à la position A. Il nous faut évidemment produire un certain effort. Il nous faut lutter contre la pesanteur.

Pousser le corps de B vers A, c’est, en somme, le soulever de la hauteur h.

On apprend, en Mécanique, que le travail effectué est égal au produit de la force multiplié parle chemin parcouru. Ce dernier est égal à h...

Lorsque nous aurons immobilisé le corps en A, notre travail sera-t-il perdu? Non, il sera, en quelque sorte, accumulé dans le corps. Pour qu’il apparaisse, il suffira de laisser retomber le corps. Nous pouvons nous servir de cette énergie pour élever un autre corps. Nous pouvons aussi simplement laisser tomber le corps et l’énergie se traduit par un échauffement du corps au moment du choc...

Ainsi donc, l’énergie utilisée est toujours présente; elle ne demande qu’à se manifester, elle est « en puissance » d’où son nom « d’énergie potentielle ».

Libérons le corps. Il revient vers B et, comme nous l’avons expliqué plus haut, arrive en ce point avec une vitesse maximum... Une première partie du cycle est close. Le corps est revenu à son point de départ... Où est notre énergie?

Elle a simplement changé de forme. Pour communiquer une certaine vitesse à un corps pesant, il faut encore dépenser de l’énergie. Il s’agit alors d’énergie cinétique — ou énergie due à la vitesse.

C’est cette énergie cinétique qui entraîne le corps bien au delà du point B jusqu’au point C, à peu près symétrique du point A...

Après le passage en B, c’est l’énergie cinétique qui est chargée de lutter contre la pesanteur. A mesure que le corps s’approche de C, sa vitesse décroît, par suite son énergie cinétique diminue, mais en même temps son énergie potentielle augmente.

Quand l’énergie potentielle est nulle, l’énergie cinétique est maximum et inversement.

Ainsi donc l’oscillation que nous constatons est la résultante de cette transformation d’énergie. Il importe de retenir qu’en fait, toute oscillation, toute vibration obéit à la même loi. Il y a transformation ou changement de forme de l’énergie...

Caractères du mouvement vibratoire.

La durée d’oscillation est très sensiblement constante. Un même temps s’écoule entre deux passages du corps au point A. C’est cette observation qu’on met à profit dans l’horloge pour obtenir la mesure précise du temps.

Nous avons plus haut défini ce qu’il fallait entendre par fréquence et période.

L’intensité du mouvement vibratoire peut être définie dans le cas de la figure 7. On peut dire aussi que c’est l’amplitude du mouvement.

L’expérience journalière montre que l’amplitude du mouvement décroît régulièrement.

A noter cependant que, malgré cela, la fréquence demeure sensiblement constante.

Au bout d’un temps plus ou moins long, on constate que l’oscillation cesse complètement.

On dit alors que le mouvement vibratoire est amorti.

Cela s’explique sans peine. Il faut, en effet, comprendre qu’une partie de l’énergie est perdue dans les frottements. Il y a le frottement du corps contre l’air, le frottement au point de suspension O.

Cette énergie dégradée est naturellement perdue. Elle se traduit par une diminution régulière de l’amplitude du mouvement.

DEUX FORMES DE L’ENERGIE ELECTRIQUE.

a) Energie potentielle.

Un condensateur chargé représente de l’énergie électrique emmagasinée sous la forme potentielle. En reliant les deux armatures par un conducteur, cette énergie se manifeste sous la forme d’un courant électrique.

La quantité d’énergie varie naturellement avec la capacité du condensateur et la tension décharge. On peut aussi comparer le condensateur chargé à un ressort qu’on a bandé par un moyen quelconque et qui est immobilisé dans cette situation.

En fait, un condensateur chargé présente, sur une armature (négative) une accumulation anormale d’électrons, l’autre armature (positive) présentant, au contraire, une raréfaction d’électrons.

Si l’on fait communiquer les deux armatures par un conducteur, les électrons en surnombre se précipitent vers l’armature positive...

b) Energie cinétique.

Une bobine parcourue par un courant électrique nous montre une autre forme d’accumulation d’énergie. Si nous interrompons brusquement le circuit, une étincelle de rupture chaude et bruyante apparaît, dans certains cas, aux bornes de l’interrupteur.

Cette étincelle, due à la self induction ou à l’inductance, est la trace visible de l’énergie accumulée dans le champ magnétique. Elle a été fournie par la source de courant au moment de l’établissement du courant; il est naturel qu’elle réapparaisse au moment où le courant cesse.

On pourrait insister sur l’analogie qui existe entre les manifestations matérielles qu’on nomme l’inertie et les manifestations électriques dues à la self-induction. L’inertie tend à prolonger l’état présent. Un corps est-il au repos ; il faut vaincre l’inertie pour le mettre en mouvement. S’il est, au contraire, animé d’une certaine vitesse, c’est l’inertie qui s’oppose à son ralentissement.

C’est en vertu de son inertie que le corps oscillant, arrivé au point B, est entraîné jusqu’au point C...

Or, il est bon d’avoir toujours présent à la mémoire que le courant électrique se ramène à un simple mouvement d’électrons. La self-induction est donc, en définitive, une propriété qui traduit l’inertie «les électrons.

Il est instructif de constater que, dans les deux cas, l’énergie emmagasinée n’est pas dans le corps conducteur. Elle est, pourrait-on dire, à l’extérieur. Dans le cas du condensateur, l’énergie est représentée par le champ électrique présent dans le diélectrique. Dans le cas de l’inductance, l’énergie est représentée par le champ magnétique dans lequel baigne la bobine. Il est donc en dehors du circuit, ou du conducteur.

Le circuit oscillant.

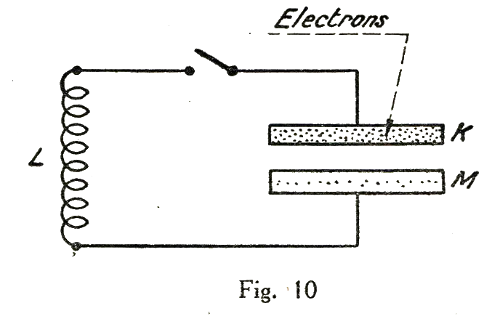

Le circuit oscillant est formé par l’association d’une inductance L et d’un condensateur C. Pour faciliter notre explication, nous avons inséré un interrupteur I, qui coupe le circuit pour l’instant (fig. 8).

Le condensateur C est chargé. Cela veut dire que sur une des armatures, il y a un excès d’électrons.

Fermons le contact. Tout se passe comme si les

électrons avaient une certaine inertie, due précisément au fait qu’ils doivent traverser l’inductance L.

Le courant électrique ne va donc pas s’établir d’une façon instantanée.

Cherchons à suivre la marche des phénomènes.

Pour qu’il n’y ait aucun courant, il faudrait évidemment que les deux armatures du condensateur fussent à la même tension électrique. En d’autres termes, il faudrait qu’elles ne présentassent ni excès, ni raréfaction d’électrons. Cet état d’équilibre correspond au point B de la figure 7.

Ce n’est point le cas présent. Nous venons de rendre le passage libre en fermant l’interrupteur. Les électrons vont-ils se précipiter immédiatement à une vitesse uniforme, de l’armature K vers l’armature L.

Il est évident que non; précisément à cause de l’inertie.

Supposons que nous ayons le moyen de mesurer à chaque instant le nombre d’électrons qui traverse

le circuit... Allons chercher cet observateur idéal que nous avons déjà utilisé dans le premier chapitre. Nous apprécierons, grâce à lui, l’intensité du courant instantané.

Au départ, il n’y a aucun courant, mais la tension entre les deux armatures K et L est maximum.

Notons de suite que l’énergie présente est emmagasinée dans le condensateur sous forme potentielle.

Puis les électrons secouent leur torpeur et se précipitent de K vers M à travers L.L’inductance L étant traversée par un courant s’entoure d’un champ magnétique... qui représente de l’énergie cinétique électrique...

Le courant tendrait à s’établir d’une façon définitive si le condensateur était capable de maintenir entre les électrodes la même tension électrique.

Mais à mesure que K perd des électrons et que M en reçoit, la dissymétrie s’atténue. Elle s’annule même à un certain moment...

A cet instant, est exactement réalisé l’état d’équilibre examiné plus haut... Mais au moment même où il se produit, la bobine L est traversée par un courant. Les électrons continuent leur course.

L’observateur idéal vous dirait même que le courant instantané est maximum...

En conséquence, le champ magnétique et l’énergie qu’il représente sont à leur maximum.

Il est clair cependant que cet état est instable.

Puisque le condensateur C ne peut plus envoyer des électrons grâce à son énergie interne, tout va sans doute cesser...

Non pas : l’inertie électrique, l’inductance tend à prolonger l’état de ce mouvement...Grâce à elle les électrons aspirés dans l’armature K continuant à se rendre vers l’armature M...

Cela affaiblit cependant peu à peu les forces accumulées dans le champ magnétique.

Aussi, dès le moment d’équilibre, l’intensité de courant a-t-elle commencé de diminuer...

Il n’en demeure pas moins vrai que des électrons continuent de circuler et vont, cette fois, s’accumuler en M.

Enfin, le courant cesse. Mais à ce moment, la situation de départ est exactement retournée. L’électrode M est négativement chargée, elle présente un excès d’électrons et l’électrode K est positivement chargée. Les conditions réalisées sont celles de la figure 10.

Le même phénomène va donc recommencer dans l’autre sens. Les électrons, en excès du côté de l’armature K, vont s’en aller vers l’armature M.

Nous assistons donc exactement à un mouvement vibratoire électrique. L’énergie électro magnétique (champ magnétique) est nulle, puis croissante, passe par un maximum et décroît, elle se transforme périodiquement en énergie électrostatique (champ magnétique du condensateur) dont la loi de vibration est absolument symétrique.

Comme dans l’expérience du pendule, la fréquence est absolument régulière. Elle ne dépend pas plus de la tension primitive de charge que la durée d’oscillation du pendule ne dépend de la grandeur h (fig. 7).

En prolongeant la comparaison, on verrait que les oscillations électriques sont amorties.

La bobine L n’est pas une pure inductance, elle possède une résistance électrique. Par conséquent tout passage de courant produit aussi un échauffement.

A chaque oscillation, une partie de l’énergie est donc dégradée. Aussi ne faut-il pas s’étonner si l’amplitude décroît très rapidement.

Dimensions électriques du circuit oscillant.

La fréquence des oscillations du pendule est déterminée, en un lieu donné, par ses dimensions mécaniques et par l’intensité de la pesanteur. Un pendule très grand donnera une grande période d’oscillation. Il est sans doute inutile d’insister sur ce fait qu’apprend l’expérience de chaque jour.

De même, les dimensions électriques du circuit oscillant, constitué par l’inductance et la capacité, déterminent la fréquence des oscillations produites.

Les dimensions électriques sont, tout naturellement, la grandeur du coefficient de self-induction ou inductance et la capacité du condensateur.

En agissant sur l’une ou sur l’autre on modifie le rythme des transformations d’énergie. Une augmentation de capacité, comme une augmentation d’inductance, correspond à une augmentation de la durée d’une oscillation, c’est-à-dire à une diminution de la fréquence. Ces deux qualités varient naturellement en sens inverse.

En fait, les dimensions électriques d’un circuit déterminent la fréquence des oscillations naturelles qui peuvent y prendre naissance.

Qu’est-ce que l’amortissement ?

Nous savons déjà ce qu’on doit entendre par oscillations amorties. Ce sont des oscillations dont l’amplitude décroît. Ce sont exactement celles d’un corps suspendu à un fil. Si le corps est très lourd, le fil de suspension très fin, les oscillations persistent longtemps. Nous savons aussi que l’amortissement est causé par les pertes d’énergie dues aux frottements divers. Plus ces frottements seront importants, plus on dira que l’amortissement est grand.

II en est de même en électricité. Nous avons tout à l’heure fait allusion aux pertes d’énergie causées par la résistance de la bobine. D’autres pertes peuvent intervenir. Des courants induits parasites prennent naissance dans les corps conducteurs placés au voisinage de l’inductance; ce sont les « courants de Foucault » qui correspondent également à une perte d’énergie. Enfin le condensateur n’est pas impeccable, lui non plus. Des pertes« diélectriques » se produisent entre les deux armatures, et c’est encore autant d’énergie transformée en chaleur. L’ensemble de ces pertes est responsable de l’amortissement du circuit; plus il est important, plus grand est l’amortissement.

Amortissement critique.

Imaginons un pendule dont il nous soit possible de faire varier l’amortissement.

Cela peut être tout simplement une règle ou T à dessiner que nous tenons entre le pouce et l’index. En serrant plus ou moins les deux doigts, on peut faire varier le frottement et, par conséquent, l’amortissement.

Cela peut être tout simplement une règle ou T à dessiner que nous tenons entre le pouce et l’index. En serrant plus ou moins les deux doigts, on peut faire varier le frottement et, par conséquent, l’amortissement.

Si on laisse la règle très libre, les oscillations se produiront pendant un temps assez long. L’expérience nous montre que ce temps est d’autant plus court qu’on serre plus fortement. On constate sans peine que l’augmentation de l’amortissement ne modifie pas sensiblement la période de l’oscillation. Pour un certain serrage, la règle cesse d’osciller; elle vient tout simplement prendre sa position d’équilibre. Nous avons à ce moment réalisé les conditions d’amortissement critique.

Les mêmes faits se reproduisent, transposés dans le domaine électrique. Il ne faut pas que les pertes soient trop élevées, sinon le circuit cesse d’être oscillant. Le condensateur se décharge simplement et aucune oscillation ne se produit.

Oscillations entretenues.

Une oscillation est entretenue quand son amplitude demeure constante. Sachant que l’amortissement est causé par les pertes, on conçoit qu’on puisse entretenir le mouvement en restituant, à chaque oscillation, l’énergie perdue pendant l’oscillation précédente...

Le balancier d’une horloge est un exemple d’oscillation mécanique entretenue.« L’échappement » du mouvement d’horlogerie a précisément pour rôle de restituer au balancier l’énergie perdue par frottement. Cette restitution se fait sous forme d’une petite impulsion donnée régulièrement dans le sens convenable.

On peut concevoir qu’il en soit ainsi pour les oscillations électriques. Si, au début, la tension aux bornes du condensateur est de 10 volts, il suffira, par un moyen quelconque, de maintenir ce niveau électrique après chaque oscillation pour que le mouvement électronique soit entretenu.

Représentation graphique.

Il est commode de représenter les phénomènes vibratoires par un graphique. On peut, d’un seul coup d’œil, juger des différentes caractéristiques du mouvement.

Il est commode de représenter les phénomènes vibratoires par un graphique. On peut, d’un seul coup d’œil, juger des différentes caractéristiques du mouvement.

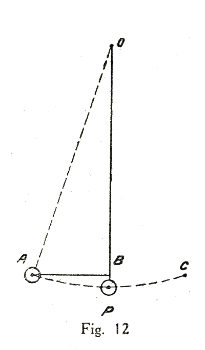

Prenons encore l’exemple du mouvement pendulaire (fig. 12). A chaque moment, nous savons où en est le mouvement si nous connaissons la distance de BA, ou élongation, ou amplitude. Pour que nos renseignements soient tout à fait suffisants, il faut encore que nous sachions si le corps est à droite ou à gauche de la ligne d’équilibre OP.

Pour compléter notre convention, nous pouvons admettre que les élongations du côté de A sont négatives et que celles du côté de C sont positives.

Enfin, nous admettrons que le temps se déroule suivant une ligne régulière et continue.

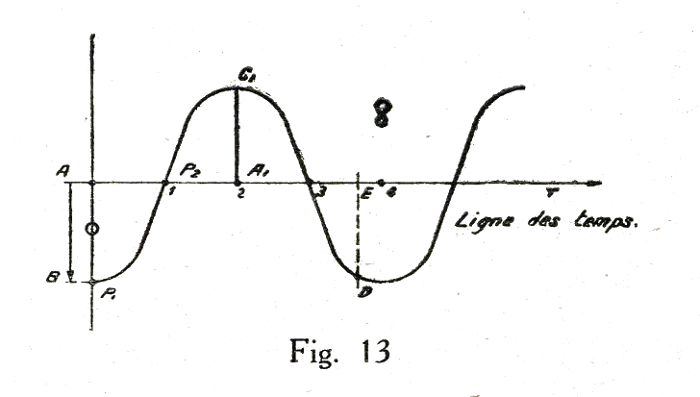

Représentons, figure 13, cette ligne des temps par une horizontale OT.

Admettons maintenant que les élongations ou amplitudes positives sont comptées au-dessus de l’axe des temps et que les amplitudes négatives sont comptées au-dessous.

Commençons à déterminer le mouvement. Au début de l’expérience le corps est au point A. Commençons à compter les secondes qui s’écoulent.

A l’origine, il y a zéro seconde et l’amplitude est AB. Portons cette amplitude sur le graphique, en AB. Cela nous détermine le P1.

Au bout d’une seconde, le mobile est revenu dans la position OB, — l’amplitude est donc nulle.

Sur la ligne des temps, au point correspondant à une seconde, nous marquons le point P2.

Puis, l’amplitude change de sens, et au bout de 2 secondes, le corps est au point C. Nous marquons l’amplitude en A, C, etc... Ainsi, de point en point, nous pouvons suivre le mobile dans ses mouvements.

En reliant tous ces points par une ligne continue, nous obtenons un graphique qui nous renseigne exactement sur toutes les circonstances du mouvement vibratoire.

Voulons-nous connaître la position du mobile au bout de trois secondes et demie ? Au point de l’axe des temps correspondant à 3,5 secondes, il suffira d’élever une perpendiculaire. Le point de rencontre de cette ligne avec le graphique nous donnera la position cherchée. L'amplitude est, en effet, ED.

Nous savons que l’amplitude maximum est AB. D’un simple coup d’œil nous savons que la période est de 4 secondes...

Ainsi, on peut dire que le graphique figure 13 est une fiche signalétique complète du mouvement vibratoire.

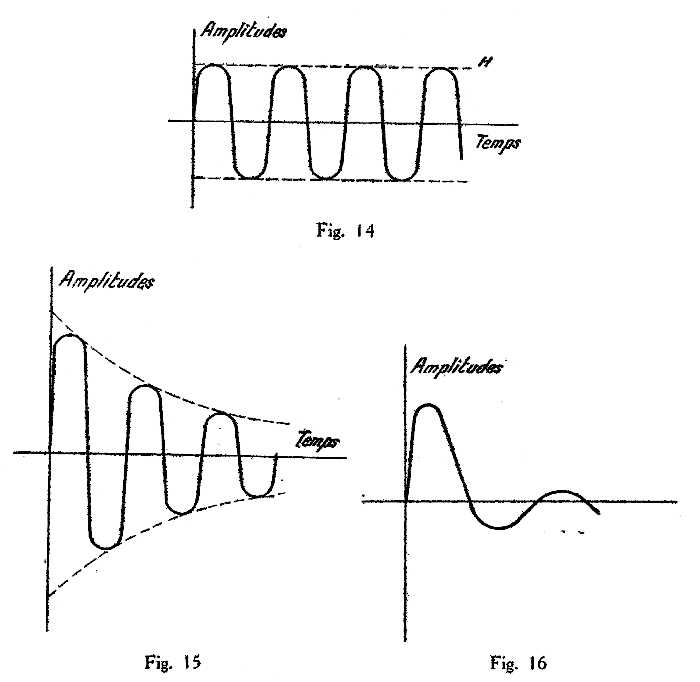

A un mouvement vibratoire entretenu correspondra un graphique analogue à la figure 14. La figure 15 correspond au contraire à un mouvement amorti et, dans le cas de la figure 16, l’amortissement est encore plus considérable.

Il est évident que les oscillations électroniques peuvent aussi être représentées graphiquement. Il nous suffira de mesurer les amplitudes électriques, c’est-à-dire les tensions et de porter celles-ci sur l’échelle verticale. Les temps seront, de la même façon, portés sur l’échelle horizontale. Nous aurons toutefois à mesurer des temps beaucoup plus courts que pour une oscillation pendulaire. Il s’agira souvent de temps inférieurs à un millionième de seconde.

Nous pourrions tout aussi bien représenter graphiquement le mouvement vibratoire d’un corps qui produit un son...

On voit, par ces quelques exemples, que cette méthode de représentation est extrêmement pratique et qu’elle permet de nous faire voir instantanément l’allure d’un mouvement vibratoire.

Le mouvement pendulaire.

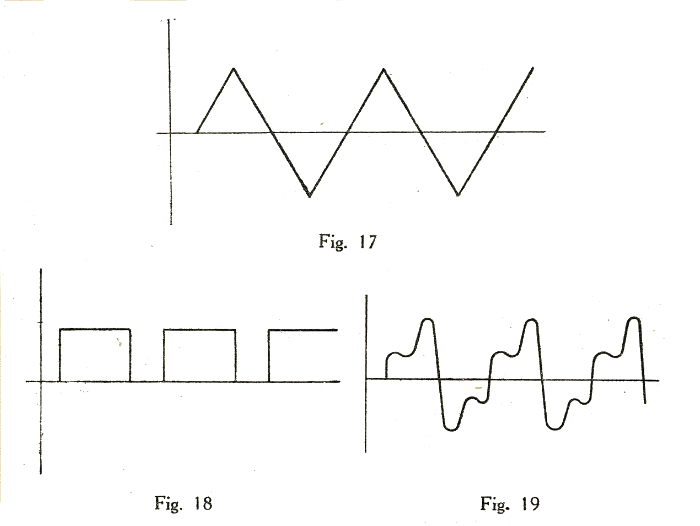

Un mouvement vibratoire ou périodique est un mouvement qui se reproduit périodiquement semblable à lui-même.

Si nous avons recours au mode de représentation expliqué plus haut, nous comprenons qu’il peut y avoir une infinité de types de mouvements. Ainsi, figures 17, 18 et 19, nous en représentons quelques-uns.

Le plus simple de ces mouvements est le mouvement pendulaire. C’est celui dont la forme, traduite graphiquement, est semblable à celle d’une oscillation pendulaire, c’est-à-dire à celle d’un corps pesant suspendu qui oscille sous la seule action de la pesanteur. La forme de cette courbe s’appelle une « sinusoïde », d’où le nom de « vibration sinusoïdale » qu’on donne encore à ce type de mouvement.

L’allure d’une vibration simple est à peu près celle des figures 14 et 13...

On peut démontrer qu’une vibration complexe, comme c’est le cas des figures 17, 18 et 19, est toujours équivalente à une somme de vibrations simples. On peut retrouver la vibration complexe en superposant un certain nombre de vibrations simples.

De plus, les fréquences de ces vibrations simples sont des multiples de la fréquence initiale.

Traduisons cela en langage moins hermétique. Un corps présente une vibration complexe à raison de 1 période par seconde. Nous serions toujours en droit de considérer cette vibration comme la résultante d’un ensemble de vibrations simples dont les fréquences seront 2, 3, 4, etc..., périodes par seconde.

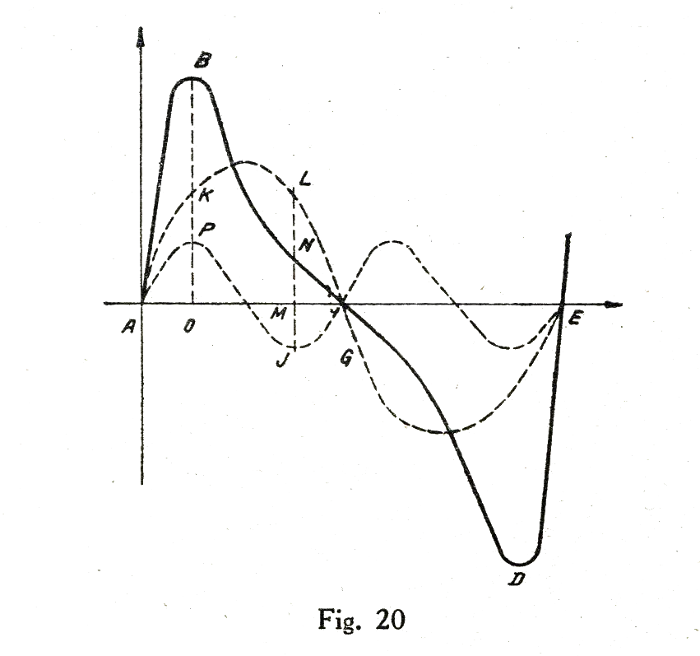

Prenons un exemple. Sur la figure 20 nous avons représenté un vibration complexe A B C D E.

On peut la considérer comme la résultante des vibrations simples A K L, C, etc..., et A P V, dont les fréquences sont respectivement doubles et triples.

Ainsi, on a :

OB = OK + OP

MN = ML - MJ

etc...

Il suffira à nos lecteurs de connaître ce résultat. Il faut faire appel aux mathématiques pour décomposer une vibration complexe en ses éléments simples.

Production d’oscillations électriques.

Pour faire osciller le pendule de la figure 12, il suffit d’écarter le corps de sa position de repos et de l’abandonner à lui-même.

Pour faire osciller les électrons du circuit figure 8, il suffira de charger le condensateur, puis de fermer l’interrupteur I.

Mais le pendule oscille encore longtemps après le premier mouvement. Si nous avons pris la précaution de choisir un mobile assez lourd et si le fil de suspension est très fin, nous obtiendrons des oscillations peu amorties. Le corps oscillera des centaines et des centaines de fois avant de s’arrêter...

Il n’en sera pas de même des oscillations électroniques. L’amortissement est relativement plus grand et les électrons s’arrêtent après une ou deux oscillations.

Ainsi, à chaque charge du condensateur, on ne peut compter que sur un signal fort bref. Pour espérer obtenir un effet à distance, il faudra multiplier autant qu’on pourra les impulsions. Il faudrait pouvoir ouvrir et fermer l’interrupteur I plusieurs milliers de fois par seconde...

Générateurs à étincelles.

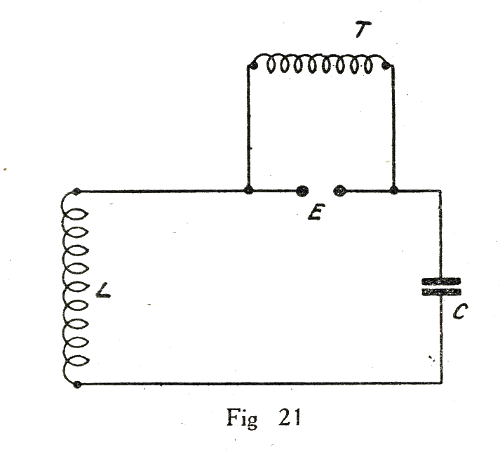

Imaginons le dispositif de la figure 21. Un circuit oscillant constitué par L et C est interrompu par un intervalle d’air E. Aux bornes de la coupure E on branche un transformateur T qui permet de développer une tension considérable.

Supposons que cette tension soit variable. Il est clair que le condensateur C se charge à travers la bobine L. Il ne peut, pour l’instant, y avoir d’oscillations à cause de la coupure E.

Au cours de ses variations, la tension de charge est nulle, croissante, passe par un maximum, décroît, devient nulle, change de sens, etc...

Lorsqu’on applique une tension très élevée entre deux conducteurs assez proches, il se produit une étincelle disruptive.

C’est ce phénomène qu’on met à profit pour l’allumage des moteurs d’automobile. C’est l’étincelle éclatant entre les pointes de la bougie qui allume le mélange détonnant.

Sous l’influence de l’étincelle, l’air devient provisoirement conducteur (en d’autres termes, il devient ionisé).

Ainsi, la tension entre les bornes E, croît en même temps que C se charge à cette tension. Si la tension est suffisante, une étincelle éclate en E. Cette coupure devient provisoirement conductrice et, par conséquent, des oscillations électroniques peuvent prendre naissance dans le circuit LC.

L’étincelle cesse dès que la tension a suffisamment diminué, mais le même phénomène peut se reproduire aussi souvent qu’on le désire. Il suffit d’admettre en T du courant à mille périodes par seconde pour que, mille fois par seconde, le circuit soit le siège d’oscillations amorties.

Ce principe permet de réaliser des petits émetteurs d’ondes amorties très simples. La plupart des stations côtières et des stations à bord des bateaux sont encore construites sur ce modèle.

Principe de la transmission.

Chaque fois qu’une étincelle éclate en E (fig. 21), les électrons du circuit subissent une série de vibrations. Nous savons déjà que cela se traduit par un rayonnement électromagnétique. Ce rayonnement se transmet hors du circuit et se propage avec la vitesse de la lumière.

On conçoit facilement que l’effet du rayonnement puisse être beaucoup plus considérable si l’on intercale dans le circuit un corps présentant une surface notable. C’est le rôle de l’antenne d’émission.

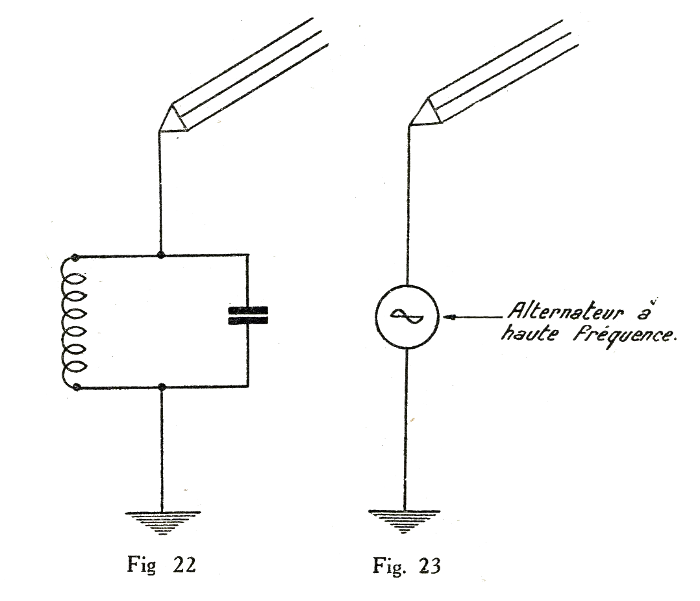

Cette antenne peut être considérée comme l’armature d’un condensateur dont la terre serait l’autre armature.

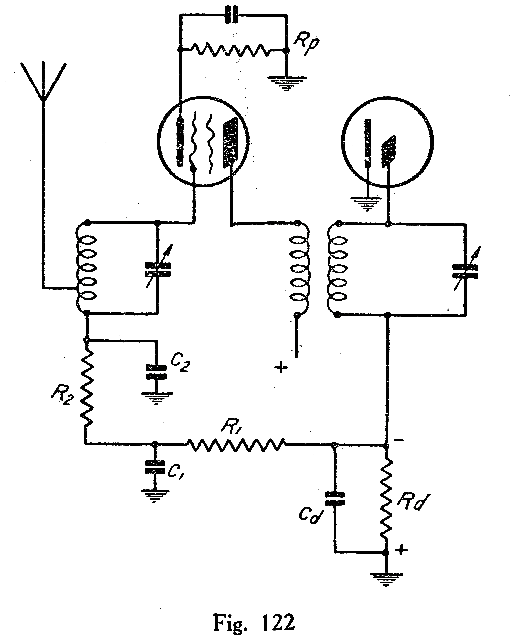

Ainsi se précise notre idée d’un poste d’émission. Nous pouvons maintenant le schématiser comme nous l’avons fait figure 22. C’est un circuit dans lequel sont produites des oscillations. L’effet de celles-ci est multiplié par l’emploi d’une antenne ou « aérien » dont le rôle est de « rayonner » les oscillations produites. L’antenne est, en fait, un véritable radiateur d’ondes.

De même que la flamme d’une bougie envoie des rayons lumineux dans toutes les directives, de même l’antenne envoie autour d’elle le rayonnement hertzien.

Mais la flamme de la bougie envoie un rayonnement qui n’est pas amorti, tandis que l’antenne émet en quelque sorte un bref signal à chaque étincelle qui franchit l’éclateur.

Si nous avions la possibilité de construire un alternateur à haute fréquence, nous pourrions constituer un poste d’émission comme sur la figure 23. Et cette fois, nous aurions exactement transposé l’image de la bougie dans le domaine hertzien...

Nous verrons plus loin qu’il est d’autres moyens d’obtenir des oscillations à haute fréquence entretenues. Pour l’instant nous pouvons supposer provisoirement le problème résolu.

Nous savons produire du rayonnement, nous savons émettre quelque chose qui est un signal.

Il faut apprendre maintenant comment ce signal peut être mis en évidence à une grande distance de l’antenne d’émission.

CHAPITRE TROISIEME

De l'antenne d'émission, le rayonnement magique s'échappe a la conquête du monde. Ses ailes vertigineuses l'entraînent à la vitesse inconcevable de 300.000 kilomètres à la seconde.

Nous savons déjà que les rayons, rencontrant un conducteur quelconque, y provoquent la naissance d'un courant électrique de même fréquence que lui...

La « réception des ondes » consiste donc tout simplement à mettre ce courant électrique en évidence.

A chaque étincelle de l'éclateur, un bref signal est rayonné. Quelque infime fraction de seconde après, l'antenne réceptrice est parcourue par un courant absolument identique d'allure, mais d'amplitude forcément très réduite. Le rythme du courant de réception sera naturellement le même que celui du courant d'émission. Si ce dernier est découpé en signaux convenus, ceux-ci seront reproduits par le courant de réception. Et voilà toute la Télégraphie sans fil...

Nécessité de la sélection.

Le collecteur d'ondes, ou antenne réceptrice, est donc le point de départ du poste récepteur. Il sera parcouru par le courant de réception. Mais nous pouvons facilement imaginer combien ce courant sera faible.

Il représente, en effet, la dépense d'une certaine énergie. Et cette énergie, c'est tout naturellement le poste d'émission qui en a fait les frais. Songeons qu'un courant semblable est développé dans tous les conducteurs frappés par le rayonnement. La somme des énergies de tous ces courants ne représente encore nécessairement qu'une fraction de l'énergie dépensée à l'émission...

L'amplitude des courants produits est extraordinairement réduite. Nous voici déjà fixés sur ce point.

D'autre part, ce qui est vrai pour le rayonnement qui nous intéresse l'est aussi pour tous les autres. S'il y a cent stations qui émettent simultanément, c'est cent courants divers qui se superposeront dans le collecteur d'ondes. Ces effets s'ajoutent algébriquement; c'est dire que l'effet total n'est pas forcément un courant plus intense, mais c'est une résultante.

Il faut donc, avant d'aller plus loin, que nous trouvions le moyen de sélectionner le courant qui nous intéresse, c'est-à-dire celui qui a été engendré par le rayonnement de l'émetteur qu'il s'agit de recevoir.

Ce moyen, les phénomènes de résonance vont nous le donner.

Qu'est-ce que la résonance ?

Tout le monde sait obscurément ce qu'est la résonance. Il suffit d'avoir fait quelques parties de balançoires dans sa jeunesse pour avoir fait connaissance avec elle.

Pour obtenir l'entretien du mouvement d'une balançoire, il suffit de donner de faibles impulsions dans le bon sens et au moment voulu. L'enfant acquiert très vite ce sens particulier...

Il serait inutile et fatigant de vouloir communiquer à l'escarpolette l'amplitude maximum dès le premier mouvement. On commence par une petite impulsion et il se produit une première oscillation très faible. La seconde impulsion est donnée dans le cours de la première oscillation et en augmente légèrement l'amplitude... Ainsi, à chaque oscillation, l'amplitude s'accroît et atteint bientôt une valeur impressionnante.

On sait que la « période » de la balançoire est parfaitement déterminée et que c'est perdre son temps et ses forces que de vouloir lui imposer un autre rythme que le sien... Il s'agit d'un phénomène de résonance.

La sélection par la résonance.

L'expérience que nous allons décrire est d'une réalisation très simple.

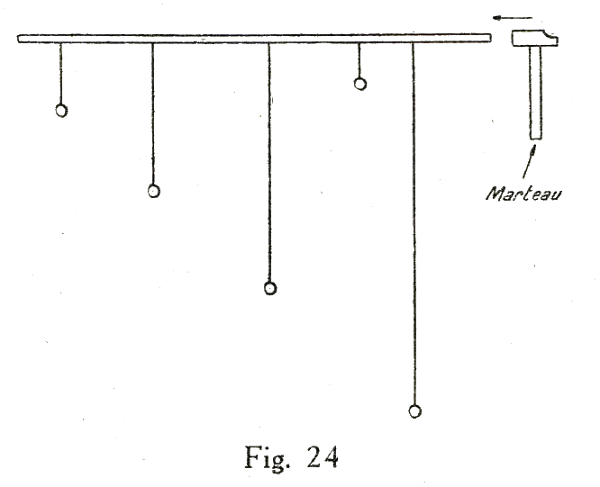

Soit une tige T (fig. 24) à laquelle nous suspendons une série de pendules dont les longueurs sont différentes. Longueurs différentes, cela veut dire : périodes de vibrations diverses.

Plus un pendule est long et plus longue est sa période.

A chacune de ces longueurs correspond donc une période, ou, si l'on préfère, une fréquence d'oscillation différente.

A l'extrémité de la tige T, donnons une série de chocs réguliers avec un marteau. A chacun des chocs, nous observerons une impulsion des pendules qui amorcent des oscillations. Si les chocs sont donnés suivant un rythme tout à fait irrégulier, nous observons qu'aucun pendule n'oscille régulièrement.

Mais astreignons-nous, maintenant, à donner des chocs en synchronisme avec l'oscillation d'un des pendules. Nous observerons que l'oscillation du pendule correspondant se précise immédiatement.

Chaque impulsion étant donnée au même moment de la période, et dans le sens convenable, l'amplitude prend une valeur considérable. Les autres pendules demeurent pratiquement immobiles. Ils amorcent un mouvement par moment mais ne tardent pas à s'arrêter pour recommencer l'instant suivant.

Parmi les cinq pendules, il n'en est qu'un seul dont le mouvement soit régulièrement entretenu.

Changeons maintenant le rythme des chocs. Réglons la fréquence sur celle d'un autre pendule. Nous constaterons que les mouvements de ce dernier prennent une amplitude croissante, alors que le premier ne tarde pas à s'arrêter.

Nous avons utilisé, dans cette expérience, les phénomènes de résonance. Par leur seule action, nous avons pu « sélectionner » le mouvement d'un pendule et d'un seul. Nous avons été maîtres de choisir celui que nous voulions mettre en mouvement. Il a suffit, pour cela, de rythmer nos impulsions sur la fréquence propre du mouvement. L'énergie communiquée par chacun des chocs, au lieu de se dépenser au hasard, s'est accumulée dans un mouvement bien défini.

La résonance autour de nous.

Que la période de vibration d'un chandelier, d'un piano, coïncide avec une note, et le chandelier vibrera désagréablement chaque fois que la note sera jouée.

Posez un violon accordé sur un piano lui aussi. Frappez une des notes qui correspond aux cordes du violon. Cette corde entrera en vibration.

Il est interdit à une troupe de passer au pas cadencé sur un pont suspendu. Si la fréquence des pas correspondait précisément à la fréquence, ou à un multiple de la fréquence propre du gigantesque pendule constitué par le pont, il pourrait y avoir production d'un mouvement de grande amplitude et le pont pourrait être arraché de ses attaches.

Nous pourrions citer de nombreux exemples. Les phénomènes de résonance ne sont pas un cas particulier, mais sont au contraire un cas absolument général.

Encore un exemple de résonance.

On peut faire une expérience peut-être encore plus instructive que celle de la figure 24.

Nous avons supposé que l'impulsion était donnée à l'aide de chocs. C'est peut-être un peu brutal et l'on peut admettre que l'énergie ainsi transmise est mal utilisée.

Reprenons notre barre de bois à laquelle nous avons fixé toute une série de pendules.

Ajoutons encore un pendule dont nous pourrons régler la longueur du fil de suspension. Notons encore une fois qu'en modifiant la longueur nous modifions, en fait, la fréquence du mouvement vibratoire.

Ce pendule supplémentaire est placé à l'extrémité de la barre. Donnons-lui exactement la longueur de l'un quelconque des autres pendules.

Pour l'instant, tout est en repos. Ecartons avec précaution ce dernier pendule de la position d'équilibre sans faire bouger les autres et rendons-lui la liberté.

Il oscille. Nous observerons alors que le pendule dont la longueur est égale, amorce, lui aussi un mouvement. Ce mouvement s'affirme peu à peu et ne tarde pas à prendre une amplitude notable.

Les autres pendules demeurent au repos. Ils amorcent parfois un léger mouvement, mais celui-ci s'arrête aussitôt.

Bientôt le premier et le second pendule oscillent en accord parfait et ils s'arrêteront en même temps.

Que s'est-il passé ? Le premier pendule a transmis de légères impulsions à la barre de bois. Si légères, qu'elles sont invisibles et même insensibles. Ces impulsions ont été transmises à tous les pendules. Seulement elles n'ont point, si l'on peut dire, trouvé une attention favorable partout. La résonance n'a pu se produire que pour un seul pendule. Mais, pour celui-ci, l'énergie transmise n'a point été perdue ; elle s'est accumulée et traduite par un mouvement dont l'amplitude était croissante...

Cette expérience a le mérite de nous faire exactement comprendre le mécanisme de la résonance. Il s'agit d'une accumulation de petits effets qui arrivent précisément au moment convenable.

En fait, à l'aide de la résonance, nous avons réalisé exactement la sélection d'un mouvement vibratoire.

C'est le même phénomène qu'on applique dans un récepteur de T.S.F.

La résonance du circuit récepteur.

L'antenne réceptrice, ou collecteur d'ondes, est frappée par des rayons hertziens épars. Chacun de ceux-ci donne naissance à un courant à haute fréquence. Cette fréquence est naturellement égale à la fréquence de l'émission. C'est dire, en d'autres termes, que le courant qui prend naissance dans le collecteur d'ondes est la réplique exacte du courant qui parcourait l'antenne d'émission. En somme, les électrons du collecteur d'ondes, liés aux électrons de l'antenne d'émission par le rayonnement, sont animés de mouvements semblables...

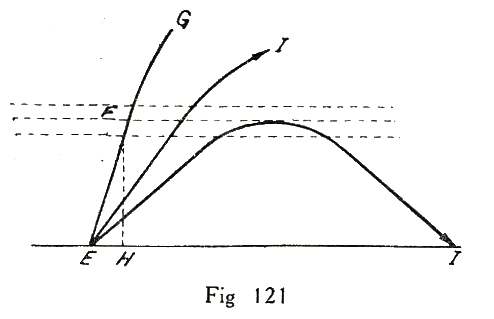

Or, parmi tous les rayonnements épars à un moment donné, un seul nous intéresse. Il nous faut le sélectionner, c'est-à-dire faire naître pour lui des circonstances favorables, telles que son amplitude devienne prépondérante par rapport aux autres vibrations. Pour cela neus ferons tout simplement appel à la résonance.

Nous avons appris plus haut qu'à un circuit oscillant de dimensions électriques données, correspondait une fréquence d'oscillation bien définie, exactement comme la longueur du fil de suspension définit la fréquence du pendule.

Si nous intercalons dans le collecteur d'ondes un circuit oscillant accordé précisément sur la fréquence de l'émission désirée, nous aurons fait naître les circonstances favorables. L'amplitude du mouvement électronique sera considérablement plus grande. Nous aurons, en même temps, réalisé une sorte d'amplification et la sélection du rayonnement que nous désirions.

Récapitulons un peu.

Il n'est pas inutile de faire maintenant le bilan de nos dernières acquisitions. Lorsque, dans un conducteur, on a su communiquer aux électrons un mouvement vibratoire à haute fréquence, on a produit, par ce fait même, un rayonnement électromagnétique qui s'est propagé au loin.

Les électrons des corps conducteurs, touchés par ce rayonnement, ont été eux-mêmes animés d'un mouvement vibratoire à la même fréquence. En favorisant cette vibration des électrons, grâce à un circuit oscillant accordé, nous avons favorisé le courant correspondant à l'émission que nous désirions recevoir. Nous en sommes là. Le but n'est pas atteint encore.

Le courant produit dans le circuit oscillant est d'une intensité très faible. De plus, c'est un courant à haute fréquence. Il ne saurait donc être question de le mettre en évidence à l'aide de moyens grossiers. Notre but, c'est, en somme, de rendre le signal perceptible à l'un de nos sens. On pourra s'adresser à la vue ou à l'ouïe. Dans le premier cas, l'idéal sera la Radiovision ou Télévision ; dans le second cas, ce sera la Téléphonie sans fil.

Un cas particulier plus simple sera réalisé par la télégraphie sans fil. Le signal est simplement découpé en signaux de rythme convenu, qu'on traduit à l'aide d'une clé. Mais il faut toujours obtenir une traduction sensible du signal.

Examinons le cas le plus simple d'une transmission de signaux morses à l'aide d'un générateur à étincelle. Nous avons appris plus haut comment fonctionnait un tel générateur. A chaque étincelle, l'oscillation du circuit émetteur se produit. Cette oscillation est de faible durée, à cause de l'amortissement. Mais un rayonnement de courte durée est cependant produit à chaque étincelle, provoquant là décharge oscillante du condensateur.

Le rythme des étincelles est choisi pour correspondre à une fréquence acoustique. Il s'agira, par exemple, de 800 périodes par seconde.

Cela veut dire que, 800 fois chaque seconde, les électrons de l'antenne d'émission seront secoués par des vibrations à haute fréquence et enverront dans l'espace un rayonnement.

Le même phénomène se reproduira dans l'antenne réceptrice 800 fois par seconde, et pendant un temps très bref, les électrons du circuit récepteur entreront en vibration.

Nécessité de la détection.

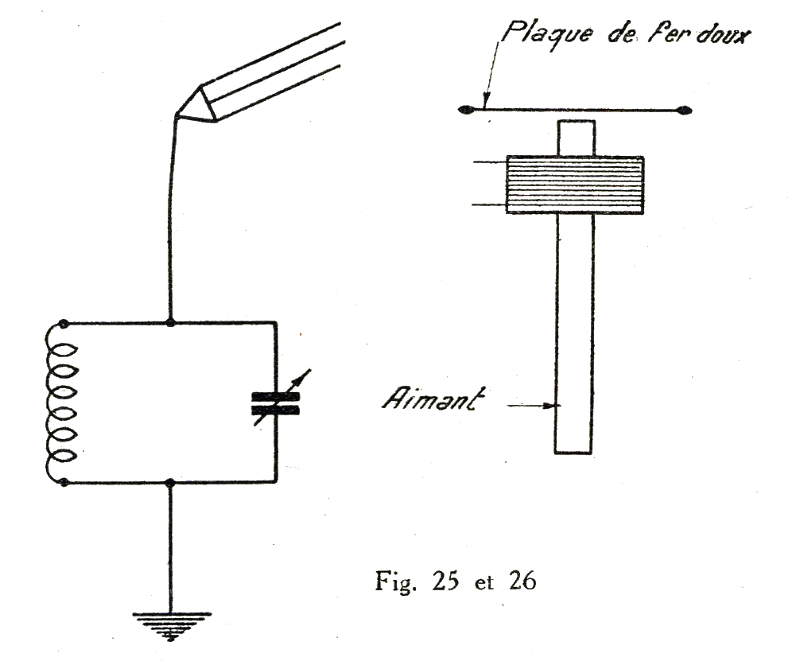

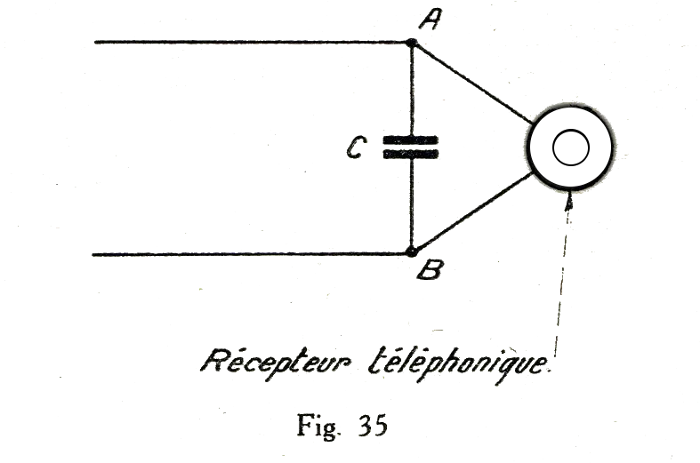

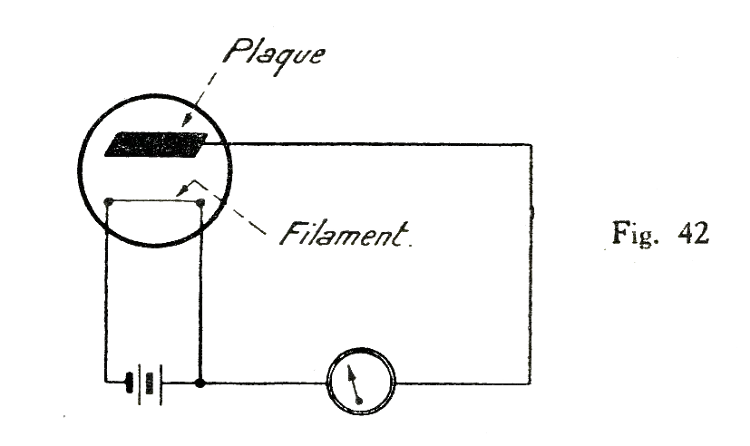

Un téléphone ou un écouteur téléphonique est un appareil très simple et très sensible qui transforme un courant électrique vibratoire en un son.

L'engin est constitué en principe par un aimant (fig. 26) portant une bobine placée au voisinage d'une plaque de fer doux. Celle-ci est attirée par l'aimant. Les courants qui traversent la bobine produisent des variations du champ magnétique de l'aimant. Par conséquent la plaque métallique subit des attractions plus ou moins fortes. Elles s'incurvent plus ou moins vers l'aimant et ce mouvement, qui suit fidèlement les variations du courant communiqué à l'air ambiant est transformé en un son dont la fréquence ou hauteur acoustique est précisément égale à la fréquence du courant électrique.

Suffira-t-il d'intercaler quelque part un écouteur téléphonique pour convertir le circuit de la figure 25 en un récepteur complet ?

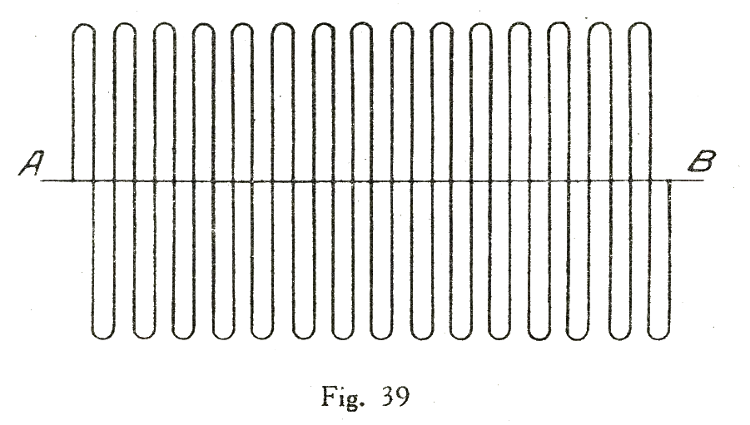

En supposant cela nous ferions une grave erreur. Le circuit de la figure 25 n'est point parcouru par un courant à 800 périodes par seconde, mais par un courant à haute fréquence se produisant 800 fois par seconde.

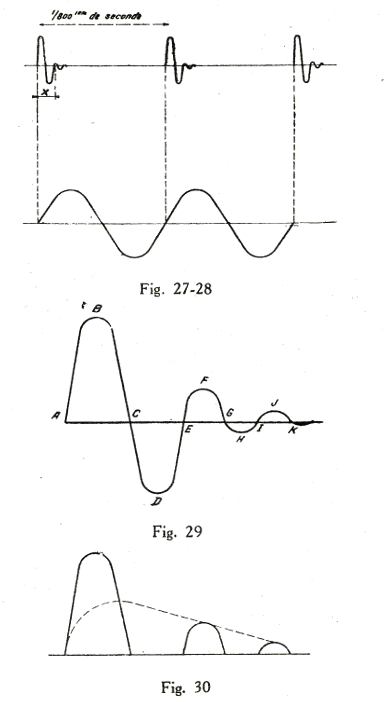

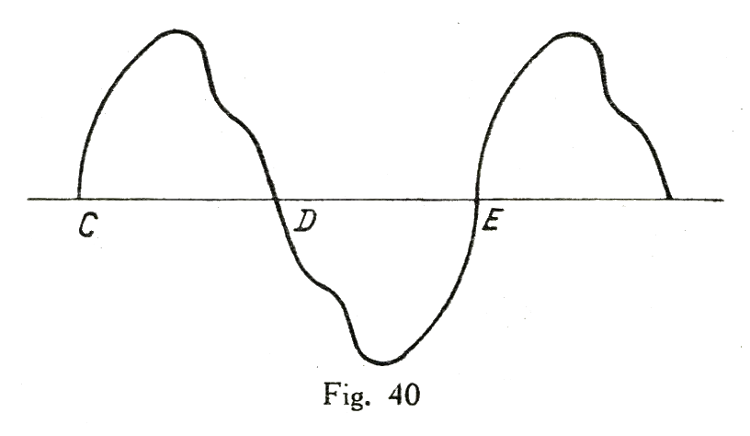

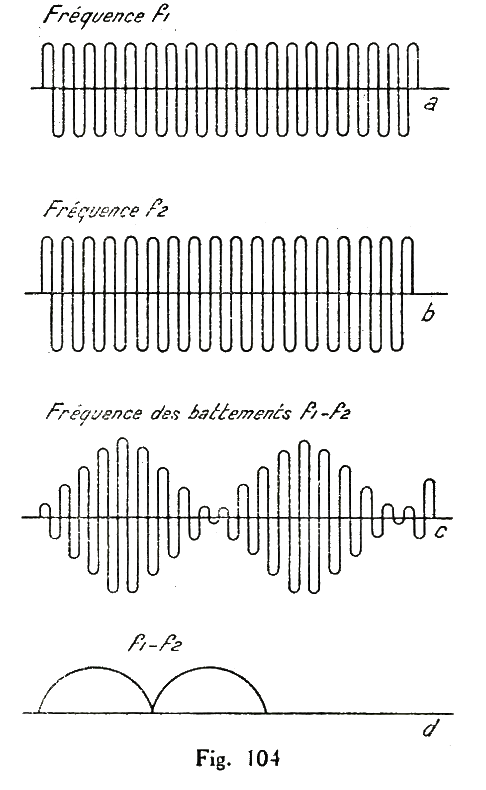

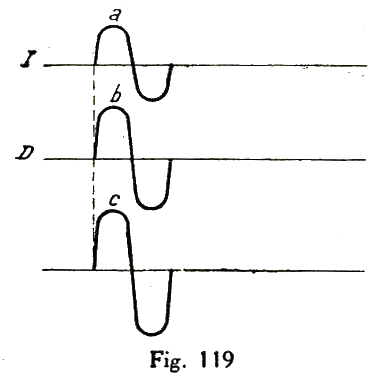

Ce n'est point du tout la même chose, et la représentation graphique va nous donner de cela une excellente démonstration. Le courant qui traverse l'antenne peut être représenté comme sur la figure 27. Il y a, chaque 1/800° de seconde, un groupe d'oscillations amorties. On voit clairement que la fréquence de ces oscillations, que nous avons marquées x, ne doit pas être confondue avec la durée qui sépare deux étincelles.

Qu'advient-il si l'écouteur téléphonique est inséré dans le circuit sans autre disposition ?

En admettant qu'il soit d'une fidélité parfaite et que la plaque vibrante puisse suivre toutes les impulsions du courant qui le traverse, le son correspondrait non pas à la fréquence de 800 périodes, mais à celle de l'oscillation à haute fréquence.

Or, notre oreille n'est sensible qu'à des vibrations dont la fréquence est pratiquement comprise entre 50 et 10.000 périodes par seconde. Ainsi, même en admettant que la plaque puisse vibrer, notre oreille demeurerait insensible à cette vibration...

Mais cela même n'est pas admissible. L'inertie de la plaque est beaucoup trop grande pour lui.

A peine la plaque a-t-elle pu esquisser un mouvement dans un sens qu'elle est sollicitée dans l'autre sens. Aussi, en fait, demeure-t-elle immobile, dans l'expectative...

La plaque de l'écouteur ne bouge pas, parce qu'elle reçoit trop rapidement des impulsions dans les deux sens.

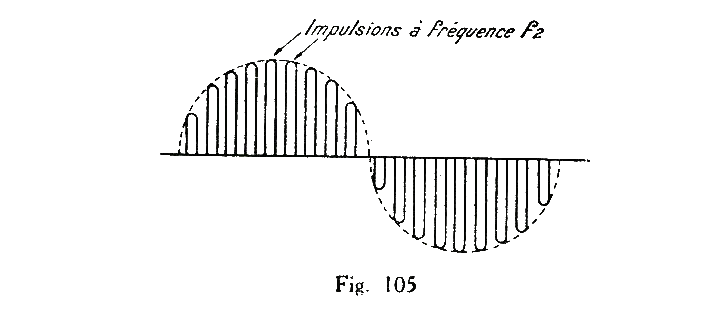

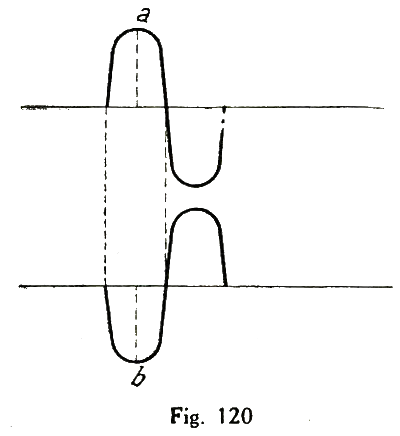

Représentons figure 24 une image agrandie du courant à haute fréquence. La partie ABC correspond à une impulsion dans un sens ; la partie C D E à une impulsion dans l'autre sens, etc...

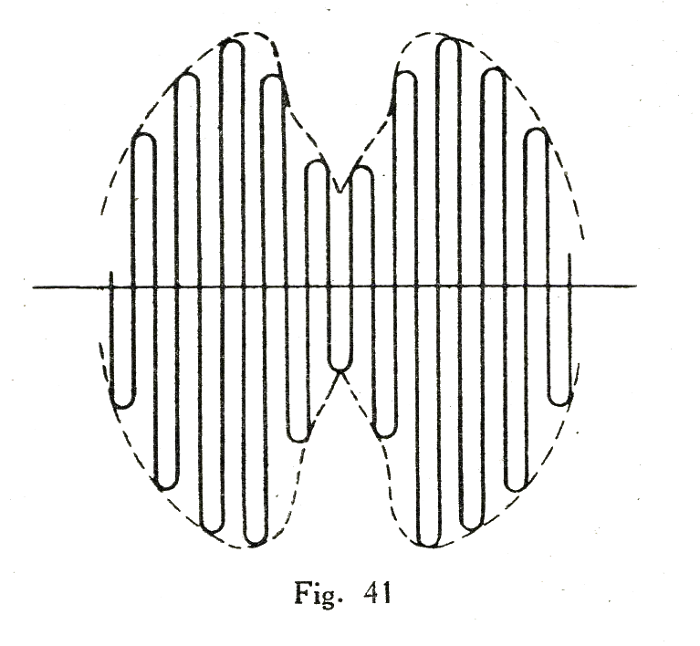

Supposons que nous parvenions à supprimer les parties comme C D E, G H I. Cette fois, toutes les impulsions reçues par la plaque seront dans le même sens et, par conséquent, ajouteront leurs effets.

Si nous intercalons cette fois l'écouteur téléphonique, sa plaque vibrante subira une impulsion à chaque passage d'oscillation. Or, comme il y a précisément 800 impulsions par seconde, la plaque vibrante transmettra à notre oreille un son à 800 périodes par seconde.

Pour rendre le rayonnement perceptible à notre sens, il suffit donc :

- D'intercaler un dispositif permettant d'éliminer les fragments d'oscillations comme C D E, G H I, etc... ;

- De placer un écouteur téléphonique dans le circuit.

Ainsi, nous aurons réalisé un récepteur complet.

Un élément important, c'est ce dispositif que nous avons défini plus haut.

Son rôle est précisément de mettre en évidence, de déceler les oscillations, d'où son nom de détecteur.

On peut, à la rigueur, concevoir un récepteur de T.S.F. qui n'ait ni circuit oscillant ni collecteur d'ondes apparent ; on ne peut en concevoir qui n'ait point de détecteur.

Principe de la détection.

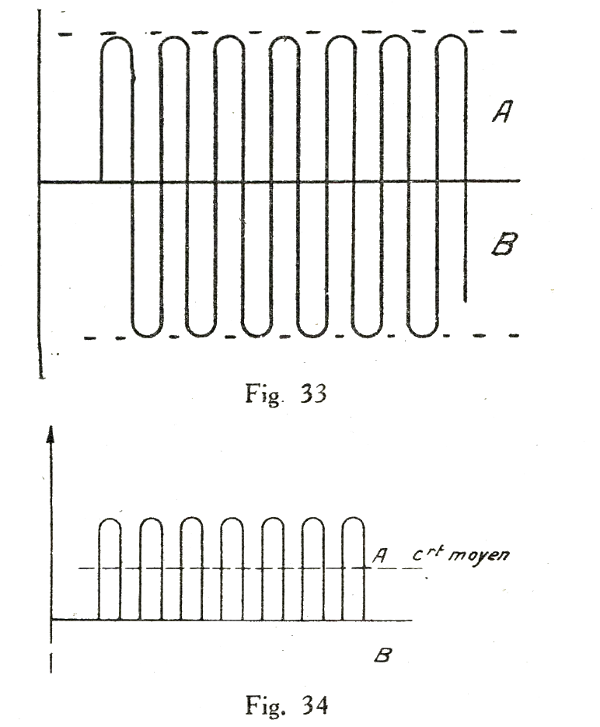

La détection consistera donc à éliminer les parties d'oscillation comme C D E, G H I, etc...

On obtiendra alors une représentation graphique comme nous l'avons indiqué figure 25. Pratiquement, la plaque du téléphone recevra trois impulsions successives, très rapprochées, dont l'effet concordant se confondra.

En fait, tout se passera comme si le courant correspondait à la représentation graphique indiquée en pointillé. Si nous voulions aller au fond des choses, nous pourrions apprendre que le fait de détecter une onde a pour but la création d'un courant moyen.

En effet, le courant moyen est nul, dans le cas d'une oscillation comme sur la figure 24, et dans la figure 25, le courant moyen a précisément la forme de la ligne pointillée.

Remarquons que les fractions d'oscillations comme A B C, E F G, etc..., correspondent au déplacement des électrons dans un certain sens.

Les fractions comme C D E, G H I, correspondent au déplacement des électrons dans un autre sens.

Détecter, c'est donc, en somme, ne laisser circuler les électrons que dans un seul sens. Pour cela il ne suffit évidemment pas de placer sur le conducteur un écriteau rouge portant la mention « sens interdit ».

Il faut imaginer des systèmes ne permettant le passage du courant que dans un seul sens. Ces systèmes sont des redresseurs de courant, car si on leur soumet du courant alternatif, c'est-à-dire du courant qui oscille alternativement dans un sens puis dans l'autre, ils fournissent du courant unidirectionnel ou courant redressé.

Lorsque ces systèmes peuvent fonctionner avec des courant de haute fréquence, ce sont des détecteurs.

Détecteurs à contacts.

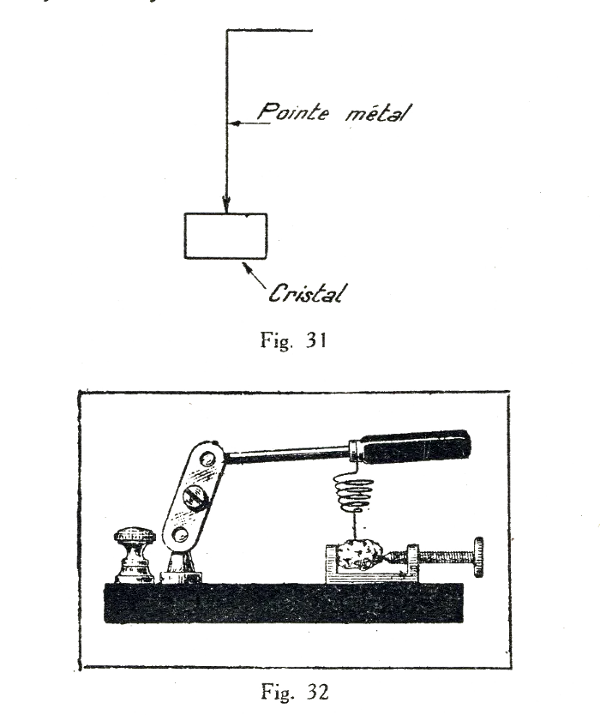

Détecteur à cristal.

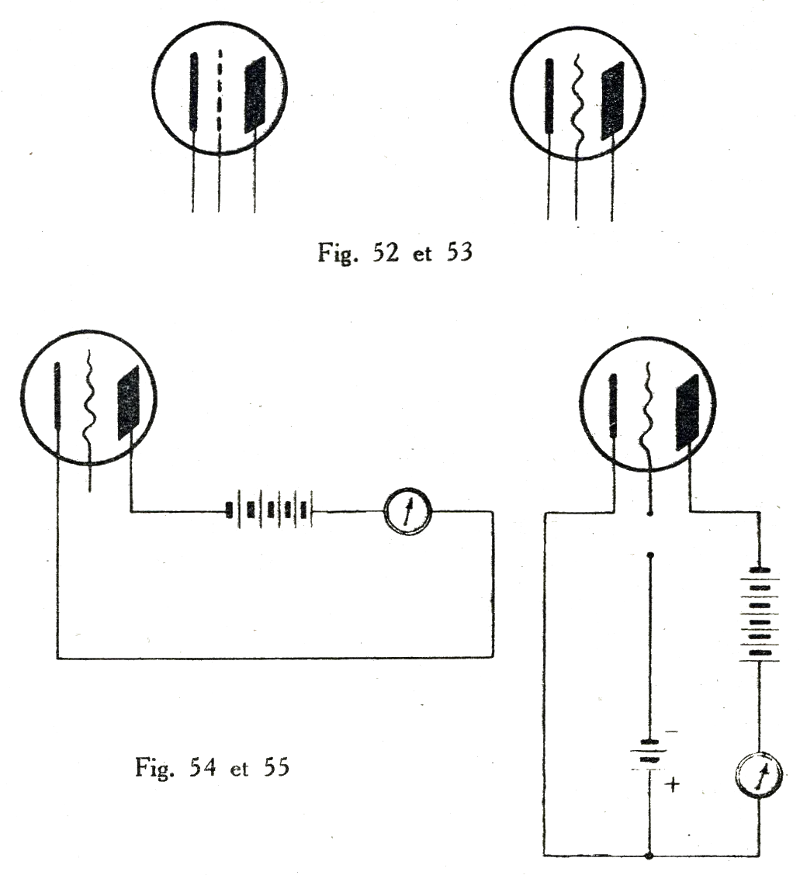

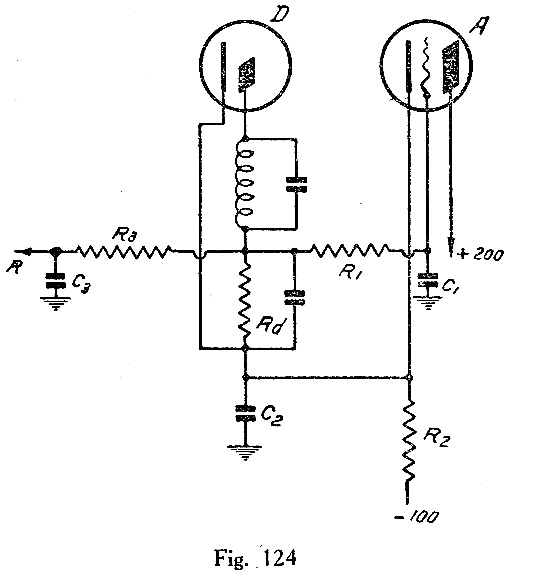

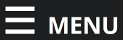

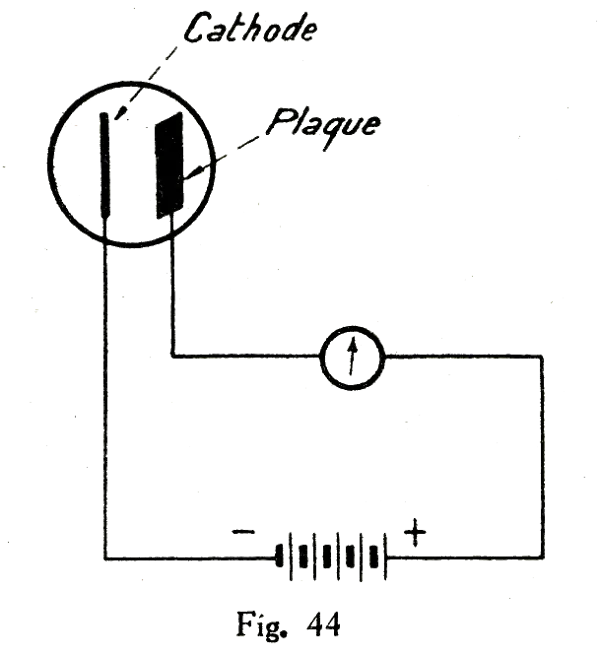

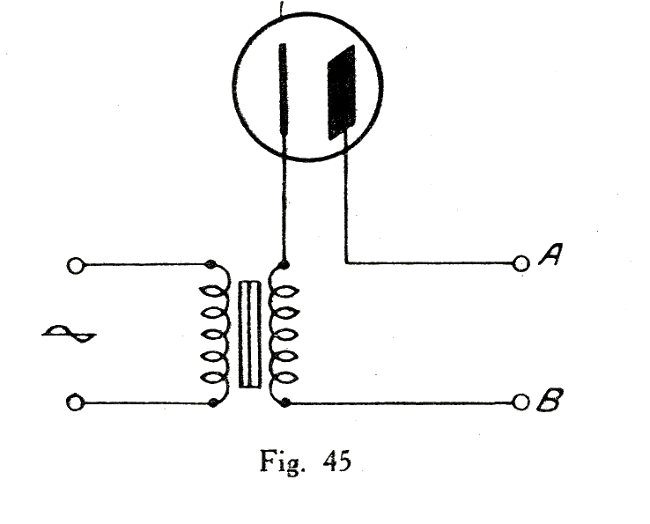

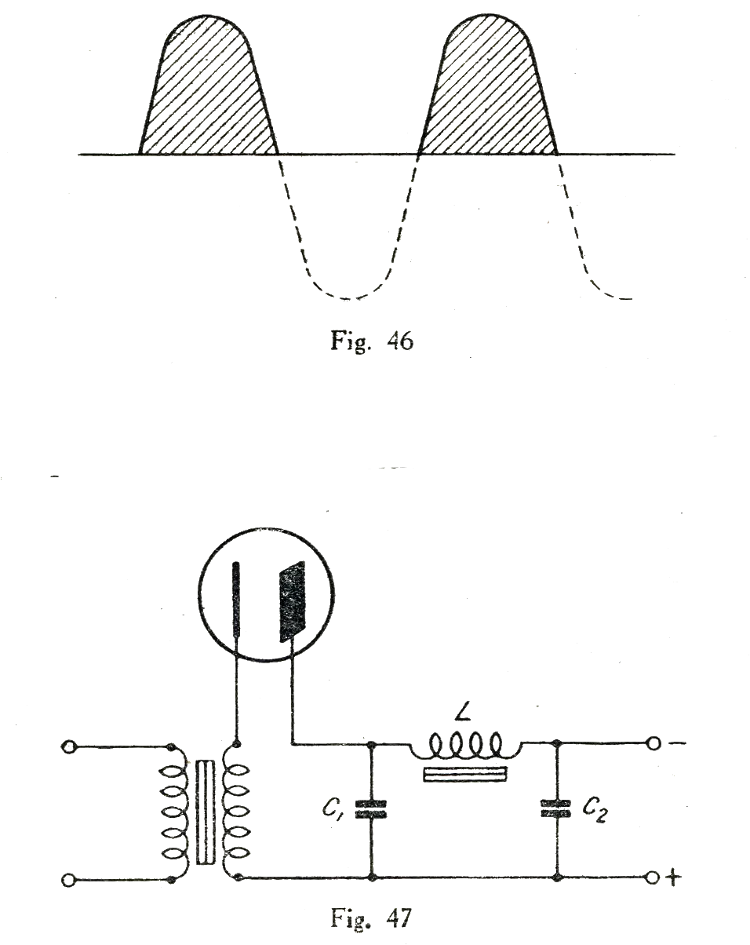

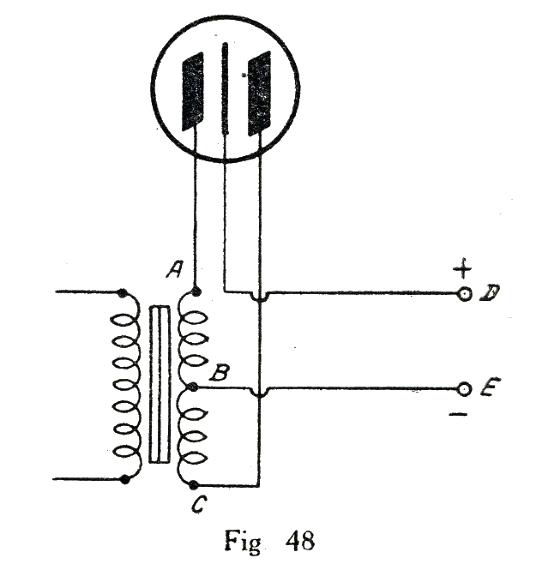

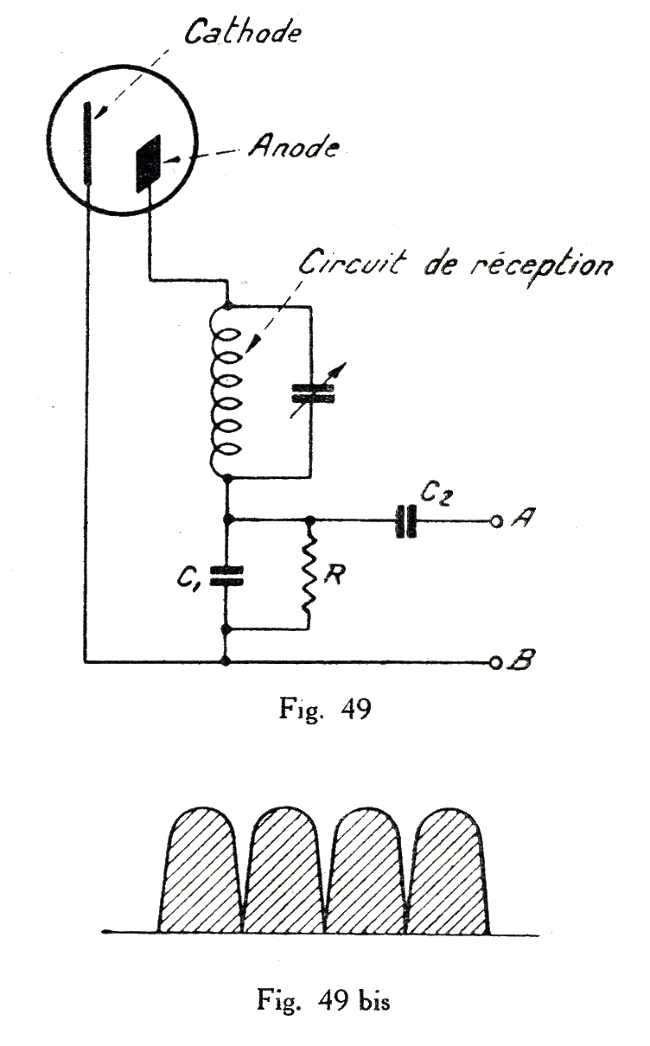

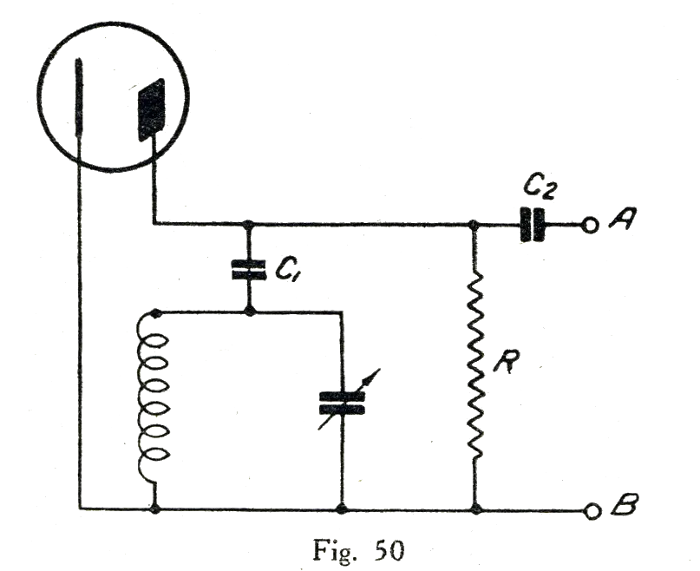

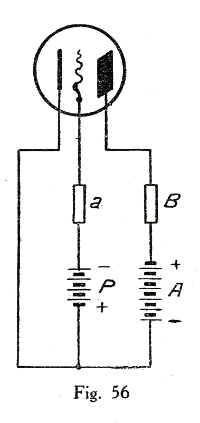

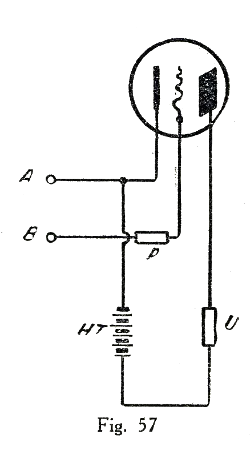

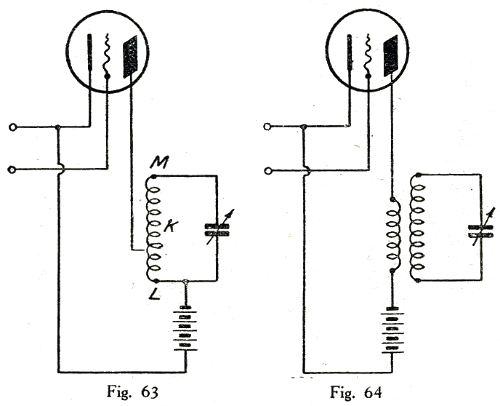

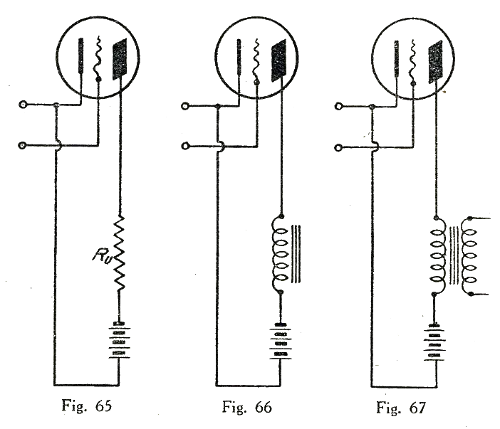

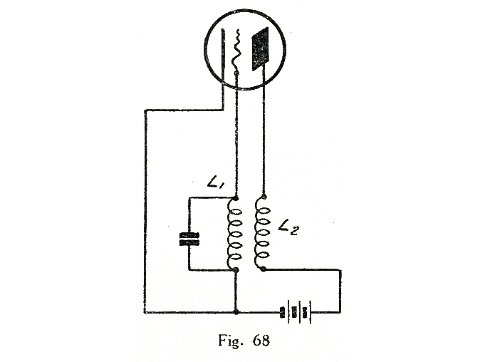

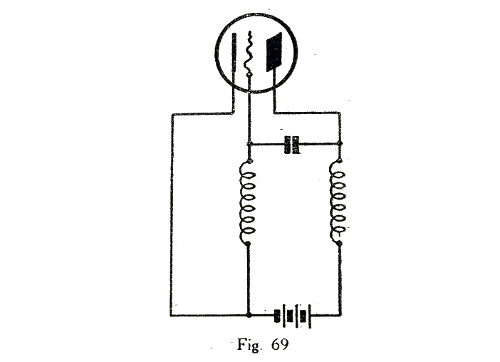

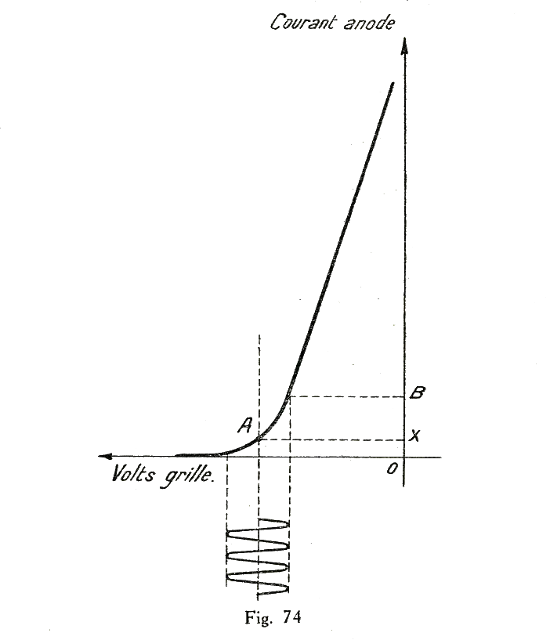

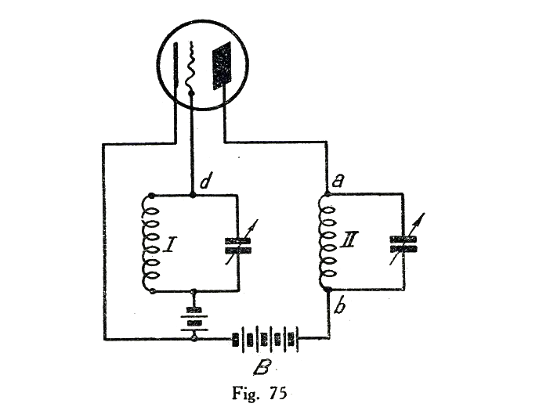

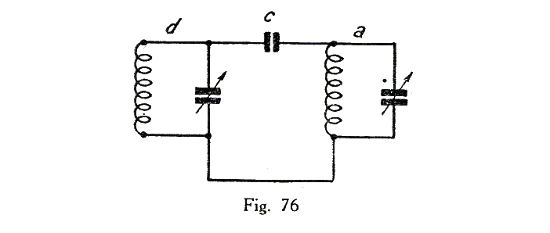

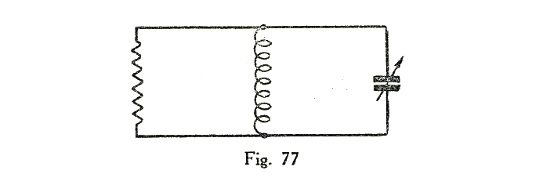

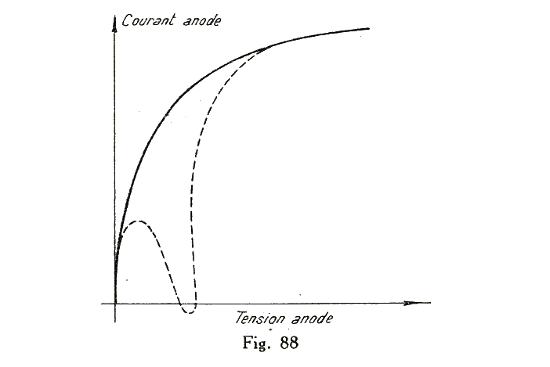

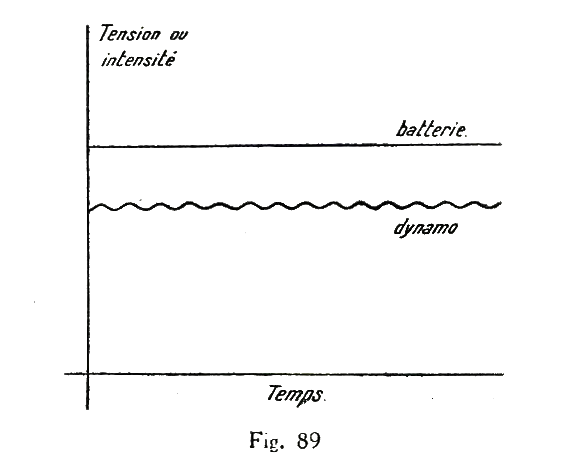

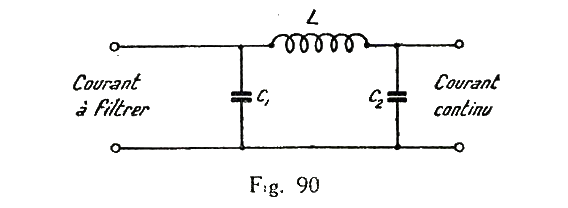

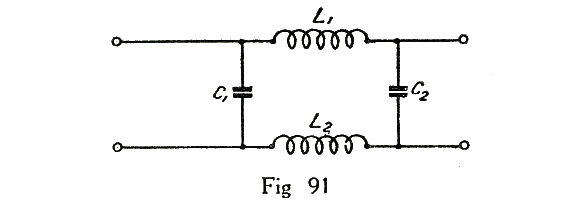

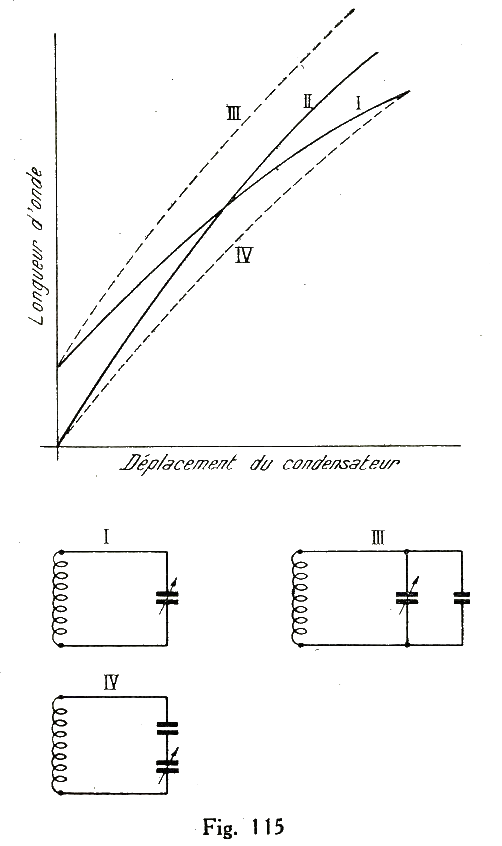

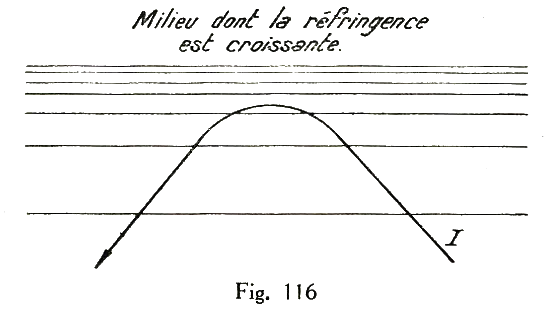

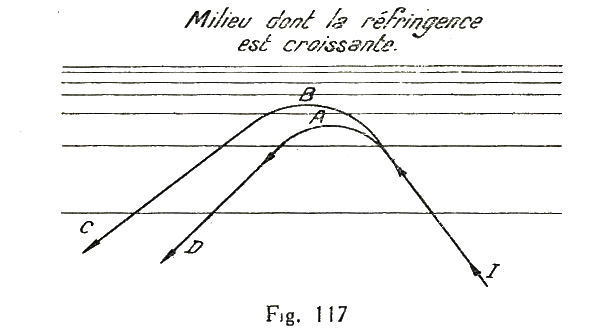

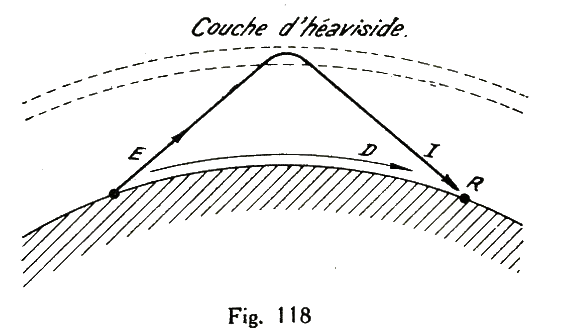

Ces détecteurs, comme beaucoup d'autres, n'ont plus guère aujourd'hui qu'un intérêt historique. Il existe cependant de fervents amateurs du récepteur à galène.