Numérisation des cours Alain PASQUET, Mise en page Pascal CHOUR - 2016 - 2018

LECON 1

INTRODUCTION

Jusqu’en 1948, le tube électronique était le seul composant doué de la merveilleuse propriété d’amplifier le courant électrique (c’est pour cette raison, qu’on l’appelle "élément ou composant ACTIF" pour bien le distinguer des autres composants dits "passifs" tels que résistances, condensateurs, etc…). Le tube électronique était donc la pièce maîtresse dans toutes les communications radio-électriques et dans l’électronique en général.

En 1948, deux savants américains des laboratoires de recherches de la Bell Telephone, John BARDEEN et Walter H. BRATTAIN, annoncent au monde entier la découverte d’un nouveau composant actif ayant des caractéristiques analogues à celles des tubes électroniques : ils lui donnent le nom de "TRANSISTOR". Expliquer dès maintenant la signification d’un tel mot serait prématuré : il suffit pour le moment de savoir qu’il dérive de 2 mots : "Transfert" et "Résistance".

On pourrait penser, vu la provenance de ce nom, qu’un tel dispositif n’a que peu de relations avec un tube électronique surtout si l’on songe à sa propriété fondamentale, qui est l’amplification d’un courant électronique.

Bien que dans les 2 cas, le phénomène d’amplification soit obtenu par contrôle de l’intensité d’un flux d’électrons, le mode de production d’un tel flux et son contrôle sont totalement différents.

Il suffit pour cela de se rappeler que dans le cas des tubes, le milieu dans lequel se propage le flux électronique (courant anodique) est le vide existant dans l’ampoule qui forme l’enveloppe extérieure du tube, et que pour obtenir un tel flux, on doit porter la cathode à une forte température afin de déclencher le phénomène thermoïonique (ou émission thermique). Dans le cas des Transistors, par contre, le milieu dans lequel se déplacent les électrons est un solide, dont les propriétés peuvent être considérées comme intermédiaires entre celles des conducteurs et celles des isolants (d’où le nom de "semi-conducteur") ; pour obtenir le flux d’électrons (courant de collecteur, comme nous le verrons plus tard), nous n’avons pas besoin de chauffer une cathode, mais nous nous contenterons d’appliquer une tension continue aux électrodes du Transistor : de la même façon que l’on obtient un courant dans une résistance, lorsque l’on applique une tension à ses bornes.

Les analogies entre tubes et transistors s’arrêtent là : les phénomènes et les lois qui les régissent sont totalement différents.

Cette constatation amène une conclusion de caractère didactique extrêmement importante même si à première vue, elle parait, un non-sens ; la connaissance des tubes électroniques n’est pas un avantage dans l’étude des Transistors. Elle peut même devenir un inconvénient en ce sens que l’on cherche à faire naturellement des analogies entre tubes et transistors, analogies qui ne sont que superficielles et qui n’engendrent que des confusions.

L’étude des transistors devrait être complètement indépendante de l’étude des tubes électroniques et seules des comparaisons fort prudentes pourraient être avancées, et seulement lorsqu’il s’agit de passer d’un circuit composé de tubes, à un circuit à transistors ayant les MÊMES FONCTIONS. On dit d’ailleurs couramment, qu’un tel circuit est "Transistorisé".

Pour comprendre le fonctionnement des transistors, il est absolument indispensable de bien connaître, et de très près encore, les semi-conducteurs, en étudiant leurs propriétés physique et électriques. La compréhension de leur mode de fonctionnement ne peut être totale que si l’on s’est penché sur le monde de l’infiniment petit, c’est-à-dire sur le monde des atomes et des électrons.

L’étude des semi-conducteurs occupe un important chapitre de la science moderne : "la physique de l’état solide" dont les origines sont encore relativement anciennes. La première découverte sur les semi-conducteurs, c’est-à-dire sur la particularité de certaines substances à n’être ni des conducteurs ni des isolants, fut faite par FARADAY en 1833 (son nom est plus connu encore en Radio-électricité, et a servi à désigner l’unité de mesure de la capacité : le Farad).

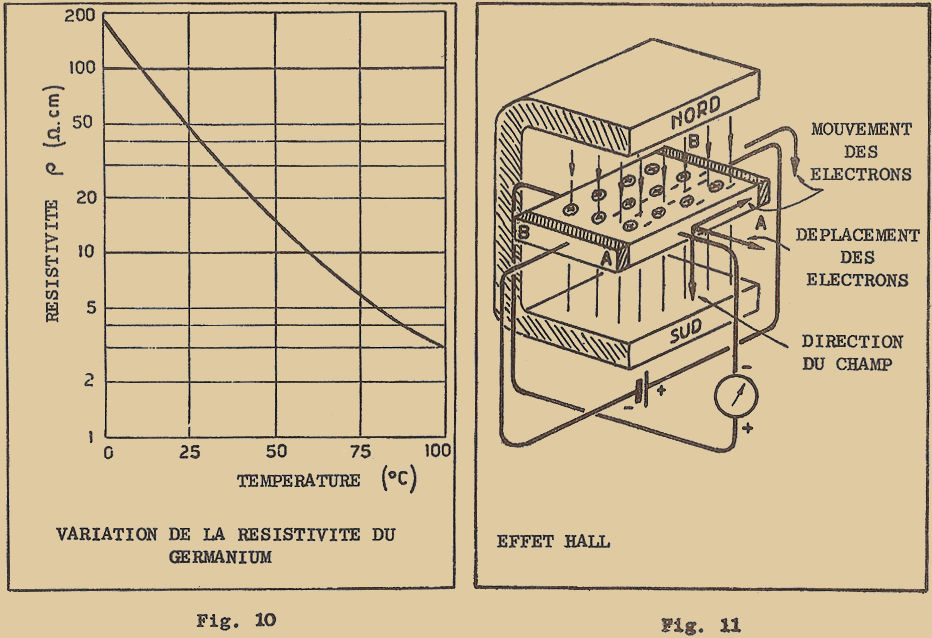

FARADAY avait découvert en effet que le sulfure d’Argent présentait un coefficient de résistance négatif, ce qui signifie que sa résistance électrique diminue lorsqu’on le chauffe, contrairement à ce qui se passe pour les métaux dont la résistance augmente avec la température.

Quelque temps après, d’autres importantes propriétés des semi-conducteurs furent découvertes ; effet de REDRESSEMENT (c’est-à-dire propriété de laisser passer le courant plus facilement dans un sens que dans l’autre) ; PHOTOCONDUCTIVITÉ (c’est-à-dire propriété de présenter une résistance électrique différente selon la quantité de lumière reçue par la surface du semi-conducteur) ; PHOTO-ÉLECTRICITÉ (c’est-à-dire propriété de transformer l’énergie lumineuse en énergie électrique).

Les premières applications des semi-conducteurs furent faites à la fin du siècle dernier, après la découverte des ondes hertziennes et les expériences de MARCONI. On utilisait alors le carborundum et la galène (sulfure de plomb) pour la détection des ondes Radio.

Un autre pas en avant fut accompli après la première guerre mondiale, avec la production à l’échelle industrielle de redresseurs secs au sélénium (en 1920) et à l’oxyde de Cuivre (1926), encore très répandus de nos jours. Leur fabrication était alors faite de façon empirique, car on ne connaissait pas encore très bien les phénomènes de redressement de tels matériaux.

Les études sur les semi-conducteurs furent poursuivies toujours plus vigoureusement avec la découverte de nouveaux matériaux semi-conducteurs ; comme le silicium, et on remarqua que leurs propriétés de redressement s’amélioraient très nettement en utilisant des cristaux de silicium non parfaitement purs, mais contenant des quantités infimes d’impuretés. Pendant la seconde guerre mondiale, apparurent les diodes au silicium qui trouvèrent un champ d’application très vaste avec les fréquences extrêmement élevées (micro-ondes) utilisées dans les circuits Radars comme diodes de détection et comme mélangeuses.

La découverte du Transistor survint quelques années seulement après la fin de la seconde guerre mondiale en 1948.

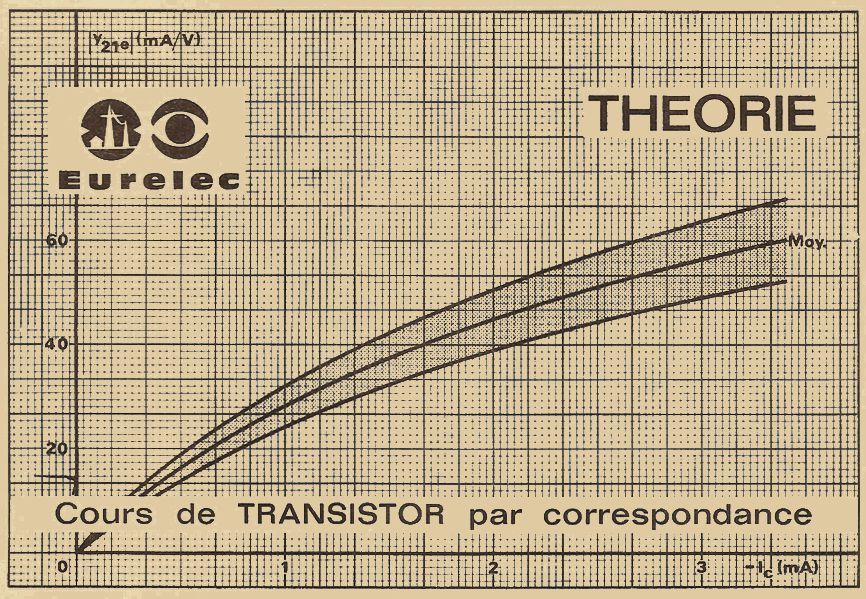

Les savants BARDEEN et BRATTAIN effectuaient des expériences très poussées pour vérifier expérimentalement la présence de charges électriques à la surface d’un cristal semi-conducteur, comme la théorie le laissait prévoir.

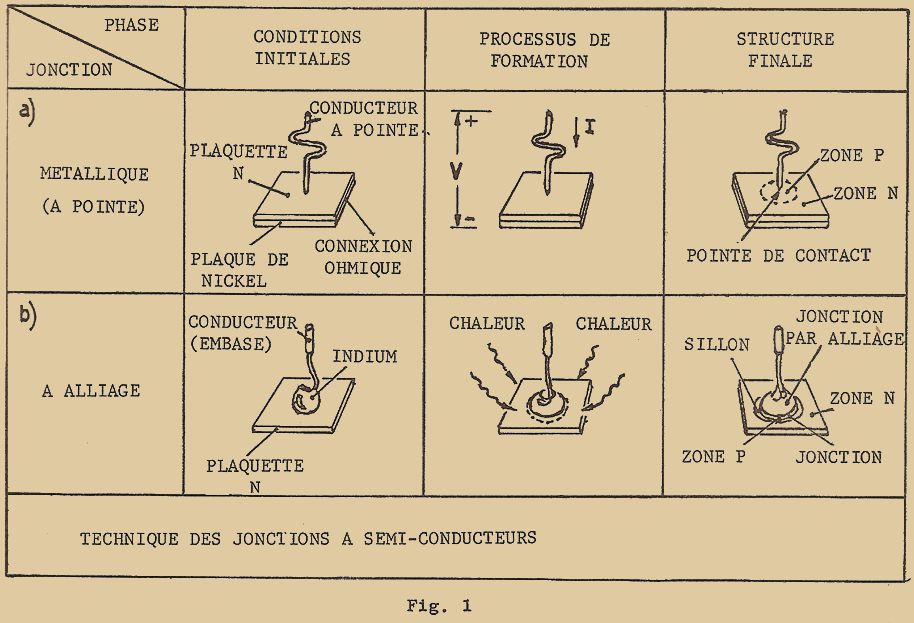

A cette fin, ils avaient disposé sur une plaquette métallique un cristal semi-conducteur. Sur ce cristal, ils avaient appuyé deux pointes métalliques de façon à former deux contacts en forme de pointe (figure 1). Pendant l’expérience, ils constatèrent un étrange phénomène : le courant qui se dirigeait d’une des pointes vers la plaquette métallique en traversant le cristal était "influencé" par le courant qui se dirigeait de la seconde pointe à la même plaquette : en d’autres termes, le courant d’une des deux pointes pouvait être COMMANDÉ par l’intermédiaire du courant de la seconde pointe.

Le phénomène était donc comparable à celui qui se manifeste dans les tubes électroniques, dans lesquels le COURANT entre 2 électrodes (cathode et plaque) est commandé en agissant sur la TENSION appliquée sur une 3ème électrode (grille). Tout ceci laissait supposer que le dispositif avait la propriété, tout comme les tubes, d’AMPLIFIER le courant électrique.

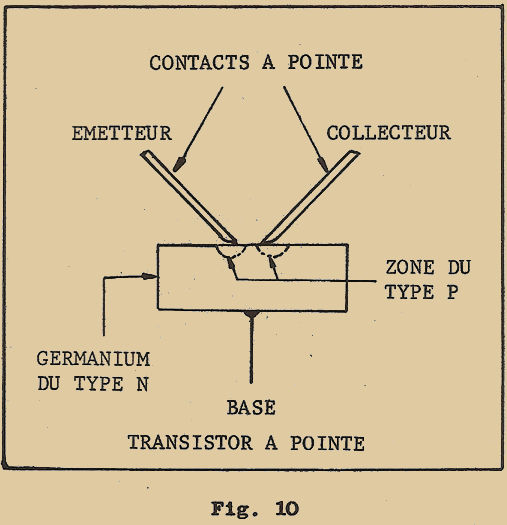

Amélioré et perfectionné, un tel dispositif a constitué le premier type de transistor dit "à pointes", qui n’a pas bénéficié d’une très grande diffusion, à cause de deux défauts principaux : l’extrême petitesse des contacts à pointes limitait la puissance à des valeurs extrêmement faibles ; l’instabilité des contacts, rendait les caractéristiques des transistors très variables dans le temps, et ceux-ci étaient en outre générateurs de bruit.

En dépit de cela, la découverte du transistor "à pointes" a marqué d’une pierre blanche les progrès de l’électronique, et les études poursuivies pour expliquer le phénomène ont conduit le savant William SHOCKLEY (de la Bell Telephone) à présenter en 1951, un nouveau type de Transistor ayant des caractéristiques améliorées par rapport au Transistor à pointes : on l’appellera plus tard : "Transistor à Jonction".

Il faut souligner le fait que W. SHOCKLEY a découvert et étudié les caractéristiques du transistor à jonction par une voie purement théorique : ce n’est seulement que 3 ans plus tard, en 1954, que grâce au succès de W.G. PFANN à obtenir du germanium suffisamment pur, il a pu réaliser le premier transistor à jonction et démontrer expérimentalement les prévisions théoriques de sa découverte.

Après une certaine période d’essais expérimentaux, le Transistor apparut sur le marché et commença à concurrencer le tube électronique.

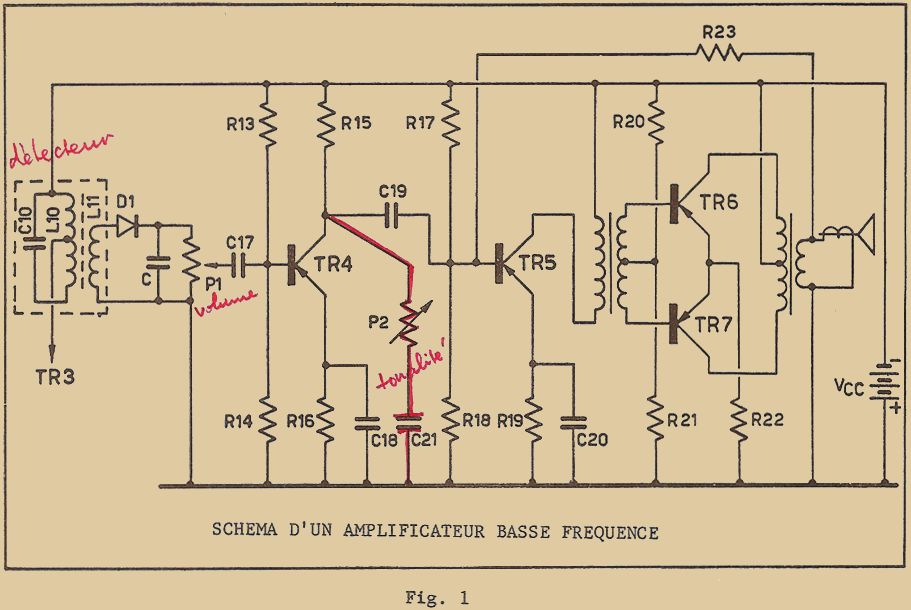

Les premiers transistors commerciaux étaient prévus pour la basse fréquence et pour les puissances relativement faibles. Leur utilisation était limitée à des amplificateurs BF., et aux premiers récepteurs radio appelés "hybrides" car ils comportaient des tubes pour les étages haute fréquence et moyenne fréquence et des transistors pour les étages BF.

Au fur et à mesure que la technique de fabrication s’améliorait, on fabriqua des transistors pour des fréquences de plus en plus élevées, et les récepteurs radio se "transistorisèrent" de jour en jour : non seulement, les tubes furent totalement éliminés, mais on commença à recevoir les ondes moyennes, puis courtes, pour arriver bientôt aux ondes ultra-courtes de la modulation de fréquence.

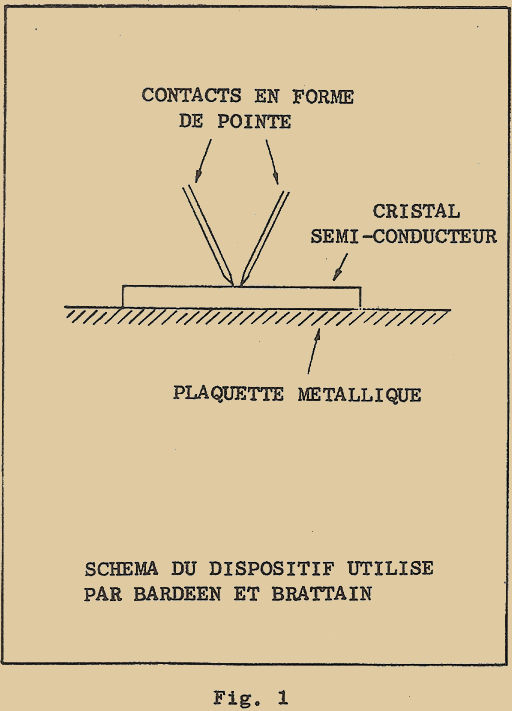

Les avantages des transistors par rapport aux tubes sont nombreux : en premier lieu, les dimensions des transistors sont notablement plus faibles que celles des tubes, même pour les tubes du type miniature. A la figure 2, je vous donne la comparaison avec un tube miniature de puissance (120 mW environ).

En second lieu, comme je vous l’ai déjà dit, le transistor ne nécessite aucune énergie de chauffage, et par conséquent consomme bien moins qu’un tube, lequel exige selon son type, et ceci uniquement pour le chauffage, une puissance de 1 à 3 W.

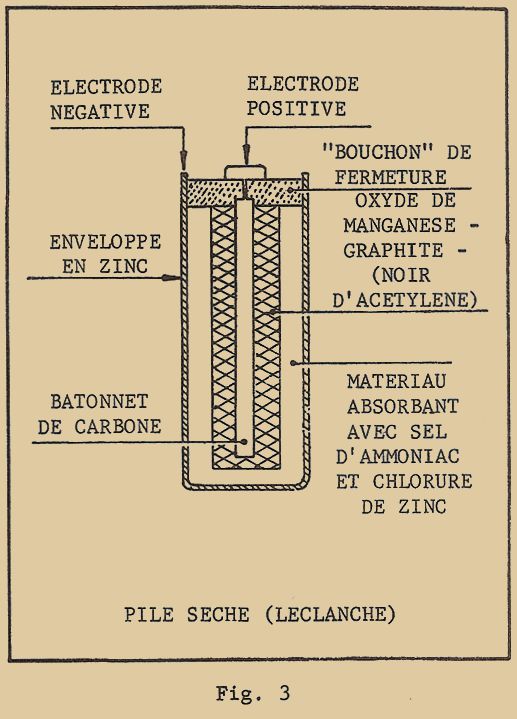

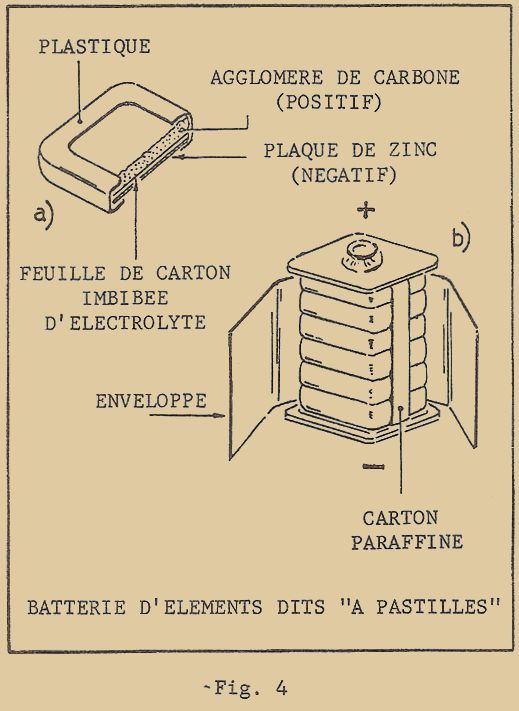

De plus, la tension de collecteur (qui correspond à la tension plaque) est souvent au maximum de 12V. Les appareils transistorisés peuvent donc fonctionner facilement avec une pile à basse tension, et qui de plus a une longue durée du fait de la faible consommation de courant.

Par constitution, le transistor est plus simple et plus robuste qu’un tube, étant donné qu’il est formé par une minuscule plaquette de cristal de germanium sur laquelle sont soudés 3 fils de connexions. Sa résistance aux chocs est beaucoup plus grande et sa vie pratiquement illimitée car il n’y a pas épuisement avec la durée d’utilisation comme c’est le cas pour les cathodes des tubes.

Par contre, il présente quelques inconvénients parmi lesquels les plus importants sont les suivants. Les transistors sont relativement fragiles du point de vue électrique : il suffit d’une surtension ou d’un courant anormalement élevé dû par exemple à un court-circuit accidentel pour le détruire définitivement. Leurs caractéristiques varient beaucoup avec la température et on ne peut les utiliser sans précautions particulières à des températures élevées (température maximum 70° C).

Les transistors d’un même type peuvent présenter des caractéristiques électriques assez différentes : d’ailleurs dans certains cas, comme par exemple pour un push-pull BF final, le fabricant donne des transistors apairés dont les caractéristiques sont très voisines.

Ce dernier inconvénient est assez important, surtout lorsque l’on doit procéder au remplacement d’un transistor détérioré. Dans quelques cas critiques, on pourra être amené à devoir trier le transistor désiré parmi plusieurs autres du même type.

Malgré tous ces inconvénients, les transistors ont trouvé de larges applications qui leur font progressivement remplacer les tubes électroniques dans tous les cas où il y a un problème de place, de poids, de consommation de courant.

Voici deux exemples différents : les amplificateurs pour surdité qui se trouvent placés dans un volume très réduit derrière l’oreille ; les circuits électroniques complexes placés dans les fusées télécommandées et les satellites artificiels.

Il ne faut pas cependant déborder d’un optimisme exagéré et affirmer que dans un avenir très proche les tubes électroniques vont disparaître. Bien que la technique des transistors aille rapidement de l’avant et se perfectionne de jour en jour, tubes et transistors sont de constitutions tellement différentes que ces derniers ne peuvent pas concurrencer les tubes dans certains domaines, et il y aura obligatoirement coexistence des deux.

Dans ce cours, l’étude des transistors sera subdivisée en 3 parties distinctes que nous intitulerons comme suit :

- NOTIONS SUR LA STRUCTURE DE LA MATIÈRE : c’est un chapitre relativement bref, réduit à l’indispensable pour bien comprendre le fonctionnement des transistors, et servant à l’introduction du chapitre suivant.

- PHYSIQUE DU TRANSISTOR, SES CARACTÉRISTIQUES ET SES PROPRIÉTÉS : description des différents types de transistors et quelques notions technologiques sur leur fabrication.

- CIRCUITS A TRANSISTORS : c’est le chapitre le plus important du Cours. Dans cette partie, je vous décrirai les différents circuits les plus couramment utilisés en technique Radio, tant du point de vue physique, pour une bonne et rapide compréhension de leur fonctionnement, que du point de vue calculs, donnant ainsi à ceux d’entre vous qui sont intéressés par la réalisation de circuits à transistors toutes les formules et méthode utiles.

INTRODUCTION

1 – CONSTITUTION DE LA MATIÈRE

1 - 1 MOLÉCULES ET ATOMES

Un des problèmes qui de tous temps a le plus préoccupé l’esprit de l’homme, est celui de la constitution de la Matière, c’est-à-dire "savoir de quoi étaient formées les différentes substances".

L’hypothèse que la matière pouvait n’être formée que de quelques éléments simples fut avancée par les philosophes grecs de l’Antiquité : ceux-ci pensaient que l’on pouvait obtenir les différentes substances en mélangeant seulement, en quantités appropriées, quatre éléments simples comme : l’AIR, la TERRE et le FEU.

Au 5ème siècle avant Jésus Christ, un autre philosophe grec, Democrite, en partant de telles hypothèses de base, établit pour la première fois, une théorie "atomique" sur la constitution de la matière qui peut être considérée, sous ses différents aspects, comme l’embryon de la théorie atomique moderne. En se basant exclusivement sur des considérations philosophiques, Democrite concevait la matière comme formée de particules élémentaires qui ne pouvaient plus être divisées en d’autres particules plus petites ; c’est pour cette raison, qu’il leur a donné le nom "d’atomes", ce qui en grec signifie "indivisible".

Ces particules, toujours selon DEMOCRITE, étaient dotées d’un mouvement continuel et de leur rencontre accidentelle dépendait l’origine des substances, tandis que leur séparation en signifiait la destruction.

Les particules étant assemblées, laissaient cependant entr’elles des "distances" ce qui faisait que la matière était "pleine de trous". Mais les dimensions des atomes étant tellement petites, l’œil humain ne pouvait les distinguer, et la matière apparaissait solide et compacte.

DEMOCRITE n’avait aucune idée exacte sur les dimensions des atomes, et il ne précisait pas non plus de quelle espèce ils étaient faits. Mais il considérait les atomes comme indestructibles et affirmait que la matière ne pouvait être ni créée, ni détruite, mais seulement transformée. Ce principe fut fondamental pour les physiciens et les chimistes, et ce n’est seulement que ces derniers temps qu’il fut modifié grâce à la théorie de la relativité d’EINSTEIN, qui démontra la possibilité de transformer la matière en énergie (de telles transformations sont aujourd’hui courantes dans les centrales atomiques) et inversement.

Ce n’est qu’en 1808 que le chimiste anglais John DALTON en se basant sur les lois des combinaisons chimiques d’alors, élabora une nouvelle théorie atomique, qui grâce à sa clarté et à l’évidence des données expérimentales sur lesquelles elle se basait, fut immédiatement adoptée par tous les chimistes de l’époque. En se basant sur les constatations expérimentales selon lesquelles un corps composé était formé de quantités bien déterminées d’éléments simples. il devenait évident que ces corps composés devaient être formés de tant de particules élémentaires qui se combinaient les unes aux autres. Par exemple, l’expérience montrait que si l’on mélangeait 1 gramme d’hydrogène à 5 grammes d’azote, on obtenait 6 grammes d’ammoniac. On en déduisait qu’un atome d’ammoniac devait être composé d’un atome d’hydrogène et d’un atome d’azote et que ce dernier devait avoir un poids 5 fois plus grand que celui de l’hydrogène.

DALTON définit ainsi 2 types d’atomes : LES ATOMES SIMPLES, ceux des substances élémentaires, ou éléments, comme par exemple, l’hydrogène, l’azote, l’oxygène, le soufre, le fer, le zinc, le cuivre, le mercure, etc… ; LES ATOMES COMPOSÉS, ceux des substances composées, comme l’ammoniac, l’eau, l’acide nitrique, etc… Chacun des atomes peut être caractérisé par un numéro que DALTON appela "poids de composition", et qui exprime de combien de fois le poids d’un atome considéré est plus grand que celui de l’hydrogène, élément le plus léger de tous ; ainsi, le poids de composition de l’hydrogène était 1, celui de l’azote de 5, etc…

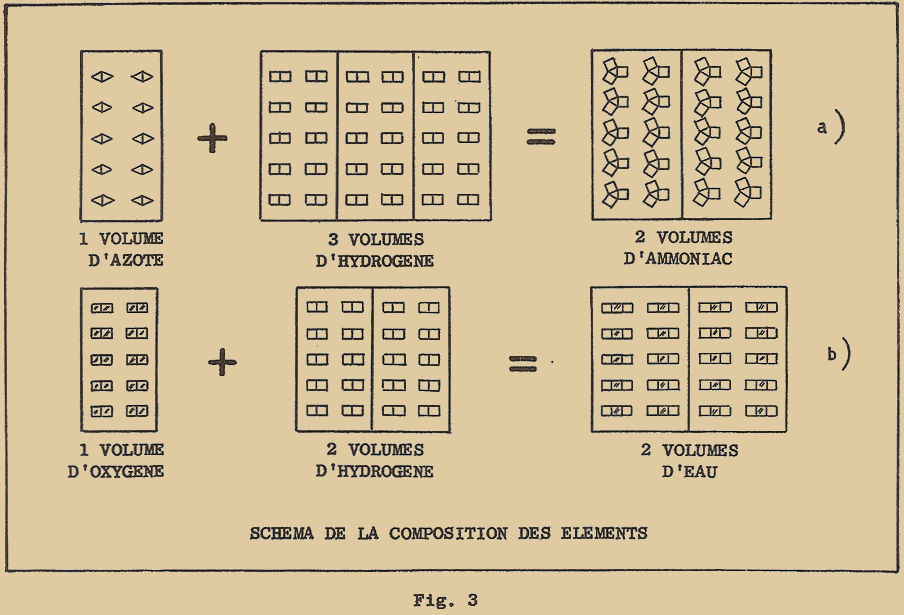

La même année où DALTON publiait sa théorie atomique, un chimiste français GAY-LUSSAC, énonçait une nouvelle loi sur la combinaison chimique des substances gazeuses. En considérant les volumes des gaz (naturellement, les gaz doivent être pris à la même température et à la même pression, sinon on ne peut plus parler de volume) ainsi que leurs poids, comme l’avait fait DALTON, GAY-LUSSAC découvrit que les volumes des gaz simples, qui se combinent pour donner lieu à un gaz composé, sont toujours dans un rapport simple : comme 1 à 1, 1 à 2, ou 1 à 3. Par exemple, dans le cas de l’ammoniac, on trouve que l’on doit combiner 1 volume (par exemple 1 litre) d’azote avec 3 volumes (par exemples 3 litres) d’hydrogène pour trouver 2 volumes (ou 2 litres) d’ammoniac (remarquez que l’ammoniac est un gaz qui, dissous dans de l’eau, donne un liquide appelé couramment ammoniaque). Un autre exemple est celui de l’eau : 1 litre d’oxygène combiné à 2 litres d’hydrogène donne lieu à 2 litres de vapeur d’eau.

Les expériences de GAY-LUSSAC confirment la théorie atomique de la matière : en effet si, dans la composition de l’ammoniac, on part de 1 litre d’azote et de 4 litres d’hydrogène, au lieu de 3, on remarque que l’on obtient encore 2 litres d’ammoniac et 1 litre d’hydrogène, ce qui signifie que le litre d’hydrogène mis en supplément, n’a pas pu se combiner. Ceci indique donc que l’ammoniac n’est pas un simple mélange de 2 gaz pris à peu près dans la proportion de 1 à 3, mais un véritable composé dans lequel les composants sont en proportions parfaitement définies, et ce ne peut être que si l’on admet que les gaz composants sont formés de "particules", et que chaque particule d’un gaz se combine avec un certain nombre de "particules" d’un autre gaz. Nous verrons tout à l’heure, ce que nous entendons par "particule".

Pour expliquer les résultats de GAY-LUSSAC, la théorie de DALTON se révèle insuffisante : en effet, elle ne peut expliquer pourquoi une particule d’une certaine substance ne peut se combiner qu’avec une seule ou avec plusieurs particules d’une autre substance.

Une explication complète a été avancée en 1811 par le chimiste italien AVOGADRO, qui a fait les remarques suivantes : pour une MÊME PRESSION ; et à UNE MÊME TEMPÉRATURE, des volumes égaux d’un gaz quelconque doivent contenir toujours le même nombre de "particules" ; il n’est pas dit que de telles particules sont constituées par un seul atome, elles peuvent aussi être formées de plusieurs atomes.

En supposant alors, que les "particules" d’hydrogène et d’azote sont formées toutes les deux par 2 atomes, la formation de l’ammoniac s’explique facilement comme il est indiqué à la figure 3-a. Supposons que nous prenions 1 volume d’azote qui contient 10 particules ou molécules chacune formée par 2 atomes (représentées sur la figure par des triangles assemblés deux à deux) et 3 volumes d’hydrogène contenant 30 molécules chacune d’elles formées par 2 atomes (représentées sur la figure par des rectangles assemblés deux à deux) : on voit comment pendant la réaction chimique, chaque atome d’azote (triangles) se combine avec 3 atomes d’hydrogène (rectangles) pour former au total 20 molécules d’ammoniac, c’est-à-dire 2 volumes d’ammoniac, comme le montre l’expérience.

En raisonnant de la même manière, on peut représenter (figure 3-b), la réaction chimique entre 1 volume d’oxygène et 2 volumes d’hydrogène : elle donne lieu à 2 volumes d’eau (à l’état de vapeur).

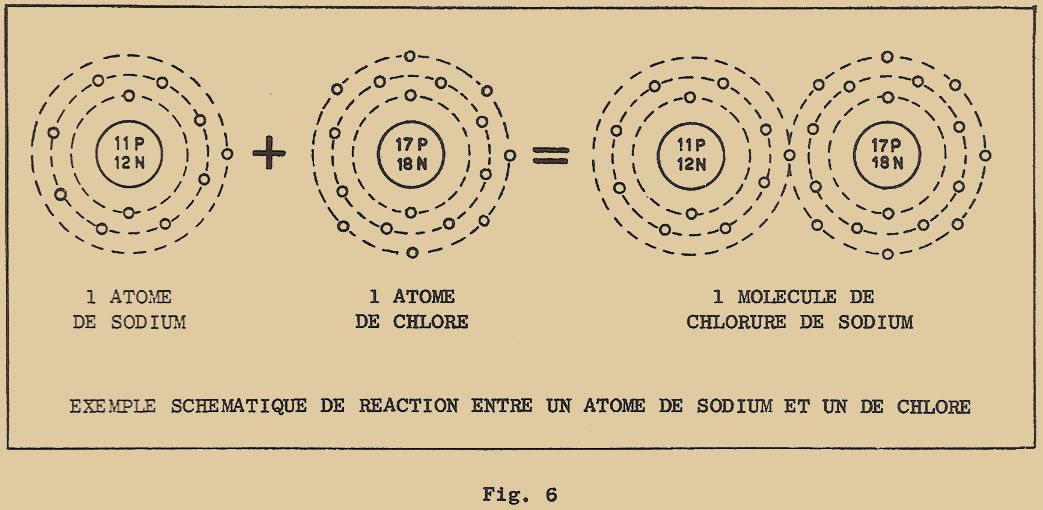

Les hypothèses d’AVAGADRO ne furent pas acceptées aussi facilement, mais les expériences qui suivirent les confirmèrent toujours davantage et ceci même pour les substances non gazeuses. Aujourd’hui la théorie atomique de la matière s’appuie sur des bases solides et les notions des molécules et des atomes sont bien définies. Par MOLÉCULE on entend la plus petite partie d’un corps simple ou composé qui possède encore toutes les propriétés physiques et chimiques de ce corps. Par exemple, partons d’un grain de sel de cuisine (que l’on appelle en chimie chlorure de sodium) et divisons-le en 2 parties égales : nous obtenons 2 grains de sel plus petits, mais qui sont toujours du sel. Répétons l’opération en pensant que nous avons à notre disposition les appareils qui permettent d’effectuer un tel partage, autant de fois que nous le voulons (ceci d’ailleurs n’est pas possible en pratique, car les grains minuscules obtenus deviendraient trop petits). Il arrivera un moment, où il ne sera plus possible de partager le minuscule grain sans lui faire perdre sa propriété : ce minuscule grain représentera la molécule de chlorure de sodium. Si l’on divise une fois encore, on obtiendra un atome de chlore et un atome de sodium, c’est-à-dire les atomes des éléments qui constituent le chlorure de sodium et qui ont, chacun séparément, des propriétés différentes de celles de la substance qu’ils composent.

Si au lieu de considérer un corps composé, c’est-à-dire un composé chimique, on ne considère qu’un corps simple, soit un élément chimique réduit à la molécule, il sera encore possible de diviser cette molécule en 2 ou plusieurs atomes d’un même élément, si la molécule est poly-atomique (ainsi la molécule d’oxygène est divisible en 2 atomes d’oxygène), ou bien elle n’est plus divisible quand elle est monoatomique, car elle est déjà l’atome de cet élément (ainsi, la molécule de cuivre, comme celle d’ailleurs de tous les métaux, est formée d’un seul atome de cuivre).

Les expériences de GAY-LUSSAC ont aussi permis de définir un autre concept des plus importants pour l’étude des combinaisons chimiques : la VALENCE d’un élément. Elle caractérise la faculté d’un élément à se combiner avec d’autres éléments et s’exprime par le nombre d’atomes d’hydrogène qui se combinent, ou peuvent se combiner, avec un atome de la substance considérée. Par exemple, nous avons vu que dans la formation de l’eau, chaque atome d’oxygène se combinait avec 2 atomes d’hydrogène : nous dirons donc que l’oxygène a pour "valence 2" ou ce qui veut dire la même chose, qu’il est "bivalent". Dans le cas de l’ammoniac, chaque atome d’azote se combine avec 3 atomes d’hydrogène, ce qui signifie que l’azote a pour "valence 3", ou bien qu’il est "trivalent". Dans l’acide chlorhydrique on trouve qu’un atome de chlore se combine avec un seul atome d’hydrogène ; on dira donc que la valence du chlore est 1, c’est-à-dire qu’il est "monovalent" ainsi d’ailleurs que l’hydrogène.

Si au contraire on considère le cuivre, qui ne se compose pas avec l’hydrogène, on ne peut définir la valence de la même façon. Par contre, le cuivre se combine avec l’oxygène, pour former l’oxyde de cuivre utilisé dans les redresseurs et dans ce composé on trouve que chaque atome d’oxygène se combine avec 2 atomes de cuivre ; comme l’oxygène est bivalent, ceci signifie que chaque atome de cuivre a une seule valence.

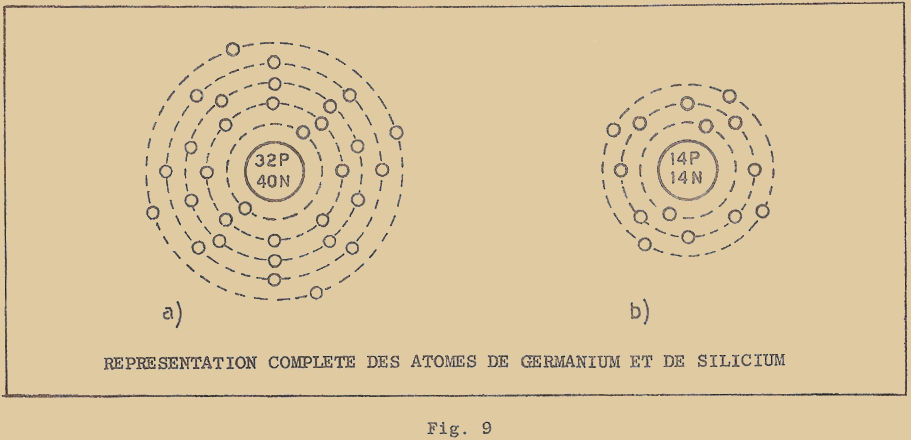

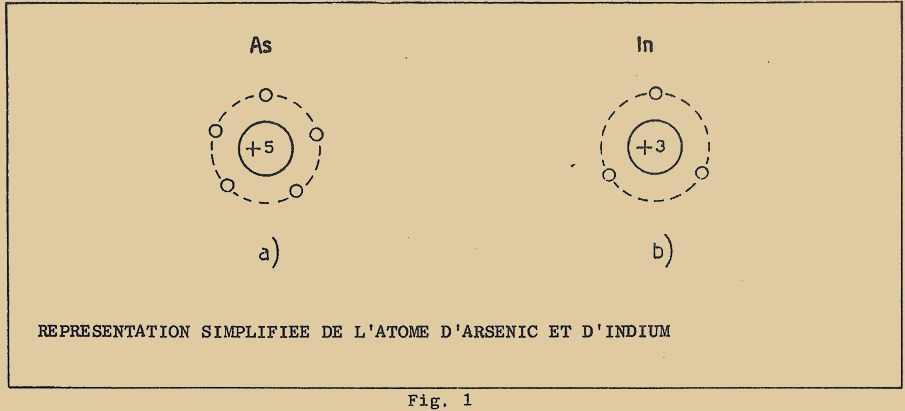

Il existe des éléments qui ont une valence de 4 (tétravalent) comme le germanium et le silicium, et d’autres une valence 5 (pentavalent) comme l’arsenic ; on a rarement des valences supérieures. Il y a par contre 5 gaz (argon, hélium, krypton, néon, xénon) qui ne se combinent à aucun des éléments et que l’on appelle pour cette raison des gaz rares ou "nobles". Ils ont une valence nulle.

L’idée de valence présente un aspect différent à la lumière de la théorie électronique de l’atome ; elle est comme nous le verrons plus loin, de très grande importance pour comprendre les propriétés du germanium et du silicium.

1 – 2 CLASSIFICATION DES ÉLÉMENTS

Les nombreuses expériences poursuivies par les chimistes de l’Europe entière pour vérifier la théorie d’AVOGADRO, permirent de déterminer avec une très grande précision les "masses atomiques" des différents éléments.

"Masse atomique" ne signifie pas le poids en valeur absolue d’un atome, mais le poids relatif, c’est-à-dire de combien de fois l’atome d’un élément pèse plus que l’élément pris comme référence. Il était naturellement logique de prendre comme référence le poids de l’élément le plus léger, c’est-à-dire l’hydrogène, auquel on a donné par convention le poids atomique 1. De cette façon, il a semblé, d’après les premières expériences, que la masse atomique des différents éléments était toujours un nombre entier : ainsi, la masse atomique de l’hélium est 4, celle du carbone 12, celle de l’azote 14, celle de l’oxygène 16, et ainsi de suite ; des mesures plus précises ont permis de vérifier ultérieurement que ceci n’était pas tout à fait exact et que par exemple la masse atomique de l’oxygène était 15,88 et non pas 16.

On préfère actuellement, maintenir la valeur de 16 pour l’oxygène et s’en servir de référence pour les autres masses atomiques. Celles-ci sont alors légèrement différentes et on trouve : 1,008 pour l’hydrogène ; 4,003 pour l’hélium ; 12,01 pour le carbone ; 14,008 pour l’azote, etc…

La masse atomique a pris rapidement une importance très grande, car avec la valence, elle permet de calculer le rapport en poids des différents éléments d’une réaction chimique déterminée ; MASSE ATOMIQUE et VALENCE sont les nombres caractéristiques de chaque élément : ils en définissent les propriétés chimiques.

Au début du siècle, on connaissait 75 éléments, repérés chacun par 2 nombres qui correspondaient respectivement à la MASSE ATOMIQUE et à LA VALENCE. On a cherché ensuite à classer les éléments selon d’autres critères ; ainsi en 1817, l’allemand DOBEREINER chercha à regrouper les éléments 3 par 3, car il avait remarqué l’existence de "triades" d’éléments ayant des propriétés chimiques semblables, comme par exemple : le fer, le cobalt et le nickel ; le lithium, le sodium et le potassium ; le chlore, le brome et l’iode.

D’autres classifications furent faites en 1862 par le français CHAUCOURTOIS et en 1863 par l’anglais NEWLAND, mais celles-ci n’aboutirent à aucune conclusion définitive.

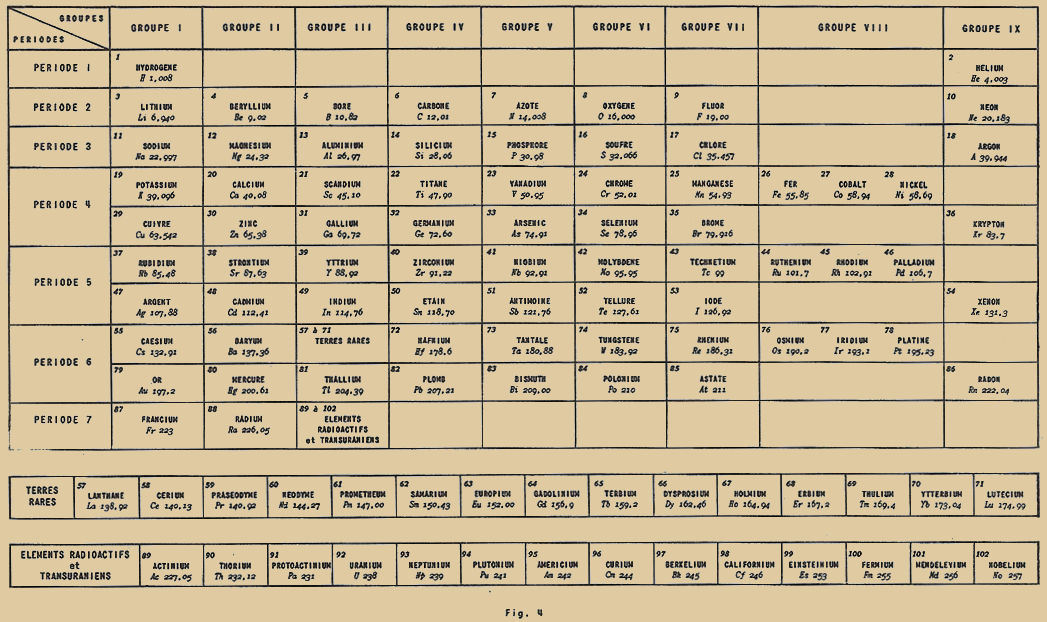

En 1868, le russe MENDELEÏEV fut plus heureux. Il améliora une classification faite par l’allemand MEYER. Les différents éléments furent classés selon un critère très simple, c’est-à-dire selon leur masse atomique, et de cette classification MENDELEÏEV tira des conclusions extrêmement intéressantes. Il remarqua que les principales propriétés des éléments se répétaient dans un certain ordre, à quelques rares exceptions. Ainsi, en plaçant les éléments sur une ligne horizontale selon leur masse atomique, on peut dresser un tableau de 9 colonnes, et dans chacune de celles-ci on place les éléments qui ont des propriétés physiques et chimiques semblables, en particulier ceux qui présentent la même valence. Ainsi fut créée la fameuse CLASSIFICATION PÉRIODIQUE DE MENDELEÏEV. A la figure 4, je vous donne un tableau complet rassemblant tous les éléments connus à ce jour.

Comme vous pouvez le voir, cette table est composée de 7 lignes, chacune d’entr’elles représentant une PÉRIODE, et de 9 colonnes, qui contiennent les groupes des éléments ayant des propriétés analogues. Dans chaque case, figurent un nombre, le nom de l’élément, son symbole (c’est-à-dire le sigle utilisé dans les formules chimiques) et enfin la masse atomique.

En regardant le tableau, on pourrait croire à première vue que le nom donné de "périodique" est impropre, en ce sens que les différentes lignes (ou périodes) ne sont pas égales. La première ligne est la plus simple car elle ne contient que 2 éléments seulement, l’hydrogène (H) et l’hélium (He), respectivement dans la première et dernière colonne. La seconde et la troisième, sont plus complètes, mais encore simples, car elles ne contiennent chacune que 8 éléments.

On remarquera que chaque période commence avec un élément monovalent et se termine par un élément de valence zéro : les éléments intermédiaires ont des valences qui croissent normalement jusqu’à 4 et puis de nouveau décroissent.

Ainsi les éléments de la seconde colonne sont BIVALENTS, ceux de la troisième TRIVALENTS, ceux de la 4ème TETRAVALENTS (valence 4). A partir de là, la valence recommence à diminuer ; ainsi les éléments de la 5ème colonne sont TRIVALENTS, ceux de la 6ème BIVALENTS, ceux de la 7ème MONOVALENTS, ceux de la 8ème, sont des éléments particuliers pouvant avoir une ou deux valences secondaires, et enfin ceux de la dernière colonne, ont pour valence zéro.

Les 4ème, 5ème et 6ème périodes sont plus complexes et peuvent être subdivisées chacune en 2 sous-périodes ; si l’on classe par ordre croissant de masse atomique, avant d’arriver aux éléments de valence zéro, on rencontre 2 séries d’éléments ayant des valences croissant d’abord de 1 à 4, puis décroissant de 4 à 1 ; mais entre ces deux séries d’éléments, on trouve trois éléments, de propriétés très semblables, qui ont été classés dans la 8ème colonne.

Dans la 6ème période, nous remarquons un cas particulier très intéressant : on a été obligé de placer sous la rubrique "Terres rares", une quinzaine d’éléments : ceux-ci en effet sont tellement semblables par leurs propriétés physiques et chimiques qu’il était difficile de les séparer. Ceci a donc justifié de les classer comme un seul élément, bien qu’en réalité chacun d’eux ait une masse atomique différente, comme on peut le constater en bas du tableau.

La dernière période comprend les éléments les plus lourds, parmi lesquels l’URANIUM et les éléments TRANSURANIENS découvert récemment.

Il faut encore remarquer que l’ordre croissant des éléments ne dépend pas rigoureusement de la masse atomique : il suffit d’observer le tableau pour voir qu’il n’y a pas continuité entre les éléments 18 et 19 (argon et potassium), 27 et 28 (cobalt et nickel), 52 et 53 (Tellure et l’Iode).

La composition de ce tableau par MENDELEÏEV ne fut pas aussi simple qu’elle peut apparaître maintenant, on doit de souvenir qu’à cette époque de très nombreux éléments étaient encore inconnus et le tableau se trouvait alors être incomplet.

L’habileté de Mendeleïev, fut de disposer les différents éléments connus de façon à ne pas interrompre la périodicité du tableau : de nombreuses cases furent laissées libres. On pouvait ainsi non seulement prévoir l’existence d’autres éléments qui restaient à découvrir, mais aussi prévoir leur caractéristiques (si l’on se basait sur l’existence d’une périodicité) de même que leur valence, leur masse atomique avec une certaine approximation, et leur propriétés chimiques.

Les éléments dont Mendeleïev avait prévu l’existence sont ceux des cases 21, 31 et 32 qui furent découverts (ou mieux : retrouvé et isolés des minéraux qui les contenaient), quelques années après. On leur donna le nom de la nation qui les découvrait : ainsi à l’élément 21 découvert par le chimiste suédois NILSON, on donna le nom de SCANDIUM (de Scandinavie) : à l’élément 31, découvert par le chimiste français LECOQ de BOISBAUDRAN, on donna le nom de GALLIUM (de la Gaule ancien nom de la France) et enfin à l’élément 32, découvert par l’allemand WINKLER, on donna le nom de GERMANIUM.

Au fur et à mesure que le tableau périodique se complétait de nouveaux éléments, la connaissance de la matière se précisait. De plus, on étudiait la matière en ses composants les plus petits et chaque particule était soigneusement classée selon ses caractéristiques puis affectée d’un numéro d’ordre. On peut donc dire que tous les "édifices" de la nature (c’est-à-dire tous les corps composés), peuvent être créés à l’aide d’un nombre limité de "briques" (les éléments) se composant entr’eux selon un ordre déterminé.

1 – 3 CONSTITUTION DE L’ATOME

Après la découverte des rayons X, des électrons et de la radioactivité, on se trouvait en présence de phénomènes qui ne pouvaient être expliqués à l’aide de la théorie atomique de la matière : de tels phénomènes ne pouvaient être expliqués que si l’on admettait l’existence de charges électriques, négatives et positives que ne prévoyait pas la théorie atomique. L’hypothèse suivant laquelle l’atome était la plus petite partie de la matière et ne pouvait plus être divisé, n’était plus valable.

En 1911, l’anglais Lord RUTHERFORD proposa le premier modèle composé d’un noyau formé d’un nombre de charges positives égale au numéro d’ordre de l’élément considéré : ces charges positives furent appelés PROTONS. Puisque l’atome à l’état naturel est électriquement neutre (ce qui signifie que chaque charge positive doit être compensée par une charge négative équivalente), RUTHERFORD compléta son modèle d’atome, en disposant tout autour, autant d’électrons qu’il y avait de protons dans le noyau.

L’expérience montra encore que les électrons étaient extrêmement légers, et que leur poids était une très faible part de celui de l’atome ; de ces considérations, on déduisit que le poids d’un atome dépendait presque exclusivement de celui de son noyau (c’est-à-dire des protons) : aujourd’hui, on sait qu’un proton pèse 1840 fois plus qu’un électron.

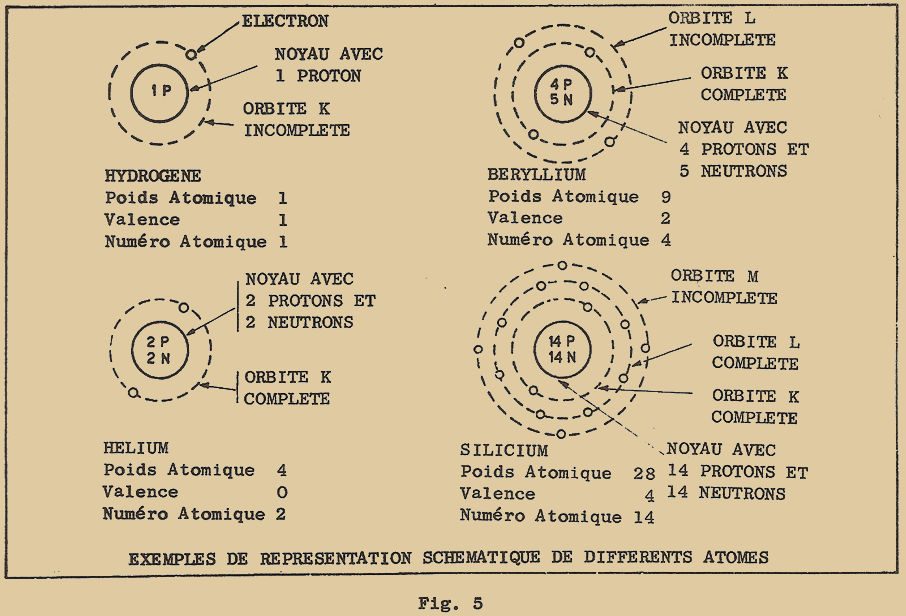

Nous pouvons maintenant essayer de représenter les différents types d’atomes. En commençant par l’hydrogène, qui est le premier dans la classification de MENDELEÏEV, nous dirons que son noyau est composé d’une seule charge positive (un seul proton) ; il n’y aura par conséquent qu’un seul électron autour de son noyau. Si nous passons au second élément, l’hélium, son noyau doit être composé de 2 protons et de 2 électrons : mais c’est là qu’apparut la première difficulté.

En effet, la masse atomique de l’hélium devrait être exactement double de celle de l’hydrogène, puisqu’il est formé de 2 protons et de 2 électrons. Or l’expérience était formelle et indiquait que l’hélium pesait 4 fois plus que l’hydrogène. Pour tourner la difficulté, on devait alors supposer que le noyau de l’hélium était composé de 4 protons, mais comme il devait avoir une charge positive égale à 2, deux des 4 protons devaient être intimement liés chacun à un électron, ce qui le rendait alors neutre.

Ce n’est qu’en 1932, que le physicien anglais JAMES CHANDWICK découvrit que le couple proton-électron, imaginé par RUTHERFORD n’était en réalité qu’une seule et unique particule, de poids égal à celui d’un électron et d’un proton, mais privée de charges électriques, c’est-à-dire qu’il était électriquement neutre ; c’est pour cette raison, qu’il lui donna le nom de NEUTRON.

Le modèle de l’atome fut encore modifié quelques années après, par le physicien danois NIELS BOHR. Se basant sur les résultats de longues et patientes recherches effectuées par l’anglais Henry MOSELEY – expériences qui consistaient à examiner un nombre considérable de métaux à l’aide des rayons X -, et se basant aussi sur les conclusions que les électrons ne devraient pas seulement tourner autour du noyau mais se déplacer sur des orbites bien déterminées, il proposa un modèle d’atome, très semblable à celui d’un système solaire miniature, où le soleil serait le noyau autour duquel tournaient les planètes (électrons).

Selon Bohr, il y avait seulement 7 orbites possibles, correspondant chacune à une des périodes de la table de Mendeleïev, et disposées à des distances croissantes du noyau. Ainsi les éléments de la première ligne (H et He, c’est-à-dire l’hydrogène et l’hélium) ont respectivement 1 et 2 électrons disposés sur la première orbite la plus voisine du noyau et repéré par la lettre K, cette orbite se trouve complète avec 2 électrons seulement.

Tous les éléments de la seconde ligne (du Li au Ne) ont deux électrons sur l’orbite K et les électrons restants (de 1 à 8) se trouvent sur une seconde orbite, appelée L et qui se trouve complétée avec 8 électrons au maximum. Le même phénomène est valable pour la 3ème ligne. Celle-ci possède les orbites K et L complètes et une 3ème orbite plus éloignée du noyau que les précédentes, appelée M ; qui n’a qu’un électron pour le premier élément (Na = sodium) et se trouve complétée à 8 électrons avec le dernier élément de la même ligne (Ar = Argon)

Pour les éléments des 3 groupes suivants, on ajoute 3 nouvelles orbites respectivement N, O et P ; celles-ci à leur tour sont divisées en 2 "sous-orbites" correspondant aux 2 lignes qui subdivisent ce groupe. Une 7ème orbite Q intervient enfin pour les éléments du dernier groupe.

Bien que la théorie moderne ait un peu modifié la distribution des électrons sur les différentes orbites, le principe reste celui indiqué par BOHR. Je vous ai représenté à la figure 5 quelques exemples d’une telle représentation. On peut en tirer d’importantes conclusions qui permettent de voir d’une manière différente la signification de la notion de valence des éléments et d’expliquer l’aptitude des électrons à quitter plus ou moins facilement l’atome pour se combiner à d’autres éléments.

On peut remarquer encore que tous les atomes de la première colonne du tableau, qui sont monovalents comme nous l’avons vu, n’ont qu’un seul électron sur leur orbite la plus externe. Les atomes de la seconde colonne sont bivalents et possèdent au contraire deux électrons sur la même orbite externe : ceux de la troisième colonne sont trivalents et en comportent 3 ; ceux de la quatrième, 4. Les atomes de la dernière colonne ont une orbite externe complète avec 8 électrons (à l’exception de l’hélium dont l’orbite K est déjà complète avec 2 électrons) et ont une valence zéro ; ceux de la ème colonne sont monovalents et possèdent 7 électrons, c’est-à-dire qu’il leur manque un électron ; ceux de la 6ème n’en comporte que 6, c’est-à-dire qu’il leur en manque 2 pour compléter l’orbite et ils sont bivalents ; enfin ceux de la 5ème colonne, ont 5 électrons (il leur manque donc 3 électrons pour compléter l’orbite externe) et ils sont donc trivalents.

La relation entre la valence d’un atome et le nombre d’électrons sur l’orbite externe est donc très simple : pour les atomes des 4 premières colonnes la valence est donnée directement par le nombre des électrons périphériques, tandis que pour les atomes des 4 colonnes suivantes (on exclut toujours la 8ème colonne où l’on trouve des triades car, pour comprendre leur cas, il faut recourir à une subdivision ultérieure de leurs orbites, ce qui est assez complexe), la valence est donnée par le nombre d’électrons périphériques qui manquent pour compléter l’orbite, c’est-à-dire pour atteindre 8 (exception faite pour l’hélium dont l’orbite est complète avec 2 électrons et qui se comporte comme les autres éléments qui possèdent 8 électrons).

Ceci étant supposé admis, on comprend que lorsque l’orbite externe n’est pas complète, il y a instabilité, car l’atome tend à perdre des électrons de cette orbite quand leur nombre est inférieur à 4, ou bien à capturer des électrons, pour la compléter quand il en possède plus de 4.

On s’explique aussi pourquoi les atomes de la dernière colonne ont une valence nulle : leur orbite externe est complète, c’est-à-dire très stable, et ainsi, ils ne tendent ni à perdre, ni à capturer des électrons. Les atomes de la première colonne et ceux de la 7ème ont au contraire une tendance très prononcée à se combiner chimiquement pour donner lieu à des corps composés, car les premiers ont tendance à perdre un électron, tandis que les seconds tendent à en capturer un. Ainsi par exemple, le sodium et le chlore réagissent avec rapidité pour donner le chlorure de sodium (sel de cuisine) comme vous pouvez le voir de façon schématique à la figure 6.

L’atome de sodium perd un électron et se trouve stable puisque l’orbite interne est complète ; l’atome de chlorure capture avidement l’électron perdu par le sodium et, complétant ainsi son orbite externe, devient ainsi à son tour très stable.

On explique de la même façon, les réactions chimiques entre les éléments bivalents de la seconde et 6ème colonne, ou les tétravalents de la 3ème et 5ème colonnes. Des combinaisons chimiques peuvent avoir lieu entre des atomes qui n’ont pas la même valence et dans ce cas plus de 2 atomes interviennent dans les réactions.

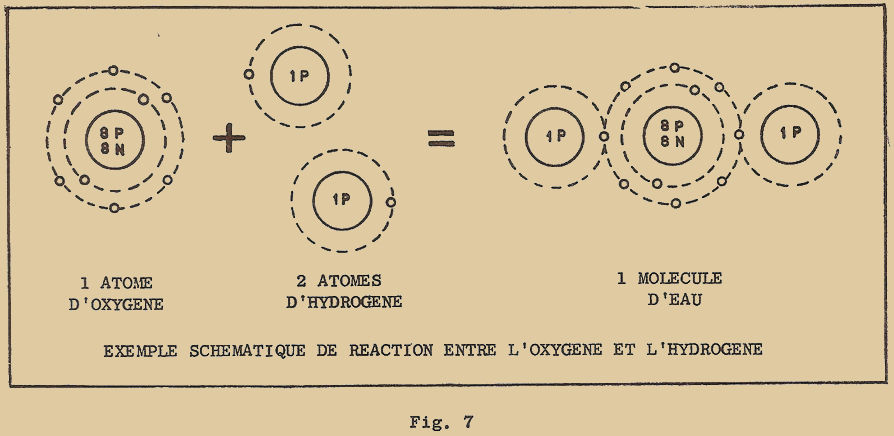

Prenons le cas par exemple de l’oxygène qui est bivalent et de l’hydrogène qui est monovalent. L’oxygène pour compléter son orbite externe a besoin de 2 électrons qui peuvent lui être fournis par 2 atomes d’hydrogène : ainsi la molécule d’eau qui en résulte est formée d’un atome d’oxygène et de 2 atomes d’hydrogène (figure 7).

Les éléments de la 5ème colonne peuvent, ou bien perdre leurs 5 électrons périphériques, ou bien en capter 3 pour compléter leur orbite. Ils peuvent donc se comporter comme pentavalents (valence 5), ou bien comme trivalents. C’est le cas par exemple, du pentachlorure d’Arsenic, dans lequel un atome d’Arsenic a perdu ses 5 électrons en complétant les orbites d’autant d’atomes du chlore, chacun d’eux ne nécessitant qu’un seul électron.

Les électrons externes des atomes sont donc ceux qui en déterminent les propriétés chimiques, et pour cette raison portent le nom d’ÉLECTRONS DE VALENCE ; l’importance de ces électrons est donc fondamentale pour expliquer les caractéristiques des différents éléments et de leurs composés, et en particulier les semi-conducteurs utilisés dans la fabrication des transistors.

Avec la théorie électronique de la matière, le numéro d’ordre des différents éléments prit une importance beaucoup plus grande que la masse atomique considérée jusqu’alors : il fut considéré alors comme indice de la propriété de chaque élément et on l’appela NOMBRE ATOMIQUE.

Comme nous l’avons déjà vu, celui-ci indique non seulement la position exacte de l’élément dans la table de Mendeleïev, mais donne aussi directement le nombre de charges électriques positives du noyau, et par conséquent le nombre d’électrons qui tournent autour de celui-ci. Des considérations faites jusqu’à maintenant sur la masse atomique il en résulte que la DIFFÉRENCE entre le nombre (arrondi en général) représentant la masse atomique et le nombre atomique donne le NOMBRE de Neutrons qui complètent le noyau d’un atome donné.

Si nous représentons par Z le nombre atomique et par P la masse (ou le poids) atomique d’un certain élément, nous dirons que le noyau est composé de Z protons et de P – Z neutrons et qu’il y a Z électrons qui tournent autour du noyau. Ainsi pour l’oxygène, nous avons Z = 8 ; P = 16. Son noyau est donc composé de 8 protons et de 16 – 8 = 8 neutrons, et il y a 8 électrons qui tournent autour du noyau.

De ces calculs simples, on en déduit le nombre de protons et de neutrons qui sont indiqués par les lettres P et N et qui se trouvent à l’intérieur des cercles représentant les noyaux des atomes de la figure 5.

1 – 4 Isotopes

Si effectivement les atomes étaient tous formé de protons, d’électrons et de neutrons et si le neutron avait un poids égal à celui de l’atome d’hydrogène (en fait, le poids d’un neutron serait égal à celui d’un électron plus un proton puisque l’atome d’hydrogène est composé d’un électron et d’un proton), on devrait en déduire que le poids d’un atome quelconque devrait être un multiple parfait du poids de l’atome de l’hydrogène. En réalité, il suffit de jeter un coup d’œil sur la table de Mendeleïev pour voir que ce n’est pas exact : en effet, puisque la masse atomique de l’hydrogène est voisine de 1, la masse des autres éléments devrait être très voisins d’un nombre entier. C’est ce qui arrive pour certains éléments, comme He (4,0003), N (14,008), O (16,000), F (19,000), Mo (95,95) etc…mais ce n’est pas vrai pour tous. Si vous prenez par exemple le chlore (Cl) : sa masse atomique est 35,457 ce qui est bien loin de 35 ou de 36.

L’explication de ces irrégularités, fut donnée en 1912 par l’anglais SODDY, qui découvrit qu’un élément donné était formé d’un mélange de 2 "sous-produits" ayant tous des propriétés identiques, mais dont les poids pouvaient différer légèrement d’un type à l’autre : à ces "sous-produits" (ou sous éléments) on donna le nom d’ISOTOPES qui en grec, signifie "même lieu" : en effet, ayant des propriétés chimiques identiques, ils occupent la même place dans le tableau de Mendeleïev.

Un appareil extrêmement précis, mis au point quelques années après et appelé SPECTROGRAPHE DE MASSE, permit de contrôler un à un, tous les éléments connus et de déterminer que la grande majorité d’entr’eux était constitué par un mélanges d’isotopes en plus ou moins grand nombre (de deux à plus d’une dizaine).

Les isotopes d’un élément déterminé diffèrent uniquement par leur masse (poids) c’est-à-dire par le nombre de neutrons qui composent leur noyau ; ainsi si nous revenons maintenant à notre précédent exemple du chlore, nous apprenons qu’il est formé par un mélange de 2 isotopes de masse 35 et 37 et dans la proportion respective de 76% et 24% : avec une telle proportion, il en résulte un poids moyen de 35,457 comme on peut le déterminer par voie expérimentale. Les poids des isotopes sont par contre des multiples parfaits de celui de l’hydrogène, mais ne peuvent être trouvés par les déterminations normales des masses atomiques et ceci uniquement parce que la détermination est pratiquée sur un nombre considérable d’atomes et non pas sur un seul ; partant de ceci, la valeur que l’on trouve est obligatoirement une valeur moyenne des poids des différents isotopes qui constituent l’élément étudié.

1 – 5 ORDRES DE GRANDEUR

Maintenant que je vous ai expliqué la constitution de l’atome, il est bon pour fixer les idées, que je vous donne quelques ordres de grandeur sur les dimensions et les charges de ces particules microscopiques. Je vous soulignerai tout de suite que ces valeurs ne peuvent être mesurées directement (en effet, il n’est pas possible d’isoler un atome, de l’agrandir, de voir et de mesurer ses dimensions). On utilise à cette fin une méthode indirecte de calcul en partant des résultats d’expérience.

Les dimensions de l’atome (par exemple celui de l’hydrogène qui est le plus simple de tous) sont de l’ordre de grandeur du dix-millième de micron (le micron dont le symbole est µ, est égal à un millième de millimètre), c’est-à-dire qu’elles sont extrêmement petites ; en d’autres termes, nous pouvons dire qu’il faudrait mettre 10 millions d’atomes d’hydrogène à la queue leu-leu pour faire 1 mm.

Les dimensions de l’électron sont encore beaucoup plus petites : son diamètre est de l’ordre de 5 millièmes de millionième de micron : cela veut dire qu’il faudrait mettre 200.000 millions d’électrons pour faire 1 mm.

L’atome d’hydrogène a des dimensions de l’ordre de 20.000 fois plus grandes que celle d’un électron : ceci signifie que l’unique électron de l’atome d’hydrogène tourne à une grande distance (par rapport à sa dimension) du noyau. Si nous voulions réaliser une maquette d’un tel atome, il faudrait prendre une sphère de 1 mm de diamètre pour représenter l’électron et l’éloigner de 500 m du noyau.

Quant au poids (ou mieux la masse), comme je vous l’ai déjà dit, l’électron pèse environ 1840 fois MOINS que le proton, tandis que le neutron a pratiquement le même poids que ce dernier. Pour obtenir seulement un micro-gramme (c’est à dire 1 millionième de gramme) il faudrait 600.000 millions de protons (ou de neutrons). Pour obtenir un poids égal d’électrons, il en faudrait 1.840 fois plus. On peut. On peut se faire une idée du poids d’un atome, en considérant le "nombre d’Avogadro". Si nous prenons un nombre d’atomes (d’un élément donné) égal au nombre d’Avogadro, nous obtiendrons le poids en grammes de cet élément égal à sa masse atomique. Ceci signifie que 602.500 millions de millions de millions d’atomes d’oxygène par exemple auront un poids de 16 grammes (16 est en effet la masse atomique de l’oxygène) ; un même nombre d’atomes de cuivre pèsera 63,542 grammes ; le même nombre d’atomes de germanium pèsera 72,60 grammes, le même nombre d’atomes de plomb 207,21 grammes, etc…

Nous avons dit à plusieurs reprises que l’électron possédait une charge négative, dite "charge élémentaire", que le proton possédait une charge égale mais positive et que le neutron était par contre neutre ; pour avoir recours à 2 exemples.

Prenons un condensateur de 10pF et chargeons-le sous une tension continue de 100 V ; la charge accumulée sur son armature négative équivaut à 6.250 millions d’électrons.

Considérons maintenant un fil parcouru par un courant de 1µA (c’est-à-dire 1 millième de mA) ; si nous pouvions compter le nombre d’électrons qui traversent une section du conducteur, nous trouverions 6 millions de millions en une seconde.

Je vous donne ci-dessous, un tableau résumant ce que nous venons de voir :

diamètre de l’électron 5 x 10-12 mm

diamètre de l’orbite de l’hydrogène 1,06 x 10-7 mm

masse de l’électron 9,1 x 10-28 g

masse d’un proton 1,6722 x 10-24 g

masse d’un neutron 1,6747 x 10-24 g

nombre d’Avogadro 6,025 x 1023

charge de l’électron 1,6 x 10-19 coulomb

EXERCICES DE RÉVISION SUR LA PREMIÈRE LEÇON THÉORIQUE DE TRANSISTOR

Les réponses à ces exercices ne devront pas être envoyées à EURELEC. Je vous conseille de les consigner soigneusement dans un cahier. Vous en vérifierez l’exactitude lors de la prochaine leçon, au terme de laquelle vous trouverez les réponses exactes.

1 – Qu’appelle-t-on molécule ?

2 – Qu’appelle-t-on atome ?

3 – Par quoi exprime-t-on la valence d’un élément ?

4 – Que représente la masse atomique ?

5 – De combien de particules l’atome est-il formé et quelles en sont les propriétés ?

6 – Comment schématiquement peut-on représenter un atome ?

7 – De combien d’électrons, de protons et de neutrons est formé l’atome d’un élément, dont le numéro atomique est 17 et la masse atomique 35 ?

8 – Qu’appelle-t-on "électron de valence" et pourquoi ?

9 – Par quoi peut-on différencier les nombreux isotopes d’un élément ?

Fin de la leçon 1

LECON 2

1 – ÉTATS DE LA MATIÈRE

La matière se présente sous trois états différents, qui dépendent uniquement de ses conditions physiques ; nous distinguerons : l’état SOLIDE, l’état LIQUIDE, l’état GAZEUX.

Dans des conditions normales de température et de pression, la matière peut se présenter comme un SOLIDE, un LIQUIDE ou un GAZ.

1 – 1 SOLIDES, LIQUIDES, GAZ

La définition des trois états est très simple : on dit qu’un corps est solide lorsqu’il présente une forme et un volume bien définis, comme par exemple un morceau de fer, une pierre, etc… ; on appellera liquide un corps qui aura un volume bien défini, mais une forme indéterminée, comme par exemple un litre d’eau ; ainsi, le volume occupé sera toujours un litre (bien défini), mais sa forme sera celle du récipient qui le contient ; on dira enfin d’un corps qu’il est gazeux lorsque ni son volume, ni sa forme ne sont définis, de telle sorte qu’il pourra prendre la forme du récipient qui le contient, et que son volume pourra être comprimé ou dilaté à volonté.

Toutes les substances peuvent être amenées à ces trois états : il suffit de les porter à la température voulue (les chauffer ou les refroidir). Prenons par exemple l’eau qui est le composé chimique le plus répandu dans la nature. A la température normale, l’eau est liquide, mais dans les régions froides (ou si l’on vient à la réfrigérer suffisamment), elle passe à l’état solide et devient de la glace ; si nous la chauffons au contraire, elle passera à l’état gazeux (vapeur d’eau) au moment de l’ébullition.

Tout ce que nous venons de voir en ce qui concerne l’eau, reste valable pour les autres éléments ou composés chimiques. Si nous prenons du cuivre, nous pensons d’instinct à un solide parce qu’à la température ambiante il se trouve à l’état solide. Mais si nous le portons à une température supérieure à 1.080 degrés, le cuivre passera à l’état liquide, et à la température de 2.310 degrés, il passera à l’état gazeux. Si nous prenons maintenant l’oxygène nous pensons tout de suite à un gaz, mais il peut être condensé à l’état liquide si on le porte à 183 degrés en dessous de zéro et deviendra solide à une température inférieure à 218 degrés en dessous de zéro.

La température à laquelle un corps passe de l’état solide à l’état liquide, et celle où il passe de l’état liquide à l’état gazeux (ébullition) est parfaitement déterminée et dépend uniquement de la substance considérée ; ces valeurs de température sont donc caractéristiques pour chaque substance et sont appelées respectivement Température de Fusion et Température d’ébullition.

Pour savoir comment se comporte une substance déterminée lorsqu’elle passe d’un état à l’autre, on prend comme base de référence l’EAU.

Prenons de la glace à une certaine température (10° C par exemple en dessous de zéro : c’est à peu près la température de la glace d’un frigidaire) et mettons-la dans un récipient où il y a un thermomètre : celui-ci indiquera donc la température de la glace.

Chauffons lentement le récipient et notons la température à intervalles réguliers, par exemple toutes les 5 minutes : nous allons voir la température monter régulièrement jusqu’à ce que la glace commence à fondre ; à ce moment le thermomètre ne montera plus et indiquera une température constante jusqu’à ce toute la glace soit passée à l’état liquide. Ceci signifie donc que pendant ce passage de l’état solide à l’état liquide, toute l’énergie (c’est-à-dire la chaleur) fournie à la glace sert à faire fondre, c’est-à-dire à en transformer la structure interne comme nous allons le voir sous peu.

Juste à l’instant où toute la glace a fini de fondre, (ou mieux, dès que l’eau à l’état solide est passée à l’état liquide), le thermomètre recommence à monter et continue à monter jusqu’à ce que la température ait atteint la température d’ébullition.

A ce moment, de nouveau le thermomètre indiquera une température constante et toute l’énergie thermique fournie au liquide sert à en changer la structure interne : le liquide s’évapore et passe à l’état gazeux : c’est-à-dire que l’eau devient de la vapeur.

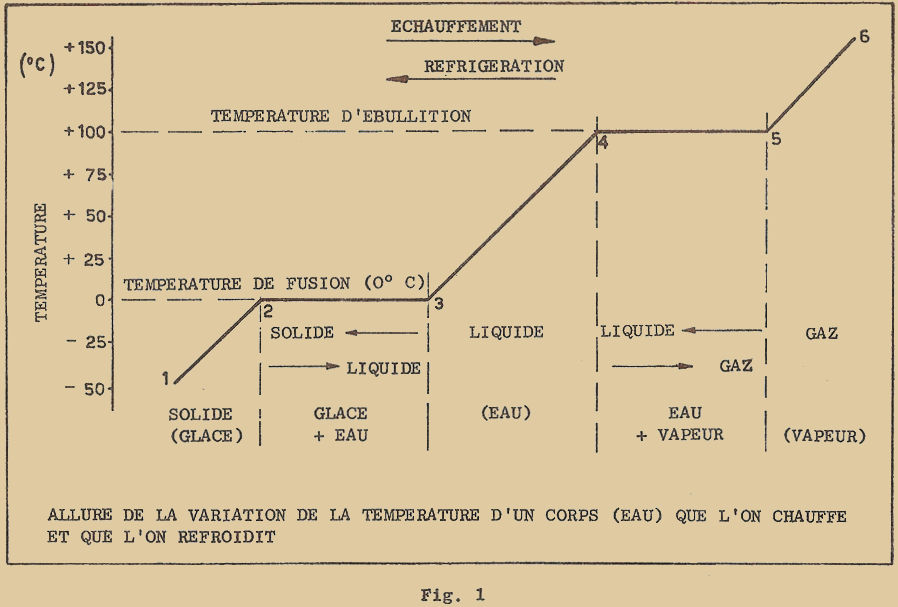

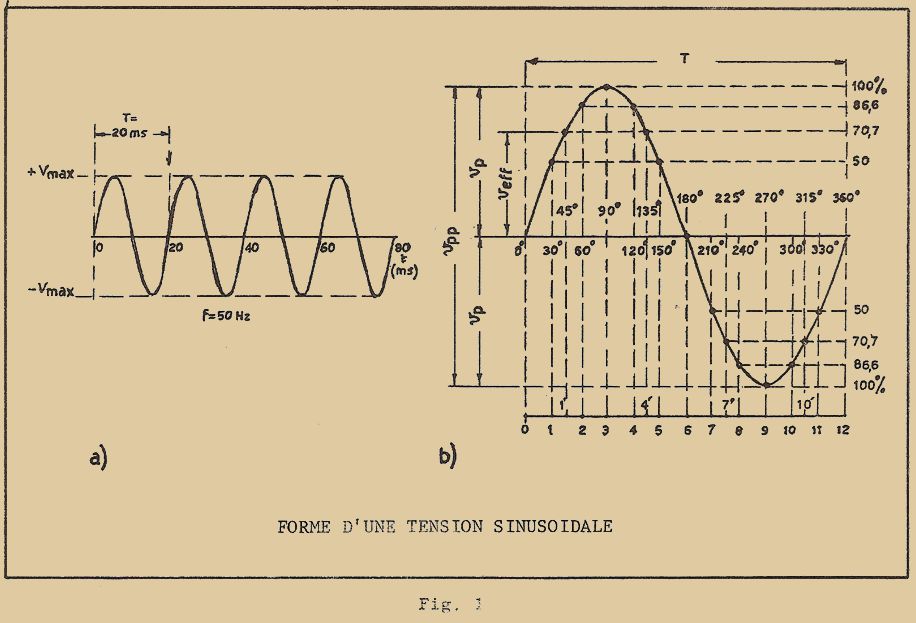

Si nous voulons représenter ce phénomène sur un graphique, nous obtenons la courbe (ligne brisée) de la figure 1 : pendant toute la période 1 – 2 le corps considéré est dans son ensemble à l’état solide et sa température va en augmentant ; pendant la période 2 – 3, il a atteint sa température de fusion et se transforme en liquide ; dans la période 3 – 4 tout le corps est à l’état liquide et sa température recommence à augmenter jusqu’à l’ébullition ; pendant la période 4 – 5 le liquide se transforme en gaz et sa température reste constante enfin, dans la période 5 – 6 le corps en entier est à l’état gazeux et la température recommence à augmenter.

La courbe de la figure 1 peut être naturellement parcourue en sens inverse lorsque l’on part d’un gaz et qu’on le refroidit. Dans ce cas, on passera d’abord de l’état gazeux à l’état liquide, puis du liquide à l’état solide. Le passage d’un état à un autre verra encore la température rester constante et ce au moment de l’ébullition et de la fusion.

Les températures de fusion et d’ébullition sont comme nous l’avons déjà vu, des caractéristiques de chacune des substances et ne dépendent uniquement que de la pression à laquelle est soumise la substance considérée. Toutefois si la première (fusion) dépend très peu de la pression, la seconde (ébullition) en dépend beaucoup. Vous savez certainement qu’au sommet d’une montagne où l’air est raréfié (pression atmosphérique plus faible) l’eau bout à une température plus basse qu’au niveau de la mer où la pression atmosphérique est la plus élevée.

Il est bon de noter que les températures de fusion et d’ébullition de l’eau distillée au niveau de la mer, c’est-à-dire à la pression de l’atmosphère (qui équivaut à 1kg/cm2) sont prises comme références pour la détermination de l’échelle de température, appelée échelle CELSIUS. Le fait que l’eau gèle à 0° et bout à 100° n’est qu’une simple convention. On a pris l’habitude d’indiquer par un signe (+) positif, les températures supérieures à zéro degré et par un signe (-) négatif celles qui sont inférieures à celle valeur ; on écrira donc, par exemple + 25° C (° indiquant les degrés et "C" l’initiale de CELCIUS) pour indiquer une température de 25 degrés au-dessus de zéro ; on écrira de même – 7° C pour indiquer 7 degrés en dessous de zéro.

1 – 2 FORCES INTER-ATOMIQUES ET INTER-MOLÉCULAIRES – LIAISONS CHIMIQUES

Dans la précédente leçon, vous avez étudié comment les diverses substances étaient constituées par des molécules elles-mêmes formées d’un ou plusieurs atomes d’un même élément ou d’éléments composés ; les atomes, à leur tour sont formés d’un certain nombre de charges positives (protons) et d’un nombre égal de charges négatives (électrons). On peut alors presque comprendre de façon intuitive, que les forces qui lient les électrons au noyau sont de caractère électrostatique, en ce sens que les charges de signes opposés s’attirent (loi de Coulomb).

Sont encore d’origine électrostatique les forces qui lient entr’eux les atomes formant la molécule et celles qui lient ensemble les molécules des différentes substances. Ces forces ont un rayon d’action extrêmement faible, se faisant sentir à des distances très petites, de l’ordre de grandeur des atomes (de l’ordre de 1 millionième de centimètre).

En diminuant une telle distance l’intensité d’attraction augmente notablement jusqu’à atteindre une valeur maximum ; si l’on diminue encore cette distance, les forces d’attraction deviennent répulsives, ce qui signifie que deux atomes ne peuvent être rapprochés indéfiniment.

Dans le cas d’un gaz ou d’un mélange de gaz (comme c’est le cas pour l’air) dans les conditions normales, les molécules se trouvent à des distances considérables les unes des autres (par rapport à leurs dimensions évidemment) et les forces inter-moléculaires sont pratiquement nulles ; aucune liaison n’existe donc entre différentes molécules gazeuses et elles peuvent se déplacer librement. En réalité les molécules se déplacent de façon complètement désordonnée et chacune des molécules, en en rencontrant une autre, doit continuellement changer sa direction de parcours.

Les déplacements sont très petits et d’autant plus rapides que la température du gaz est plus élevée ; c’est pour cette raison que la pression d’un gaz enfermé dans un récipient augmente quand on le chauffe (par exemple, la pression des pneus de voiture augmente par échauffement quand on roule longtemps.

On peut se faire une idée sur le mouvement des molécules d’un gaz en observant une fourmilière lorsqu’ un grand nombre de fourmis se jettent sur une proie. Si l’on regarde la fourmilière à une certaine distance, on ne voit qu’une masse noire compacte, constituée par l’ensemble de toutes les fourmis. Mais si l’on se rapproche de façon à pouvoir distinguer chaque fourmi, on remarque que celles-ci se déplacent (semble-t-il) de façon désordonnée en se bousculant continuellement.

Dans le cas des liquides, les molécules sont beaucoup plus rapprochées les unes des autres et les forces inter-moléculaires ne sont plus négligeables. Dans les conditions normales, les molécules se trouvent à la distance exacte pour laquelle les forces inter-moléculaires ne sont ni attractives, ni répulsives. Mais si l’on essaie de les rapprocher un peu en comprimant le liquide, d’intenses forces répulsives apparaissent et empêchent toute compression. Les liquides sont en fait incompressibles.

Les forces d’attraction qui se manifestent quand on éloigne les molécules les unes des autres sont au contraire beaucoup moins intenses : c’est pour cette raison qu’elles ont encore un degré de liberté de mouvement appréciable, bien que plus limité que dans le cas des gaz.

Ainsi comme dans le cas précédent les molécules sont en mouvement désordonné continuel, d’autant plus rapide que la température est plus élevée, mais l’ensemble des mouvements est plus limité car les molécules sont plus rapprochées. L’augmentation de la température, en donnant une plus grande mobilité aux molécules, provoque aussi une plus grande fluidité du liquide (ce que l’on remarque en particulier dans les liquides denses) et une augmentation de son volume.

Si nous passons maintenant aux solides, nous trouvons des forces inter-moléculaires extrêmement puissantes, qui sont capables de bloquer complètement les molécules : aucun mouvement désordonné n’est plus possible, mais seulement une vibration plus ou moins intense autour du point de repos selon la température.

De cette façon, la position des molécules est rigidement fixée et le corps présente un aspect compact et indéformable.

Les forces inter-moléculaires et inter-atomiques peuvent être du type purement électrostatique comme je vous l’ai déjà signalé, quand la substance considérée est formée d’atomes électriquement polarisés. Le cas typique est celui du chlorure de sodium considéré dans la précédente leçon. Les atomes de sodium en se combinant aux atomes du chlore ont cédé à ces derniers un électron (de valence) et sont ainsi devenus électriquement positifs. Les atomes de chlore sont donc devenus négatifs ayant capté un électron : il devient évident qu’entre les deux types d’atomes nait une force d’attraction du type électrostatique. C’est ce type de liaison que l’on rencontre dans le chlorure de sodium et dans toutes les autres substances qui se comportent de même, c’est-à-dire dans lesquelles apparaissent des IONS. On appelle ION, un atome qui a perdu ou capté un ou plusieurs électrons et qui de ce fait n’est plus électriquement neutre ; les chimistes les classent en SELS, ACIDES et BASES.

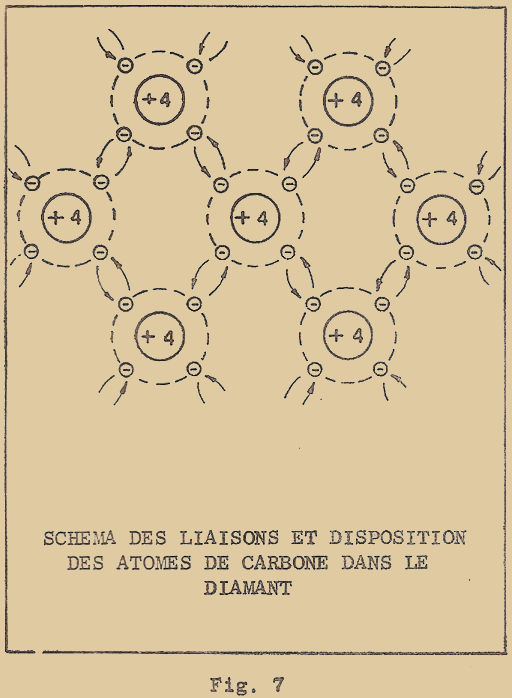

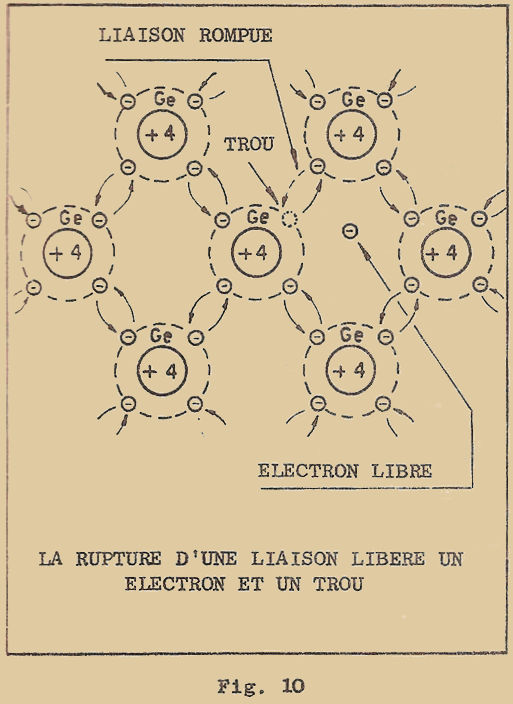

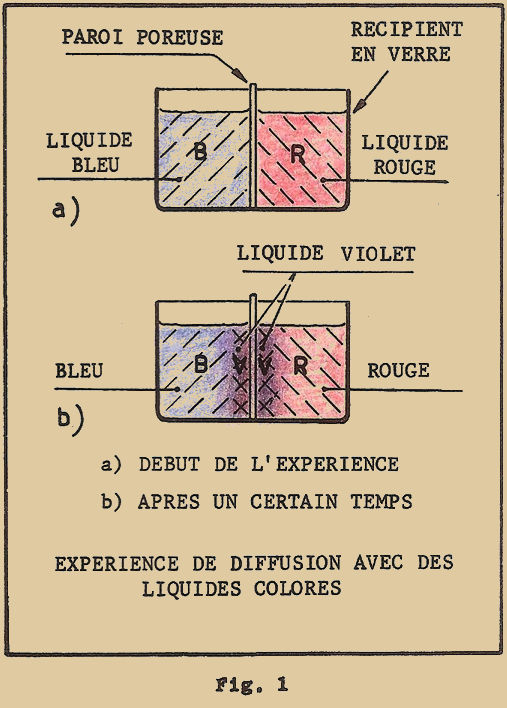

D’autres types de forces de liaison, se manifestent lorsque la substance est constituée d’atomes tous identiques entr’eux, comme c’est le cas pour le germanium, le silicium, le diamant, etc… Naissent alors des forces d’attraction entre atomes, par le fait que les électrons périphériques (c’est-à-dire de valence) d’un atome ne tournent pas toujours autour de leur propre noyau, mais peuvent abandonner leur orbite propre pour passer sur celle des électrons périphériques des atomes voisins.

En d’autres termes, nous pouvons dire que les atomes s’échangent continuellement leurs propres électrons périphériques et que les forces inter-atomiques sont dues à ces échanges. On les appelle des "forces d’échange" ou énergie de cohésion et les liaisons sont dites COVALENTES. Nous verrons ultérieurement l’importance de ces liaisons dans le mécanisme du fonctionnement des semi-conducteurs.

Des forces analogues se manifestent dans le cas des métaux (cuivre, fer, etc…) où les électrons périphériques se déplacent assez librement entre les atomes sans appartenir vraiment à l’un d’eux. Les liaisons inter-atomiques dues à de tels électrons sont dites liaisons métalliques.

1 – 3 SUBSTANCES CRISTALLINES ET AMORPHES

Dans les solides, les atomes peuvent être tous d’un même type, ou bien de deux ou même plusieurs types différents ; ils peuvent non seulement être placés en des positions fixes, mais encore être alignés dans certaines directions privilégiées, et former ainsi ce que l’on appelle Réseau cristallin. La structure cristalline des solides peut être plus ou moins évidente à l’œil selon ses dimensions. Si l’on observe en effet les grains de chlorure de sodium (sels de cuisine) par exemple, obtenus en versant sur une surface lisse de l’eau fortement salée et en laissant évaporer celle-ci, on remarquera qu’ils ont tendance à former des cubes parfaits avec des facettes lisses. Dans d’autres cas (comme par exemple la fonte ou les aciers) les cristaux sont extrêmement petits et s’interpénètrent les uns dans les autres, dans ce cas la structure cristalline ne peut être mise en évidence que par examen au microscope.

Nous avons une autre catégorie de substances solides qui ne présentent aucune trace de cristallisation. De telles substances dont les molécules sont disposées de façon quelconque, sont dits AMORPHES et présentent une particularité très intéressante, typique dans le cas des verres. Si l’on prend un verre à l’état liquide et si on le laisse refroidir, on ne trouvera pas une courbe de température du type de celle de la figure 1, c’est-à-dire avec un palier horizontal (température constante). Ceci signifie que lorsqu’on diminue la température, le verre devient de plus en plus pâteux et dense pour devenir solide à la température ambiante. Mais en réalité il n’y a pas un changement net d’état. Pour cette raison, les substances amorphes sont considérées du point de vue physique comme des liquides extrêmement denses, plutôt que des solides, quoique se comportant comme tels.

1 – 4 CLASSIFICATION DES CRISTAUX

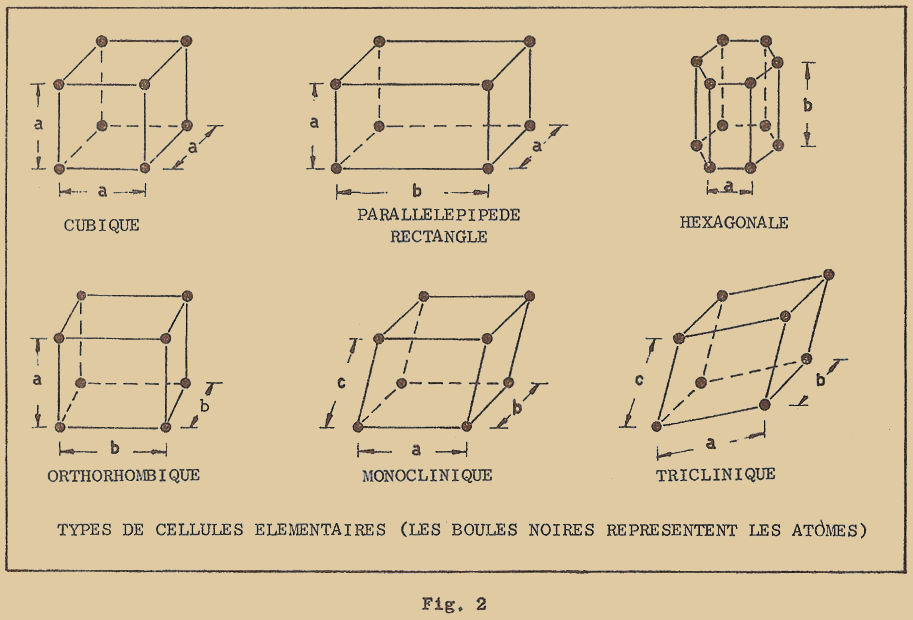

L’étude des cristaux tant du point de vue expérimental à l’aide des rayons X (radiographie) que du point de vue théorique en ce qui concerne les différentes possibilités de structure des atomes, nous amène à considérer que tous les cristaux peuvent être classés en six systèmes différents, chacun d’eux caractérisé par une configuration géométrique particulière à sa cellule élémentaire. Toutes ces configurations particulières sont des solides géométriques élémentaires aux sommets desquels sont placés les atomes et constituent la cellule. Les différents types sont représentés à la figure 2.

Nous avons les types suivants de cellule :

- Cubique : les atomes sont disposés aux sommets d’un cube, ils sont donc tous à la même distance "a" les uns des autres.

- Parallélépipède rectangle : les atomes sont disposés aux sommets d’un parallélépipède à base rectangulaire et se trouvent à des distances "a" et "b".

- Hexagonale : les atomes sont disposés aux sommets d’un prisme à base hexagonale et se trouvent encore à des distances "a" et "b".

- Orthorhombique : les atomes sont disposés aux sommets d’un prisme droit à base en losange et se trouvent à des distances "a" et "b". Monoclinique (ou clinorhombique) : les atomes sont disposés aux sommets d’un parallélépipède non rectangle, à base rectangulaire et se trouvent à des distances "a", "b" et "c".

- Triclinique : les atomes sont disposés aux sommets d’un parallélépipède non rectangle, à base non rectangulaire et se trouvent à des distances "a, b, c".

Chacun des systèmes que nous venons de voir peut être ultérieurement subdivisé en classes secondaires car, entre les sommets, les atomes peuvent se placer aussi au centre des faces ou au centre du solide.

Le système cubique en particulier, qui est celui qui nous intéresse le plus dans l’étude des semi-conducteurs, se présente sous trois espèces de structure cristalline, en plus de celle que je vous ai indiquée à la figure 2 :

-

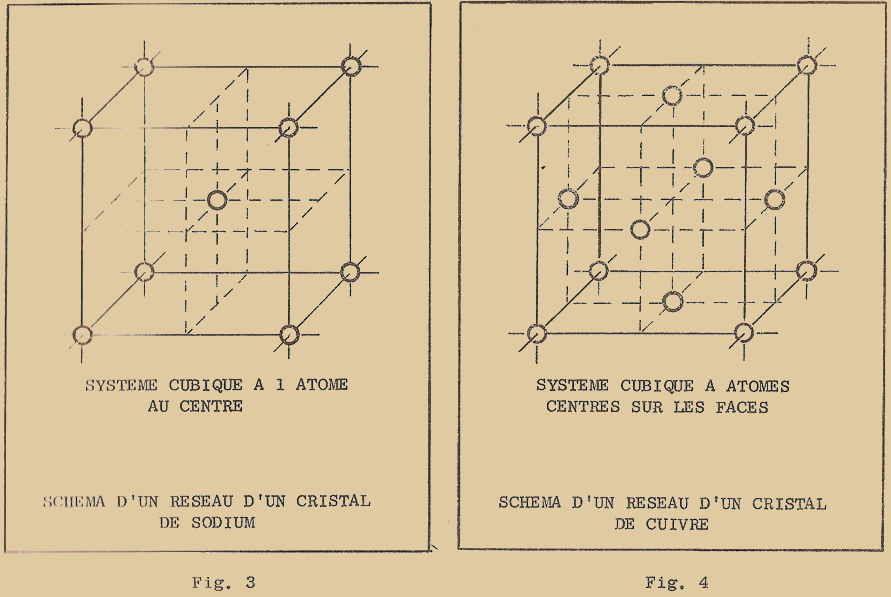

Système cubique où un atome se trouve au centre du cube (figure 3)

Système cubique où un atome se trouve sur chaque face du cube (figure 4)

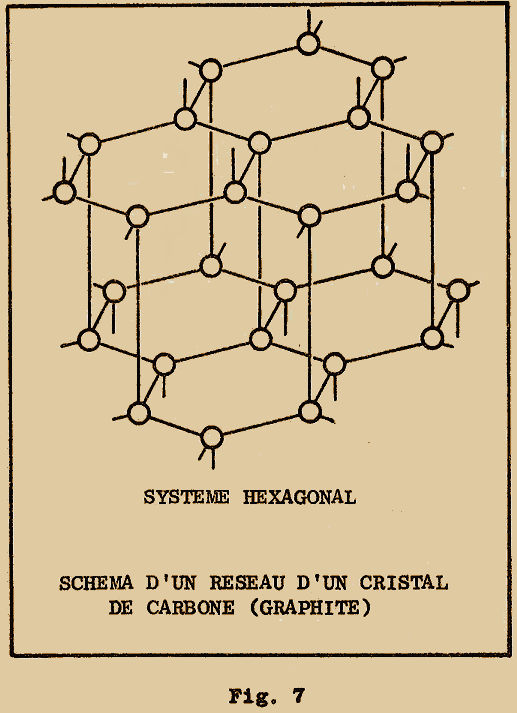

Système cubique tétraèdre ou diamant (figure 6)

Le système cubique où un atome se place au centre du cube est caractéristique des métaux appelés "Alcalins", tels le sodium, le potassium, le lithium. La cellule élémentaire du sodium par exemple a l’aspect indiqué à la figure 3 : les atomes du sodium se trouvent aux sommets d’un cube ainsi qu’au centre de celui-ci.

Les métaux proprement dits, tels que l’aluminium, le cuivre, l’argent, le platine, etc… cristallisent au contraire dans le système cubique, semblable à celui de la figure 4. Les atomes du cuivre par exemple se placent aux sommets d’un cube et au centre de chaque face.

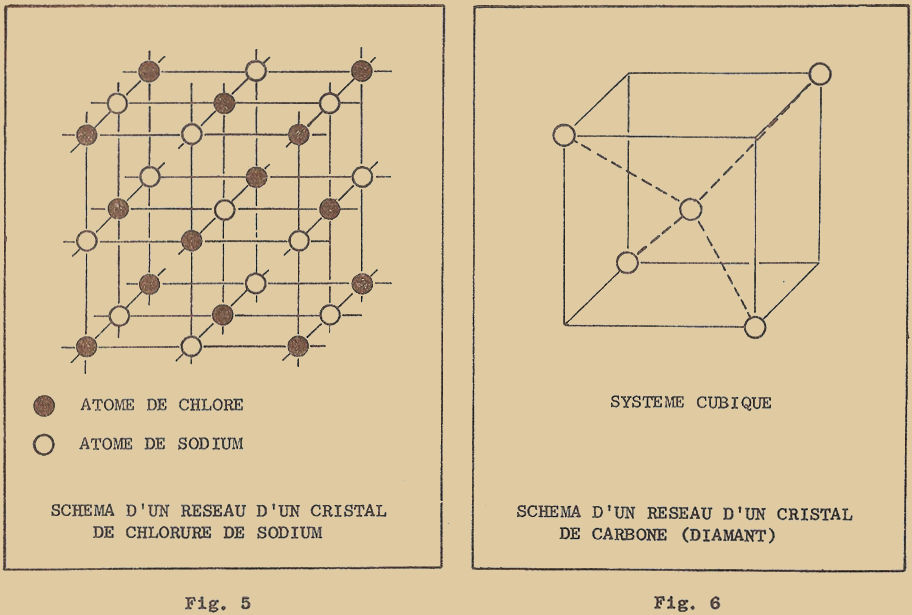

Le chlorure de sodium cristallise aussi dans le système cubique : aux sommets d’un cube se trouvent alternativement un atome de sodium et un atome de chlorure, représentés respectivement par des boules blanches et noires dans la figure 5.

Un autre type de cristal appartenant au système cubique et de très grande importance dans l’étude des semi-conducteurs est celui représenté à la figure 6. Il peut être considéré sous un certain angle comme un dérivé d’une cellule cubique avec un atome au centre, à laquelle on aurait enlevé alternativement 4 des 8 atomes disposés sur les sommets.

Le carbone qui forme le diamant, cristallise dans un tel système (d’où le nom de système cubique diamantaire). Comme vous pouvez le voir à la figure 6, l’atome central de la cellule élémentaire est lié aux 4 atomes disposés aux sommets du cube ; les liaisons sont représentées schématiquement par des lignes en pointillé.

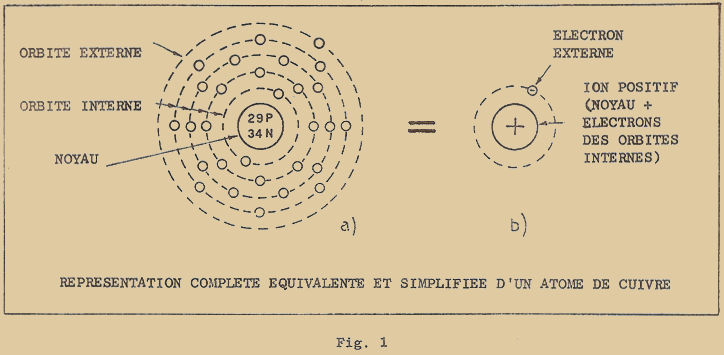

Nous avons aussi des éléments qui peuvent cristalliser dans deux systèmes différents ; c’est le cas par exemple du carbone qui peut cristalliser dans le système cubique diamantaire et également dans le système hexagonal en formant par exemple le graphite. Les atomes de carbone sont alors disposés dans des plans parallèles aux sommets d’un hexagone.

Chaque atome de carbone se trouve encore lié aux 4 atomes, dont 3 seulement se trouvent dans le même plan, tandis que le 4ème se trouve dans un plan adjacent (figure 7).

Il est important de remarquer comment un simple changement dans la disposition des atomes d’un réseau modifie complètement les caractéristiques physiques de la substance. En effet, dans les deux cas que nous venons de voir, les atomes de carbone forment le diamant ou le graphite.

Tandis que le diamant est extrêmement dur, lourd, transparent, incolore et ne conduit pas le courant électrique, le graphite est tendre, léger, opaque, noir et bon conducteur du courant.

Pour avoir une idée sur les distances entre les atomes d’un réseau cristallin, il suffit de se rappeler qu’elles sont mesurées en "microns" (dont le symbole est µ) égal à un millième de millimètre. Dans le cas du cuivre, les atomes sont placés aux sommets d’un cube élémentaire et distant de 0,4mµ seulement ; dans le cas du diamant, la distance est de 0,2 mµ et dans le cas du graphite les atomes sont disposés dans des plans distants de 0,34 mµ environ.

Quelle que soit la structure du cristal, les atomes sont liés les uns aux autres par des forces inter-atomiques intenses. Les atomes ne sont pas immobiles dans le réseau mais, comme je vous l’ai déjà dit, animés d’un mouvement vibratoire autour de leur position de repos, comme le seraient des boules vibrantes reliées les unes aux autres par des fils élastiques. L’amplitude de ces vibrations est très faible et dépend de la température du corps considéré ; plus elle est élevée, plus grandes sont les amplitudes.

Si nous chauffons un corps, les vibrations des atomes (des boules) augmentent de plus en plus et les liaisons qui les unissent (les fils élastiques) sont soumises à des forces de plus en plus grandes. Si la température dépasse une certaine limite (température de fusion) les vibrations des atomes deviennent si intenses que les liaisons se rompent : les atomes peuvent alors se déplacer librement et le corps solide est passé à l’état liquide.

Si au contraire, on refroidit le corps, le mouvement de vibration des atomes devient de moins en moins intense et la structure plus solide. Si l’on calcule la température pour laquelle les atomes deviennent immobiles, on trouve la valeur de –273°C, c’est-à-dire 273°C au-dessous de zéro.

Cette température représente une limite théorique au-dessous de laquelle on ne peut plus descendre : les atomes étant immobilisés on ne peut plus les immobiliser d’avantage.

C’est pour cette raison que la température de –273°C a été prise comme température "à zéro absolu". Pour distinguer les valeurs de température mesurées à partir du zéro absolu de celles mesurées à partir du zéro conventionnel (température de la glace fondante) on a décidé de les mesurer en degrés KELVIN (en l’honneur du physicien anglais Lord Kelvin) dont le symbole est °K.

Pour passer des valeurs conventionnelles de température, aux valeurs absolues il suffit simplement d’ajouter 273. Par exemple :

0°C = 0 + 273 = 273°K

25°C = 25 + 273 = 298°K

100°C = 100 + 273 = 373°K

Nous dirons que la glace fond à 273° absolus et que l’eau bout à 373° absolus.

Le passage inverse se fait, évidemment en soustrayant 273°. Ainsi par exemple :

300°K = 300 – 273 = 27°C

183°K = 183 – 273 = - 90°C

L’échelle des températures absolues est utilisée couramment dans l’étude de tous les phénomènes qui dépendent de la température, car les calculs viennent à être simplifiés dans quelques cas particuliers que nous verrons dans les prochaines leçons. Par contre, pour exprimer les températures normales, celles que l’on rencontre dans la vie quotidienne (température atmosphérique, etc…) il est plus commode d’utiliser l’échelle conventionnelle, c’est-à-dire parler en degrés Celsius.

RÉPONSES AUX EXERCICES DE RÉVISION SUR LA 1ère LEÇON THÉORIQUE

1 – On appelle molécule la plus petite partie d’un composé chimique qui possède encore toutes les propriétés chimiques de celui-ci.

2 – L’atome est la particule d’un élément chimique qui forme la plus petite quantité susceptible de se combiner.

3 – La valence d’un élément est exprimée par le nombre d’atomes d’hydrogène qui peuvent ou pourraient se combiner avec l’élément considéré

4 – La masse atomique exprime de combien de fois l’atome considéré est plus lourd que l’atome d’hydrogène.

5 – Les atomes sont formés par des électrons, dont la charge est négative et le poids extrêmement faible, par des protons, dont la charge est positive et le poids relativement grand (par rapport à celui des électrons) et par des neutrons, électriquement neutres et dont le poids est la somme de ceux d’un proton et d’un électron.

6 – On peut représenter un atome de façon schématique par un noyau (formé de protons et de neutrons) autour duquel tournent des électrons sur des orbites plus ou moins éloignées.

7 – Le nombre d’électrons et de protons est toujours égal au nombre atomique ; l’atome considéré est donc formé de 17 électrons et de 17 protons, le nombre de neutrons est au contraire donné par la différence entre la masse atomique et le nombre atomique, et sera donc 35–17=18.

8 – Le nom d’électron de valence est donné aux seuls électrons de l’orbite externe (électrons périphériques) parce que ce sont eux seuls qui interviennent dans les réactions chimiques et que leur nombre dépend la valence.

9 – Les isotopes d’un élément diffèrent uniquement par leur masse atomique, c’est-à-dire par le nombre de neutrons contenus dans le noyau de leurs atomes.

EXERCICES DE RÉVISION SUR LA 2ème LEÇON THÉORIQUE

1 – Quels sont les états de la matière et combien en connaissez-vous ?

2 – Comment définit-on la température de fusion d’une substance ?

3 – Comment est définie par convention l’échelle Celsius ?

4 – Quels sont les différents types de force inter-atomiques et inter-moléculaires ?

5 – Qu’appelle-t-on réseau cristallin ?

6 – En combien de classes différentes, peut-on subdiviser le système cubique et comment les distingue-t-on ?

7 – Quelles sont les différences de formation d’un diamant et d’un graphite ?

8 – Comment se comportent les molécules d’un liquide par rapport à celles d’un solide ?

9 – A combien de degrés Celsius correspond le zéro de l’échelle Kelvin et pourquoi l’appelle-t-on le zéro absolu ?

Fin de la leçon 2

LECON 3

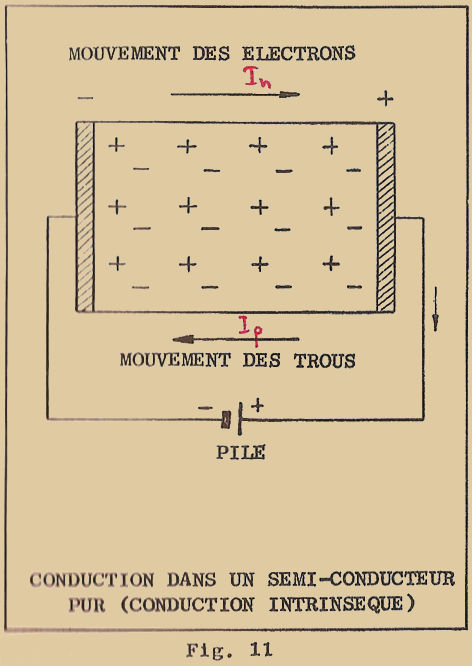

1 – PHÉNOMÈNE DE LA CONDUCTION ÉLECTRIQUE

Il est désormais admis que le courant électrique est constitué par un flux de charges électriques qui se déplacent sous l’action d’une force produite par un champ électrique. Dans les conducteurs solides, en particulier dans les métaux, les charges sont des électrons, c’est-à-dire négatives. Dans les liquides conducteurs les charges électriques sont constituées par des ions positifs et négatifs. Dans le premier cas, nous avons un courant électronique et le conducteur est dit de "première espèce". Dans le second cas, nous avons un courant ionique et le conducteur est dit de "seconde espèce".

1 – 1 CONDUCTEURS ET ISOLANTS

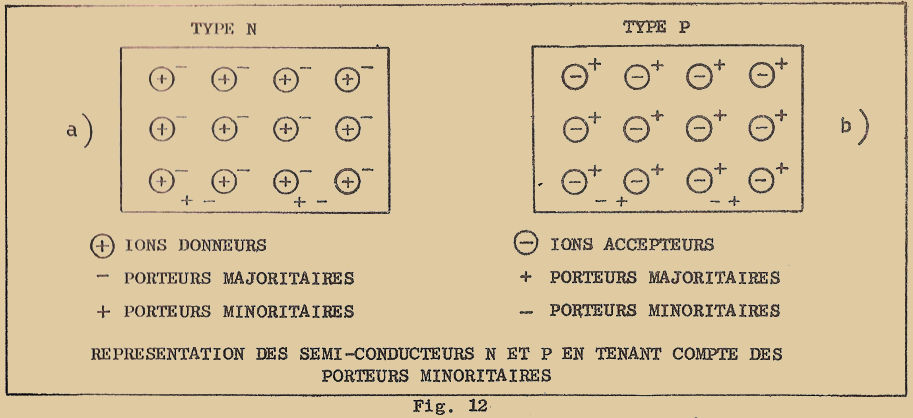

Les propriétés électriques et chimiques d’un matériau dépendent exclusivement de la configuration des atomes qui le constituent et de la manière suivant laquelle ils sont liés entr’eux ; en particulier, l’aptitude du matériau à conduire le courant électrique dépend des électrons de l’orbite périphérique, c’est-à-dire des électrons "de valence". En effet, comme je vous l’ai dit, le courant électrique est constitué d’un mouvement ordonné de charges électriques négatives (électrons) dans le conducteur ; il y a donc possibilité pour les électrons de passer d’un atome à un autre. Je vous ai dit aussi que seuls les électrons de l’orbite externe pouvaient être facilement cédés par les atomes et ce sont donc eux qui constituent le flux de courant. On peut donc dire qu’un matériau est un bon conducteur si ses atomes peuvent céder facilement des électrons, tandis qu’un bon isolant peut au contraire être défini comme un matériau à qui on ne peut arracher facilement les électrons de ses atomes.

En se rappelant ce qui a été dit dans les précédentes leçons, on peut donc prévoir que seront de bons conducteurs de courant les éléments qui ont un seul électron périphérique, car ils pourront le "lâcher" facilement.

Si nous regardons la table de Mendeleïev (voir leçon théorique 1 figure 4), nous verrons que parmi les éléments de la première colonne, nous avons le cuivre (Cu), l’argent (Ag) et l’Or (Au) qui sont les meilleurs conducteurs, c’est-à-dire des matériaux qui opposent la plus faible résistance au passage du courant électrique.

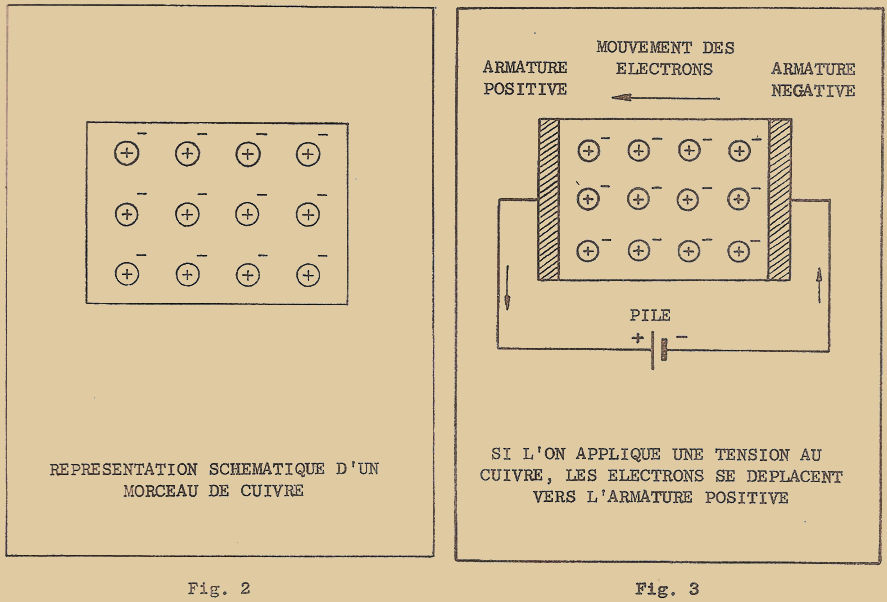

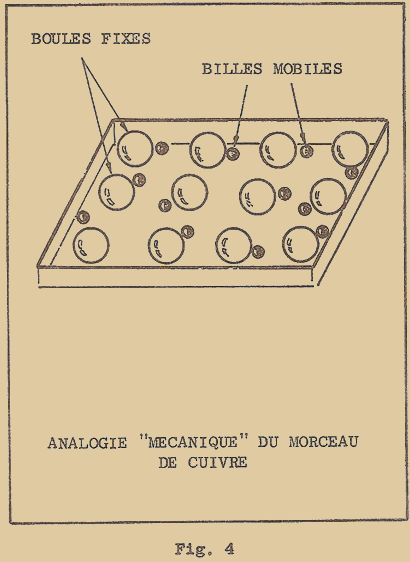

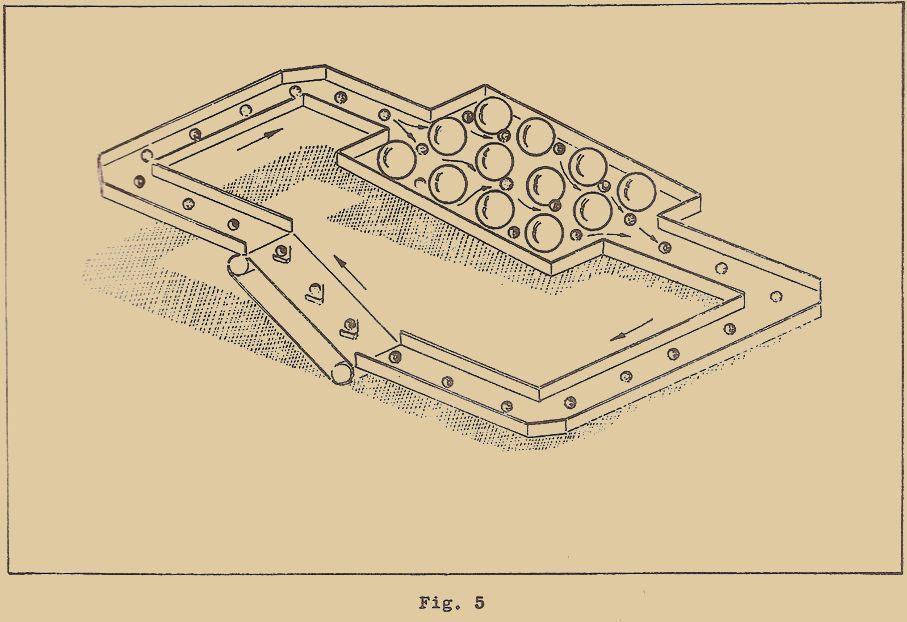

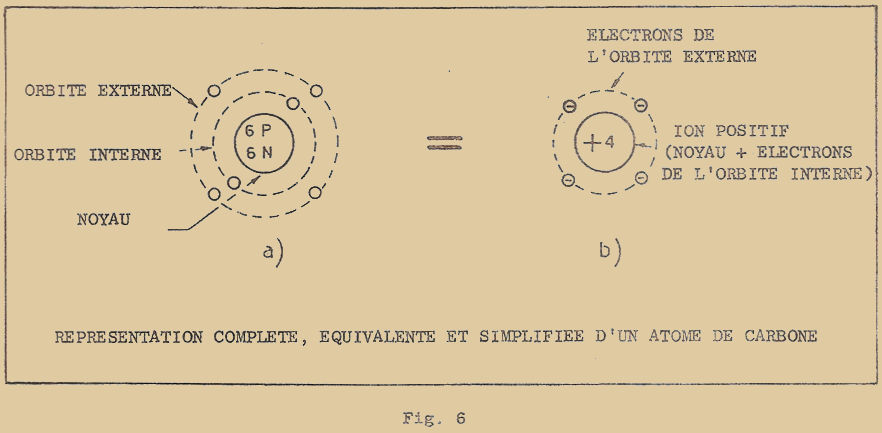

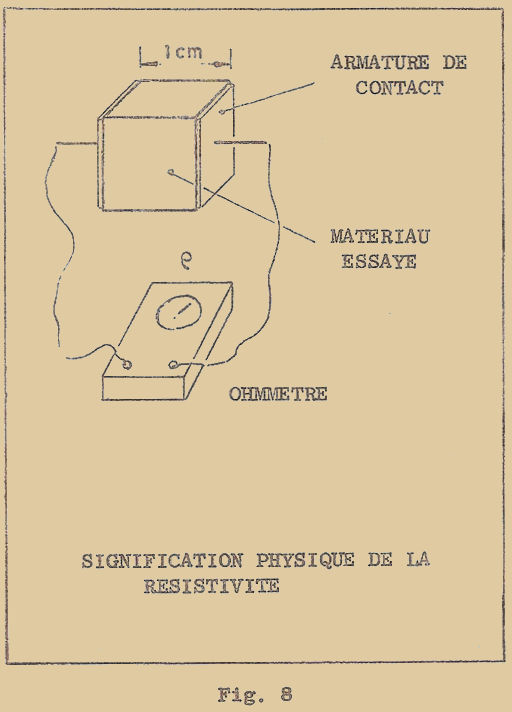

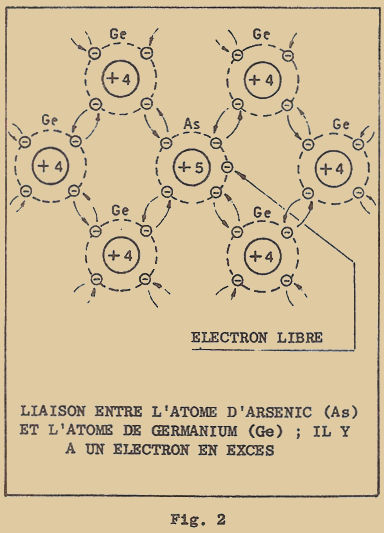

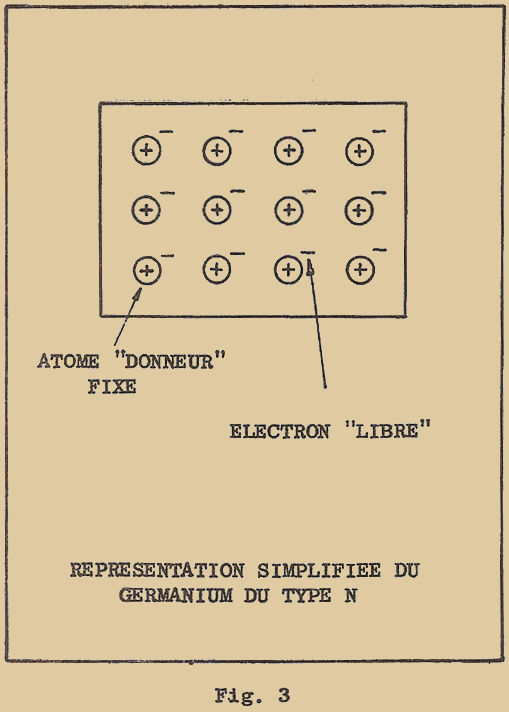

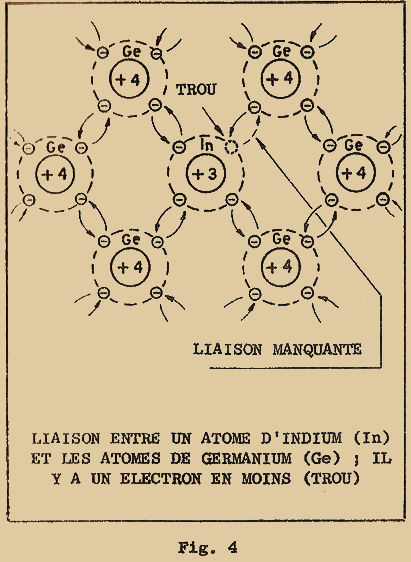

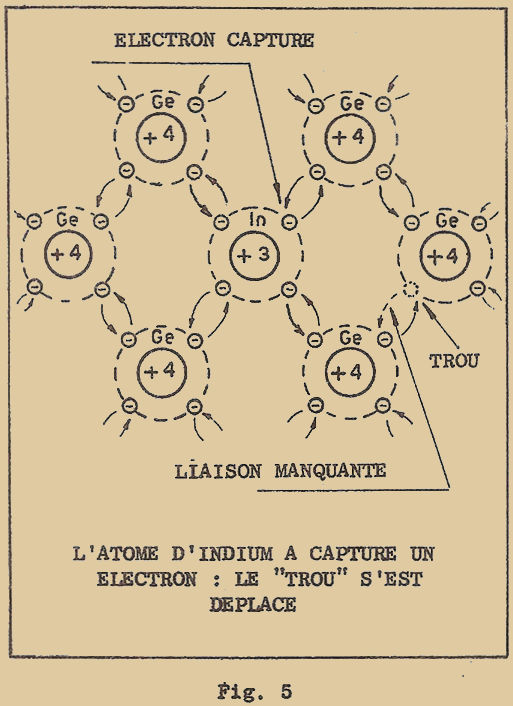

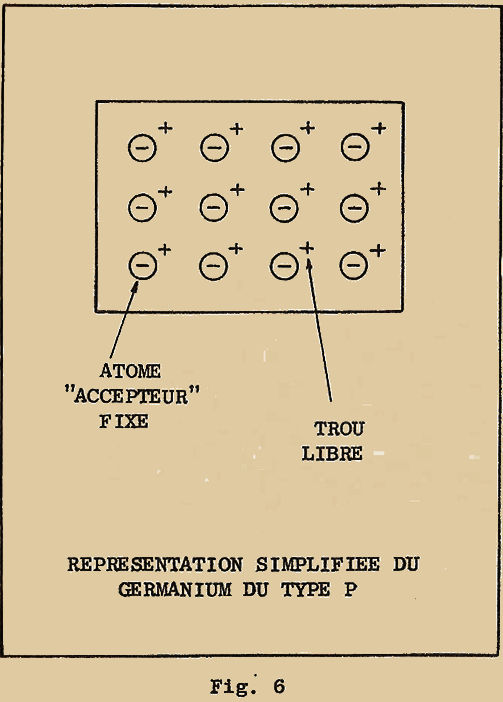

Pour étudier le phénomène de la conduction d’un matériau (pour simplifier, nous ne considérerons que les éléments simples), il faut encore considérer leur structure atomique, de façon limitée d’ailleurs car ce qui nous intéresse ce sont les électrons qui prennent une part active au phénomène de conduction. Nous n’avons donc pas besoin de représenter les atomes avec tous les électrons sur les différentes orbites mais il suffira simplement de mettre en évidence ceux de l’orbite externe.